探究学习表示中的因果关系

PDF格式 | 12.5MB |

更新于2025-01-16

| 192 浏览量 | 举报

"学习表示是否尊重因果关系"

在计算机视觉和机器学习领域,数据中的属性往往具有因果关系。例如,一个人的性别可能会影响他们是否有面部毛发,或者是否佩戴眼镜。这种因果关系在图像数据中是显而易见的,但当我们训练模型学习这些属性的表示时,模型是否能够捕捉并尊重这些内在的因果结构呢?这是一个重要的问题,因为它关系到模型的解释性和泛化能力。

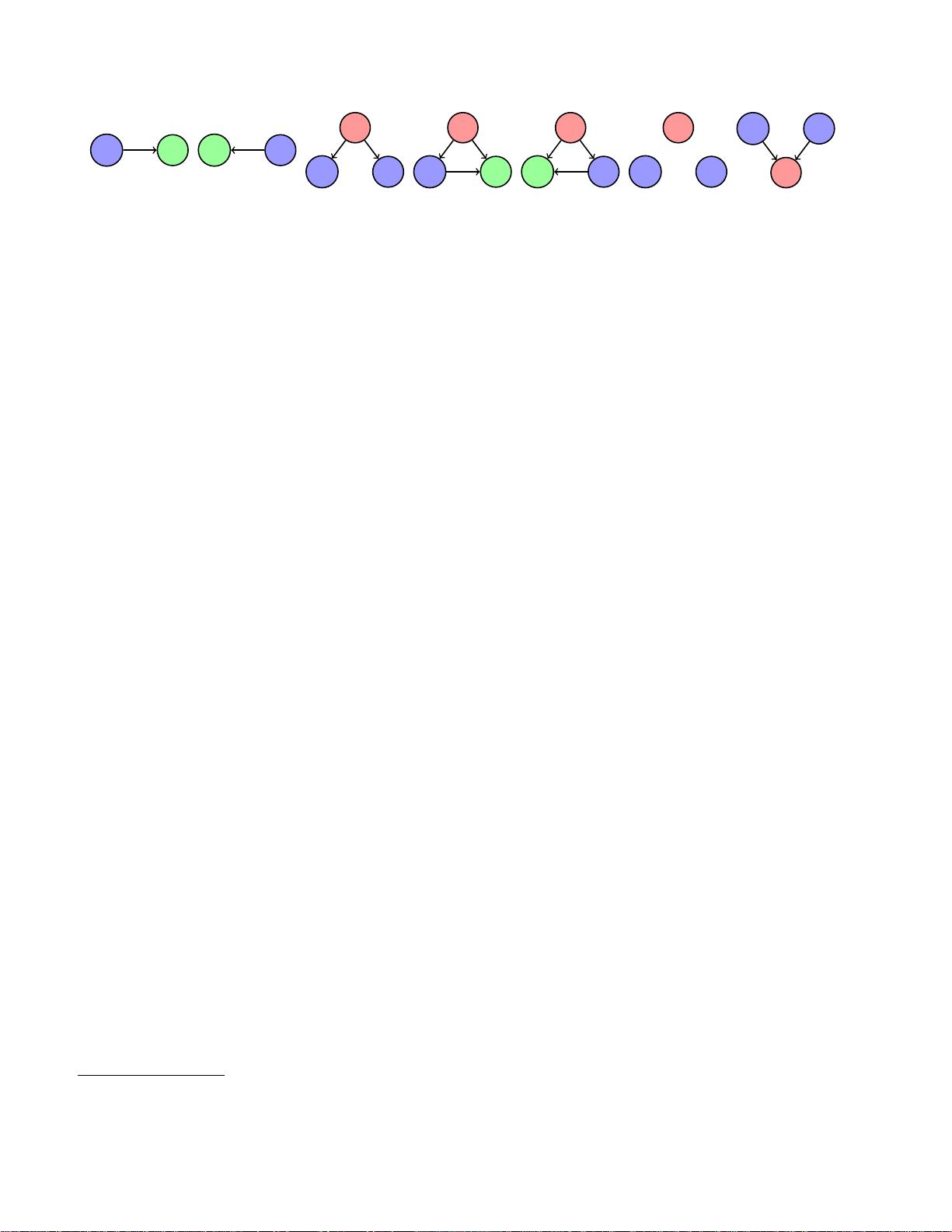

标题"学习表示是否尊重因果关系"指向的研究正是探讨这个问题。研究由Lan Wang和Vishnu Naresh Boddeti在密歇根州立大学进行,他们提出了一种名为NCINet的方法,专门用于从高维数据中检测因果关系。NCINet的独特之处在于它仅使用合成生成的表示进行训练,然后可以应用于真实数据,目的是减少合成与真实表示之间的领域差距。

NCINet的应用包括识别图像表示之间的因果关系,这些关系可以从已知或未知的属性标签中推断出来。研究者在3D Shapes、CelebA和CASIA-WebFace等数据集上测试了这种方法,这些数据集包含丰富的多类属性注释。通过这些实验,他们分析了表示学习的不同设计选择如何影响潜在因果关系的形成。

实验结果表明,NCINet在估计样本对之间的因果关系方面显著优于其他现有的观测因果发现方法,即使在存在未观察到的混淆因素的情况下也是如此。此外,研究还发现,在受控条件下,学习的表示确实反映了其标签间的潜在因果关系,并且因果关系与表示的预测性能呈正相关。这表明尊重因果关系的表示可以提高模型的预测准确性和对现实世界的适应性。

这个工作的重要性在于,它不仅提供了一种检测和利用因果关系的新方法,还强调了在深度学习模型中考虑因果结构的必要性。这有助于我们构建更鲁棒、更可解释的AI系统,对于提升人工智能在现实世界中的应用有着深远的影响。相关代码和数据集的注释可以在https://github.com/human-analysis/causal-relations-between-representations找到,供进一步研究和实践使用。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 易酷免费影视系统:开源网站代码与简易后台管理

- Coursera美国人口普查数据集及使用指南解析

- 德加拉6800卡监控:性能评测与使用指南

- 深度解析OFDM关键技术及其在通信中的应用

- 适用于Windows7 64位和CAD2008的truetable工具

- WM9714声卡与DW9000网卡数据手册解析

- Sqoop 1.99.3版本Hadoop 2.0.0环境配置指南

- 《Super Spicy Gun Game》游戏开发资料库:Unity 2019.4.18f1

- 精易会员浏览器:小尺寸多功能抓包工具

- MySQL安装与故障排除及代码编写全攻略

- C#与SQL2000实现的银行储蓄管理系统开发教程

- 解决Windows下Pthread.dll缺失问题的方法

- I386文件深度解析与oki5530驱动应用

- PCB涂覆OSP工艺应用技术资源下载

- 三菱PLC自动调试台程序实例解析

- 解决OpenCV 3.1编译难题:配置必要的库文件