ChamNet: 平台感知神经网络架构优化

187 浏览量

更新于2025-01-16

收藏 975KB PDF 举报

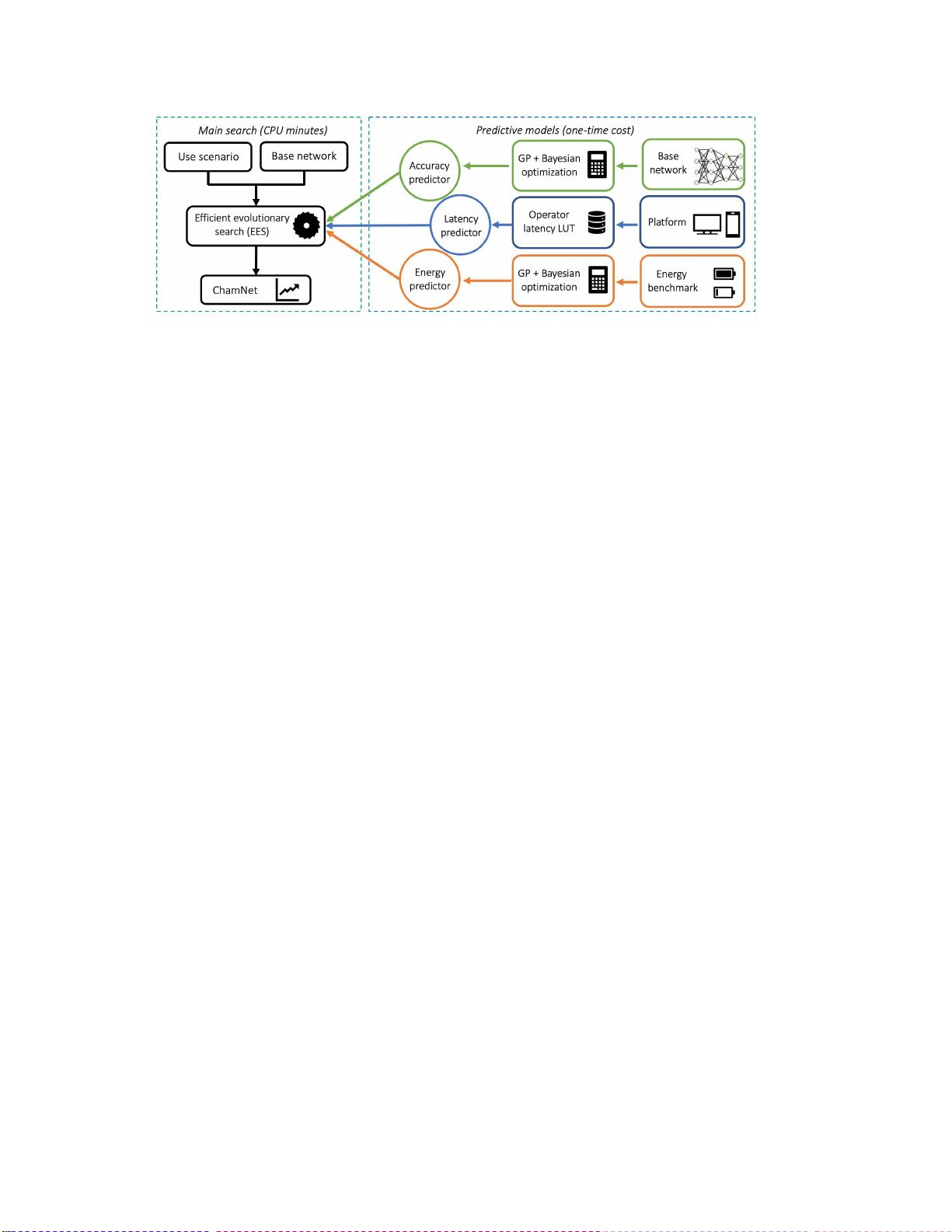

ChamNet: 一种创新的平台感知神经网络(NN)架构设计方法,由戴晓亮等人提出,旨在解决在资源受限的设备上部署深度学习模型的挑战。不同于传统的构建新块或依赖于计算密集型强化学习,ChamNet侧重于现有高效网络组件的利用,并通过智能调整计算资源来适应目标的延迟和能耗约束。

核心亮点是该方法采用了一个精度预测器,基于高斯过程和贝叶斯优化的迭代采样策略。这个预测器允许算法在几分钟内生成先进的模型架构,满足指定的硬件限制。其优势在于,一次性构建预测器的成本使得整个搜索过程高效且快速。

实验结果显示,ChamNet在保持模型先进性的前提下,显著提高了准确性。例如,在移动CPU和DSP上,它实现了73.8%和75.3%的ImageNet top-1精度,与MobileNetV2和MnasNet相比,分别有8.2%和4.8%的提升,即使在降低延迟条件下也能保持较高的性能。在Nvidia GPU和Intel CPU上,与ResNet-101和ResNet-152相比较,ChamNet分别提升了2.7%和5.6%的精度,证明了其在不同平台上的通用性和优化效果。

ChamNet的研究背景强调了针对特定硬件平台进行模型设计的重要性,因为不同的硬件有着独特的特性和限制。尽管已有紧凑模型如[24, 21]减少了计算成本,但在实际部署中,单一的模型结构往往难以兼顾所有平台的需求。ChamNet的方法通过平台感知,为解决这一问题提供了一种有效且高效的解决方案。通过集成现有高效构建块和智能资源管理,ChamNet展示了在资源约束条件下,如何实现模型性能的显著提升,从而推动了在移动设备和其他资源受限环境下的深度学习应用发展。

2025-03-06 上传

2025-03-06 上传

2025-03-06 上传

2025-03-06 上传

cpongm

- 粉丝: 6

最新资源

- Verilog实现的Xilinx序列检测器设计教程

- 九度智能SEO优化软件新版发布,提升搜索引擎排名

- EssentialPIM Pro v11.0 便携修改版:全面个人信息管理与同步

- C#源代码的恶作剧外表答题器程序教程

- Weblogic集群配置与优化及常见问题解决方案

- Harvard Dataverse数据的Python Flask API教程

- DNS域名批量解析工具v1.31:功能提升与日志更新

- JavaScript前台表单验证技巧与实例解析

- FLAC二次开发实用论文资料汇总

- JavaScript项目开发实践:Front-Projeto-Final-PS-2019.2解析

- 76云保姆:迅雷云点播免费自动升级体验

- Android SQLite数据库增删改查操作详解

- HTML/CSS/JS基础模板:经典篮球学习项目

- 粒子群算法优化GARVER-6直流配网规划

- Windows版jemalloc内存分配器发布

- 实用强大QQ机器人,你值得拥有