利用视频时长学习的无监督高光检测提升浏览效率

PDF格式 | 1.67MB |

更新于2025-01-16

| 31 浏览量 | 举报

视频高光检测是一种新兴的计算机视觉技术,旨在通过自动化分析,从大量的用户生成视频中识别出最具吸引力或关键的片段,从而简化视频浏览体验。传统的视频浏览面临海量内容的挑战,用户往往难以找到他们真正感兴趣的瞬间。高光检测通过学习视频的持续时间,提出了一种无监督的解决方案,利用用户行为模式作为隐含的监督信号。

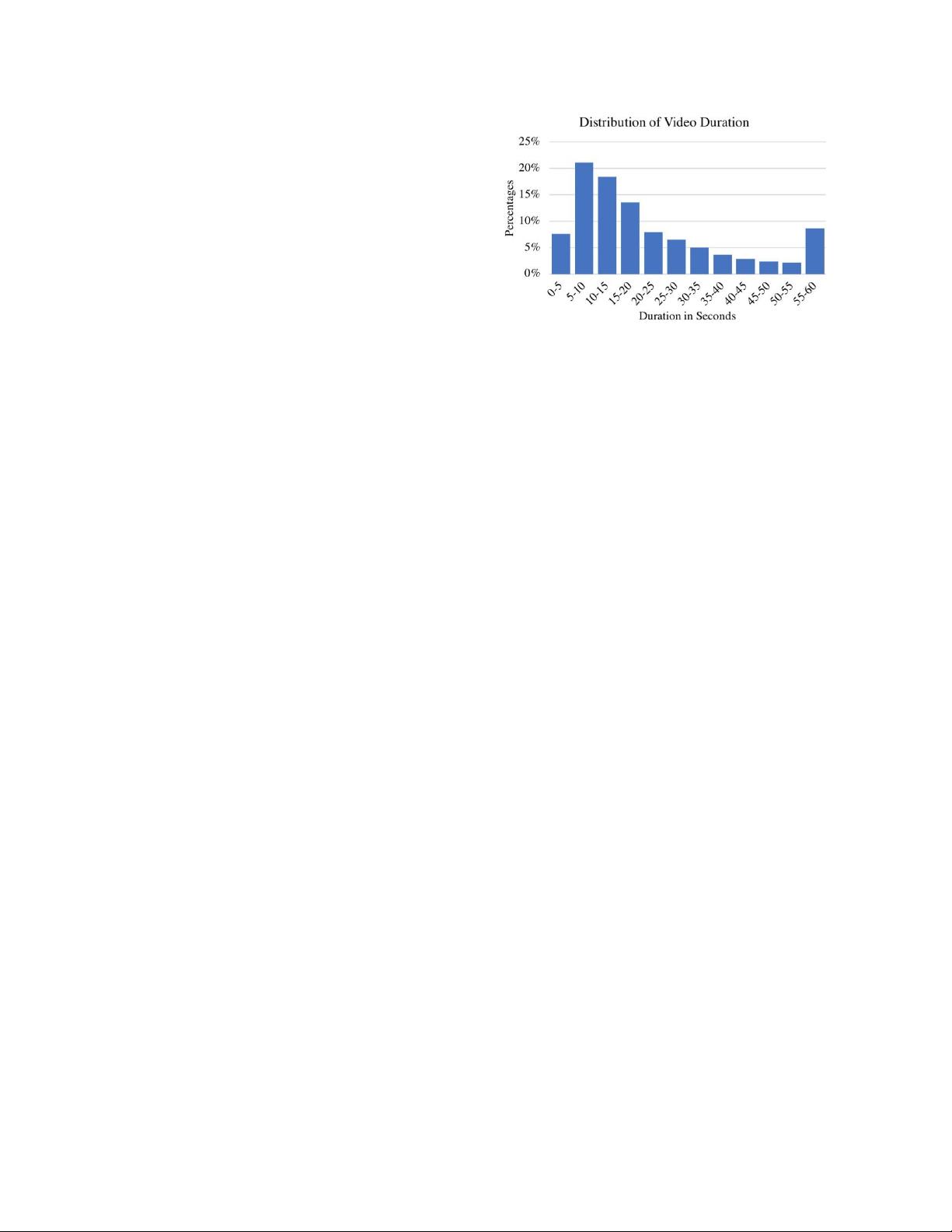

关键的创新点在于,研究者观察到用户在拍摄较短的视频时,往往更加聚焦和有针对性,因此这些片段更可能包含精华内容。基于这个洞察,他们设计了一种新的排名框架,给予较短视频片段更高的权重,以此作为训练亮点检测器的指导。这种方法利用了来自Instagram上亿个标签的视频数据,以大规模无监督的方式进行训练。

实验结果显示,这种方法在两个具有挑战性的公共视频亮点检测基准上实现了显著的性能提升,超越了先前的无监督方法。这不仅提高了视频内容的索引和组织效率,而且能够帮助用户快速发现视频中的亮点,加快浏览速度,同时也能提升社交媒体分享的互动性和推荐系统的精准度。

在实际应用中,视频高光检测技术可用于个性化推荐、广告定向、社交媒体过滤等场景,帮助用户更好地理解和消费海量视频内容。未来的研究可能会探索更多的监督和强化学习策略,以及如何结合其他上下文信息,如用户的兴趣和行为历史,来进一步优化高光检测的准确性。

相关推荐

cpongm

- 粉丝: 6

最新资源

- C#实现程序A的监控启动机制

- Delphi与C#交互加密解密技术实现与源码分析

- 高效财务发票管理软件

- VC6.0编程实现删除磁盘空白文件夹工具

- w5x00-master.zip压缩包解析:W5200/W5500系列Linux驱动程序

- 数字通信经典教材第五版及其答案分享

- Extjs多表头设计与实现技巧

- VBA压缩包子技术未来展望

- 精选多类型导航菜单,总有您钟爱的一款

- 局域网聊天新途径:Android平台UDP技术实现

- 深入浅出神经网络模式识别与实践教程

- Junit测试实例分享:纯Java与SSH框架案例

- jquery xslider插件实现图片的流畅自动及按钮控制滚动

- MVC架构下的图书馆管理系统开发指南

- 里昂理工学院RecruteSup项目:第5年实践与Java技术整合

- iOS 13.2真机调试包使用指南及安装