训练集)被完全标记用于每个相机视图。这对于在城

市应用中典型的具有数百个摄像机和24/7操作的Re-ID

任务来说仍然是不切实际的

为了 实现 有 效的Re-ID, 给 定注释 的有 限 预算成

本,我们专注于人在回路中的人Re-ID,其具有通过人

的实时反馈进行的选择性标记[43]。这种方法不同于

常见的一次性模型学习方法。相反,一个逐步的顺序

主动学习过程,通过探索人类的选择性注释上的一个

小得多的样本池模型学习。这些通过人工二进制验证

的累积标记数据用于更新模型训练以改善Re-ID性能。

这种模型学习的方法自然适合于强化学习和主动学

习,这是这项工作的重点。

主动学习是一种用于即时人类数据注释的技术,其

旨在主动采样更具信息性的训练数据,以优化模型学

习,而无需过度的数据标记。形式上,从未标记的集

合中选择一些实例,然后由人类预言机进行注释,并

且标签信息可以用于模型训练。这些操作将重复多

次,直到它满足终止标准,例如注释build-get已耗尽。

在这个过程中最关键的是样本选择策略。来自较少人

工注释成本的更多信息样本可以极大地有益于性能。

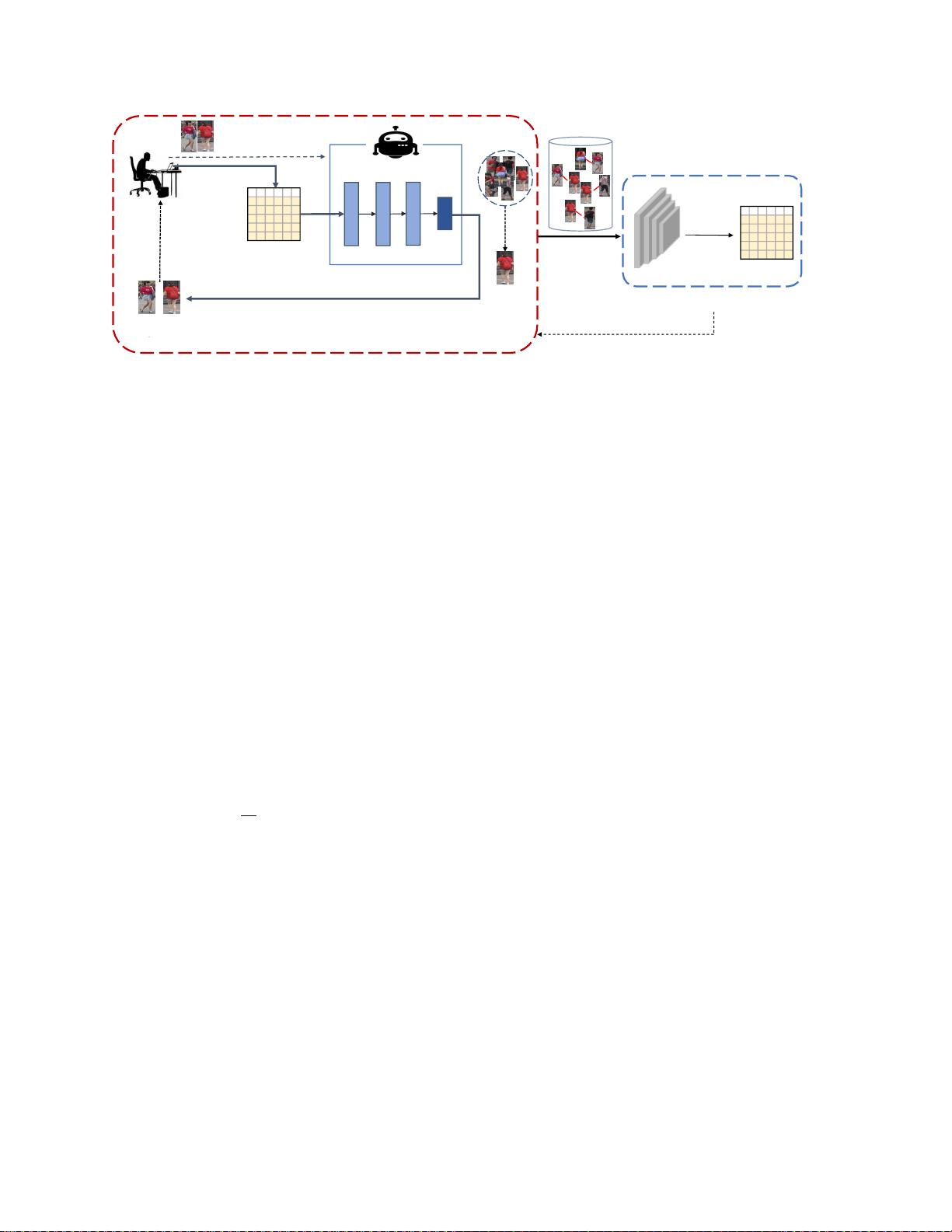

我们提出了一个基于强化学习的标准,而不是手工设

计策略图1展示了我们对深度强化主动学习(DRAL)

模型的设计。具体来说,我们开发了一个模型,在一

个单一的人在环模型学习框架中引入主动学习(AL)

和强化学习(RL)。通过将我们模型的AL部分表示为

序列生成过程,由于每个动作影响未标记数据池之间

的样本相关性(在每个步骤中重新计算相似性),因

此它将影响下一步的决策通过将所选样本带来的不确

定性作为客观目标,我们模型的RL部分旨在学习一个

强大的样本选择策略,给出人类反馈注释。因此,从

RL策 略中选 择的信 息样 本可以显著提高Re-ID的性

能,从而增强样本选择策略的能力。迭代训练方案将

导致强Re-ID模型。

这项工作的主要贡献是:(1)我们引入了一个深

度强化主动学习(DRAL)模型,该模型旨在在单个

CNN深度学习框架中联合探索强化学习和主动学习原

理。 (2)我 们为人在环 人员 Re-ID设 计了一个有 效的

DRAL模型,使得深度强化主动学习器(代理)可以

直接在CNN深度网络上促进人在环主动学习策略大量

的对比实验清楚地表明,

所提出的DRAL模型在可伸缩性和注释成本方面优于

现有的监督和转移学习方法,优于现有的半监督、非

监督和主动学习方法,具有显著的性能增益,同时使

用少得多的注释。

2.

相关工作

人员重新识别

Person

Re-ID任务旨在在多个摄像机视图

中搜索相同的人。最近,大多数人都采用Re-ID方法

[50,45,8,10,33,38,7,53,19,5,

51, 9,39,36]尝试在监督学习框架下解决这个问

题,其中训练数据被完全注释。尽管这些方法实现了

高性能,但它们的大注释成本不容忽视。为了解决标

签成本高的问题,一些研究人员提出只使用少量标签

样本或不使用任何标签信息来学习模型。代表性算法

[32,48,2,55,23,44,28,46]包括域转移方案、

组关联方法和一些标签估计方法。

除了上述方法之外,一些研究人员旨在减少人在回

路(HITL)模型学习过程中的注释成本。当只有少量

带注释的图像样本时,HITL模型学习可以通过在模型

训练、调整或测试的循环中直接涉及人类交互来提高

模型性能。随着人类群体校正机器学习预测中发生的

不准确性,模型可以被有效地校正,从而导致更高的

结果。这种情况听起来类似于人员Re-ID任务的情况,

其预标记信息难以在图库候选大小远远超过查询锚的

图库候选大小的情况下获得。受此启发,Wang

等人。

[43]制定了一种人类验证增量学习(HVIL)模型,旨

在通过灵活的人类反馈实时连续优化距离度量。该模

型采用灵活的人工反馈(真、假、假但相似),能够

涉及更多的信息,并以渐进的方式提高性能。

AL

和

RL

。 主动学习引起了人们的广泛关注 在过去

的几十年里,它已经在自然语言处理(NLP)、数据

标注和图像分类中得到了广泛的应用,

任务[41,6,4,31]。它的过程可以被认为是人在环

设置,这允许算法交互式地查询人类注释者,其中实

例被识别为整个未标记数据池中信息量最大的样本。

这一工作通常是通过使用一些启发式的选择方法,效

果有限因此,一些研究人员旨在通过将主动学习框架

为强化学习问题来明确优化选择策略来解决启发式选

择方法 [15]而不是采用,