FocusCut:交互式图像分割中的焦点视图技术

PDF格式 | 14.22MB |

更新于2025-01-16

| 39 浏览量 | 举报

FocusCut:对象细节细化的焦点视图

在计算机视觉和图像处理领域中,交互式图像分割是一种重要的工具,旨在以最小的交互成本获得目标对象的准确二值掩码。当前的方法将用户的交互点击视为共同确定全局预测的指导,但这种方法存在一些缺陷,例如忽视了用户的意图和细节信息。为了解决这些问题,本文提出了一个名为FocusCut的方法,它集成了对象分割和局部细化的功能,通过重新赋予点击视图在对象细节中的决定性作用,实现了高精度的二值分割掩码。

在FocusCut方法中,作者首先获得了全局预测,然后从原始图像中以自适应范围裁剪以点击为中心的补丁,逐步细化局部预测。这种方法可以在不增加用户感知和参数的情况下,达到最先进的结果。大量的实验证明了FocusCut使得交互式图像分割的超精细分割成为可能。

在交互式图像分割中,用户的交互模式是非常重要的。当前的研究主要集中在两个方面:一方面是更高效的用户交互模式,另一方面是更有效地利用用户提供的交互。基于点击的方法由于其简单性已经成为主流,研究人员也探索了交互的模糊性、输入信息、反向传播等方法来提高分割结果。

此外,随着大屏设备的增加和审美水平的提高,图像标注和图像编辑都需要更精细的分割掩码。在高精度交互分割中,对象细节的细化,如边缘和孔洞,通常需要更多的交互点击和时间。当用户在错误标记的区域点击时,他们倾向于将注意力集中在细节区域,例如边缘和孔洞,以进行有效的细化。

FocusCut方法的提出为交互式图像分割提供了一种新的解决方案,通过重新赋予点击视图在对象细节中的决定性作用,实现了高精度的二值分割掩码。这种方法可以广泛应用于图像标注、图像编辑、计算机视觉等领域,提高了图像处理的精度和效率。

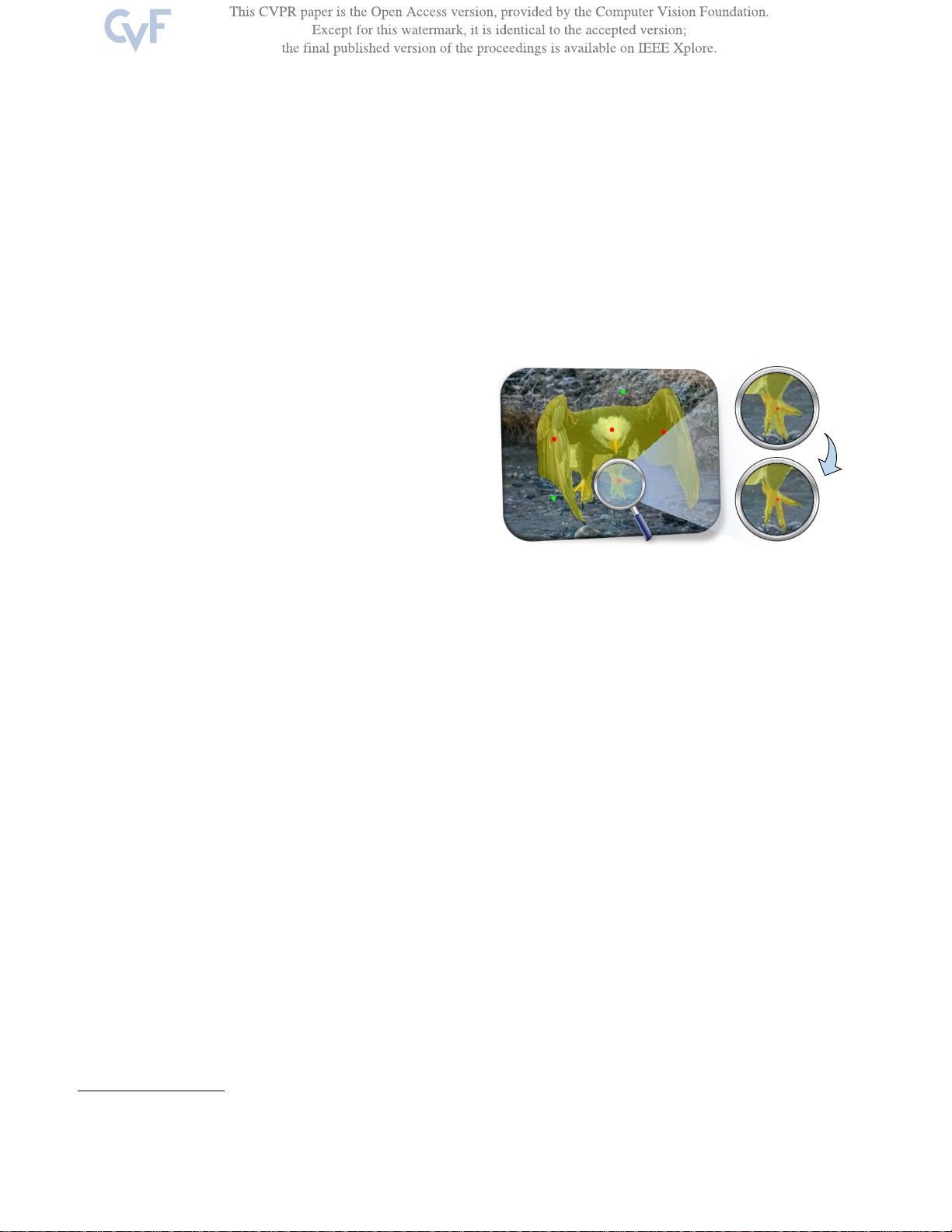

在FocusCut方法中,作者还提供了一种可视化展示的方式,通过额外的焦点视图对鹰爪的细节进行了修复。红色和绿色的点击是用户在交互分割中用来指示前景和背景的。黄色的遮罩是预测结果。这种可视化展示方式可以帮助用户更好地理解交互式图像分割的过程和结果。

FocusCut方法为交互式图像分割提供了一种新的解决方案,通过重新赋予点击视图在对象细节中的决定性作用,实现了高精度的二值分割掩码。这种方法可以广泛应用于图像标注、图像编辑、计算机视觉等领域,提高了图像处理的精度和效率。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 初学者入门必备!Visual C++开发的连连看小程序

- C#实现SqlServer分页存储过程示例分析

- 西门子工业网络通信例程解读与实践

- JavaScript实现表格变色与选中效果指南

- MVP与Retrofit2.0相结合的登录示例教程

- MFC实现透明泡泡效果与文件操作教程

- 探索Delphi ERP框架的核心功能与应用案例

- 爱尔兰COVID-19案例数据分析与可视化

- 提升效率的三维石头制作插件

- 人脸C++识别系统实现:源码与测试包

- MishMash Hackathon:Python编程马拉松盛事

- JavaScript Switch语句练习指南:简洁注释详解

- C语言实现的通讯录管理系统设计教程

- ASP.net实现用户登录注册功能模块详解

- 吉时利2000数据读取与分析教程

- 钻石画软件:从设计到生产的高效解决方案