10

1

10

2

10

3

10

4

10

5

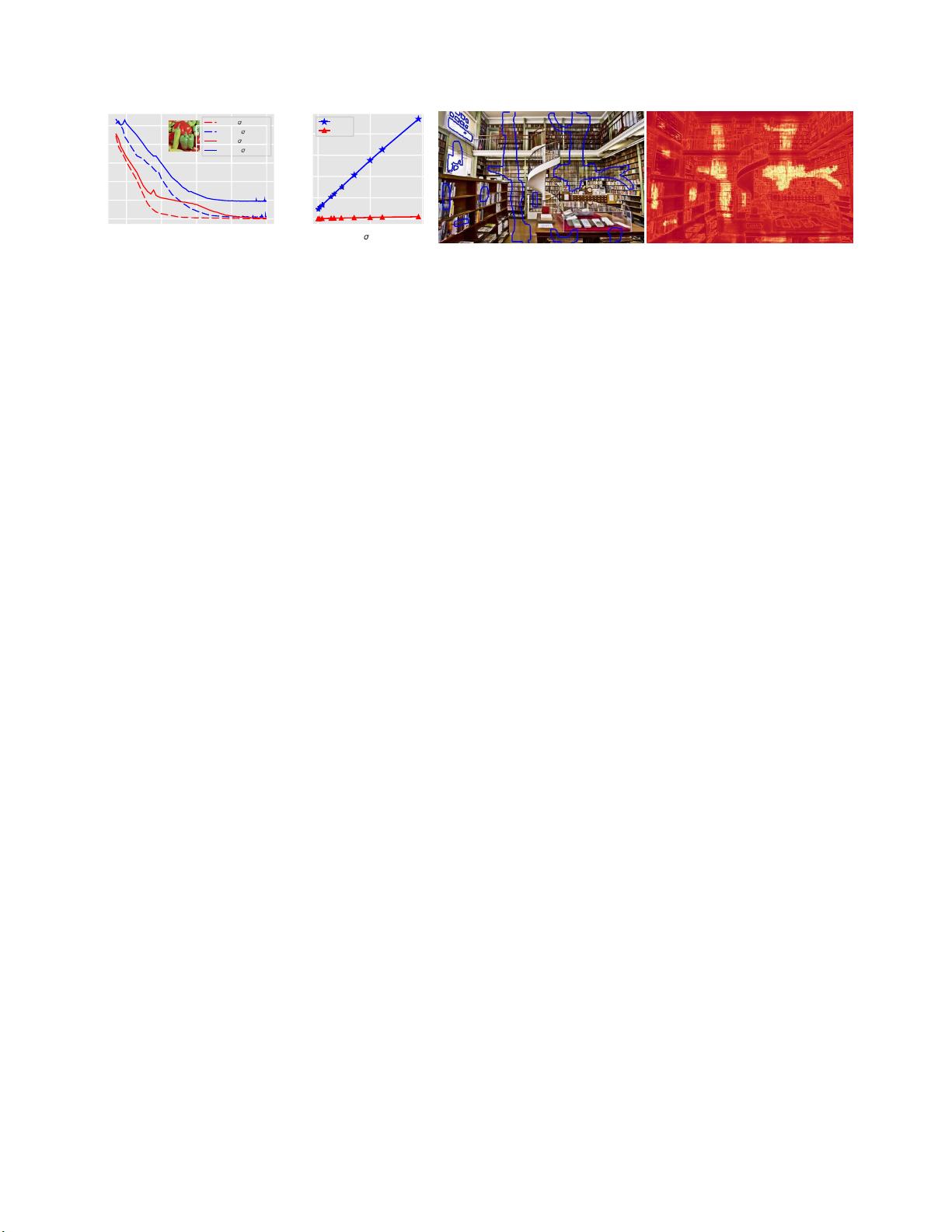

迭代(对数标度)

(a)

MSE与迭代

0.000

0.000 0.005 0.010

2

(b)

最终MSE与σ

2

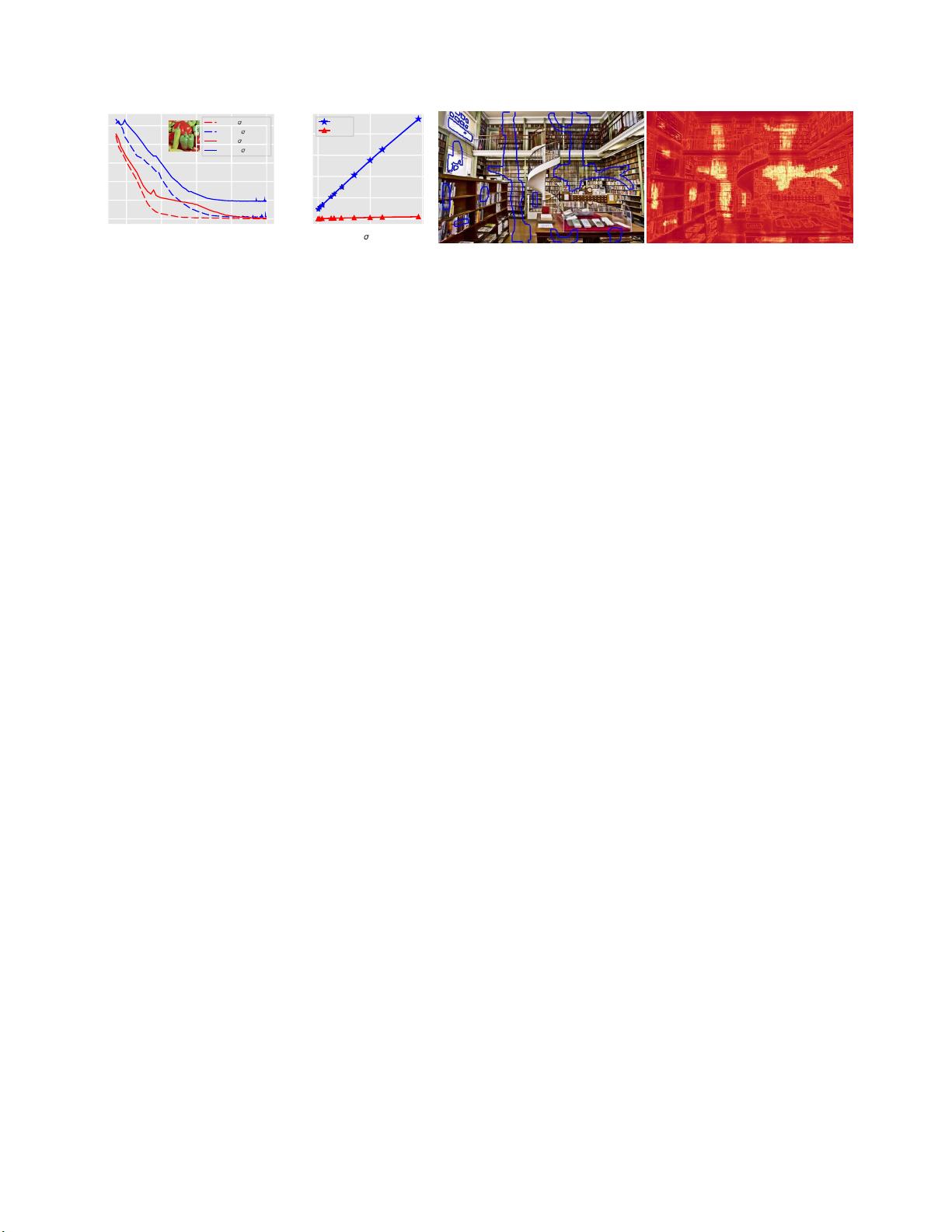

(c)推断均值(d)推断方差

图1.

(最好放大观看。)

使用深度图像先验对结果进行去噪和修复。(a)作为针对两个不同噪声水平的迭代的函数的推断图

像相对于噪声输入图像的均方误差(

MSE

)。

SGD

收敛到零

MSE

,导致过拟合,而

SGLD

大致收敛到图像中的噪声水平。这也

在图(b)中示出,其中我们绘制了SGD和SGLD的MSE作为收敛后噪声水平σ

2

有关实施细节,请参见第5.2.1节。(c)修复结

果,其中蓝色边界内的图像的部分被掩蔽并使用具有深度图像先验的

SGLD

来推断。

(

d

)从后验样本中获得的方差估计,可视化为热图。请注意,左上角附近的缺失区域具有较低的方差,因为该区域是均匀

的。

2.

相关工作

有前科。 我们的工作分析了

深度图像先验

[26]

,它

将图像表示为卷积网络

f

,输入

x

上的参数为

θ

。给定

噪声目标

y

,通过使重建误差

yf

(

x

;

θ

)在

x

和

θ

上最

小化来获得去噪图像

。该方法从

x

和

θ

的初始值开始

绘制

i.i.d.

。从零均值高斯分布,并通过梯度下降优

化目标,依靠早期停止,以避免过拟合(见图

1

)。

他们的方法表明,先验知识与最

先进的免学习方法

(

如

BM 3D [6]

)在图像去噪,超分辨率和修复任务

方面具有竞争力。 先验对

基于字典的方法[21]和非

局

部技术(诸如

BM 3D

和非局部均值

[4]

)所利用的分

层自相似性进行编码。网络的架构起着至关重要的

作用:

多层网络用于修复任务,而

具有跳过连接的网

络用于去噪。我们的工作表明,这些网络诱导的先

验对应于不同的平滑

高斯过程(GPs)。高斯过程是随机变量的无限集合,

其中任何有限子集都是联合高斯分布的[23]。GP通常

被视 为函数的先 验。设T是指数 集(例如, T

= R

或

T=

Rd

),设μ(t)为实

均值函数

,K(t

,

t

′

)为T上的

非负定

核

或

协方差函数

. 如果

f

∈GP(μ

,

K),

那么,对于任意有限个数的指数

t1

,

. . .

,

t

n

T

的

vector

(

f

(t

i

))

n

是高斯分布的,平均向量为- tor

(µ(t

i

))

n

和协方差矩阵(K(t

i

,

t

j

))

n

.

GPS在空间统计和地质 统计学方面有着悠 久的历 史

[17]。在ML中,对GP的兴趣是由它们与神经网络的联

系所激发的(见下文)。 可以使用GPS 用于通用贝

叶斯回归[31,22],分类[30]和许多其他应用[23]。

深度网络和

GPS

。Neal [19]证明了两层网络收敛于高斯

过程,

走 向 无 穷 大 。 Williams [29] 提 供 了 具 有 sigmoid 和

Gaussian传递函数的网络的协方差函数的表达式Cho和

Saul [5]提出了ReLU和Heaviside步骤非线性的内核,并

使用内核机器研究了它们的有效性。最近,一些工作

[13,18]已经将这些结果扩展到深度网络,并导出了

所得GP的协方差函数类似的分析也被应用于卷积网

络。加里加-阿隆索

等人

[9]研究了具有剩余层的卷积网

络的GP行为,而Borovykh [3]分析了滤波器宽度趋于

无穷大时的极限协方差函数。Novak等人[20]评估了结

果GP中池化层的效果。这项工作的大部分已经应用于

预测任务,其中给定一个数据集

=

(x

i

,

y

i

)

n

,由

深度网络诱导的协方差函数用于使用标准GP机制来估

计后验p(y x

,

)。相比之下,我们将卷积网络视为图

像坐标空间上的空间随机过程,并研究诱导的协方差

结构。

贝叶斯推理与深度网络 人们早就认识到,神经网络权

值的贝叶斯学习将是可取的[15,19],

例如

,以防止

过拟合和量化不确定性。事实上,这是连接神经网络

和GP的原始工作的动机。相对于权重上的先验执行

MAP估计在计算上是直接的,并且对应于正则化。然

而,全后验推理的计算挑战是显著的。早期的工作使

用MCMC [19]或拉普拉斯近似[7,15],但比反向传播

的基本学习慢得多。多年来,已经提出了几种变分推

理(VI)方法[12,1,10,2]。 最近,dropout被证明

是近似贝叶斯推断的一种形式[8]。我们将使用的方法

基于随机梯度朗之万动力学(SGLD)[28],这是一种

通过向迭代中添加噪声将SGD转换为MCMC采样器的

通用方法。Li等[14]前一篇文章