编码器-解码器架构:线条画驱动的3D形状重建与编辑

PDF格式 | 18.74MB |

更新于2025-01-16

| 39 浏览量 | 举报

"《从线条绘画中重建和编辑3D形状的编码器/解码器架构》一文探讨了一项前沿技术,旨在解决从2D草图中重建和编辑3D形状这一长期存在的挑战。文章介绍了一种基于编码器/解码器结构的方法,该结构允许将二维草图转化为可编辑的三维网格,从而实现对设计、工程和艺术领域中的CAD系统交互方式的革新。

传统的深度学习方法虽然在合成数据上表现出良好性能,但当应用于实际手绘草图时,它们往往生成粗糙的3D点云或受限于特定视图的重建结果。相比之下,单视图重建(SVR)方法近年来取得了显著进步,利用新颖的形状表示和图像特征的池化技术,使得从单张图片恢复3D形状成为可能。

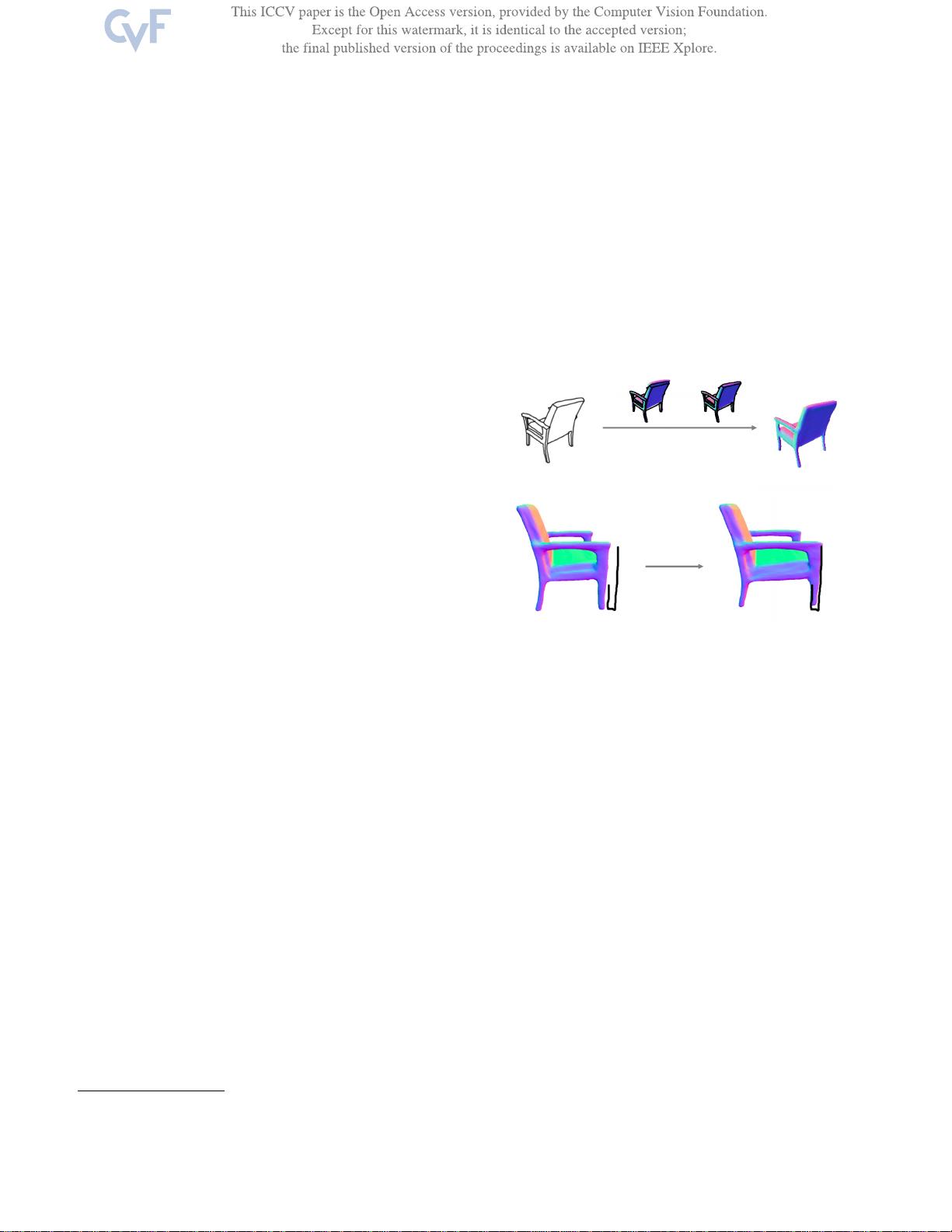

作者提出的Sketch2Mesh方法,采用编码器/解码器架构,从合成草图中生成高质量的表面网格。该网络学习到一种紧凑的3D形状表示,使得即使面对不同风格的线条绘画,也能确保投影的外轮廓与输入草图保持一致。此外,这种方法的优势在于其易于部署,对风格变化具有鲁棒性,并且能处理单个笔画的形状优化,极大地扩展了用户在2D绘制环境下的交互体验。

通过与当前最先进的方法进行比较,研究者展示了他们的方法在处理手绘草图(包括手绘和合成的草图)时表现出优越性,能够生成更精细、易于编辑的3D形状。这项工作对于提高CAD系统的易用性和效率具有重要意义,有望在未来的设计和创作流程中发挥关键作用。"

相关推荐

cpongm

- 粉丝: 6

最新资源

- 2016版四级行政区划SQL数据库及其应用

- Android入门小白的webService访问实践Demo

- 自动清理浏览器搜索历史的Search Privately-crx插件

- Python+MySQL实现的教务管理系统课程设计

- Swydo自定义集成教程:让在线平台数据无缝接入

- 如何查看文件后缀及了解其应用

- iOS实现简易webView加载功能

- Nest框架:高效可扩展的Node.js服务器端开发

- SourceTree 1.8.3版本发布,功能优化与更新

- Web Cache Viewer:浏览器扩展浏览历史缓存

- 《笨办法学Python 3》英文原版教程解析

- 探索Shell扩展技术及其应用

- Java项目中Geocoder相关依赖jar文件导览

- 系统窗口枚举与句柄获取及关闭技术解析

- Docker代码演示:Python和Node.js环境配置示例

- iOS APP版本更新弹窗提醒功能