无监督图像分类与分割:基于不变信息聚类的神经网络方法

PDF格式 | 1.49MB |

更新于2025-01-16

| 147 浏览量 | 举报

"基于不变信息聚类的无监督图像分类与分割技术"

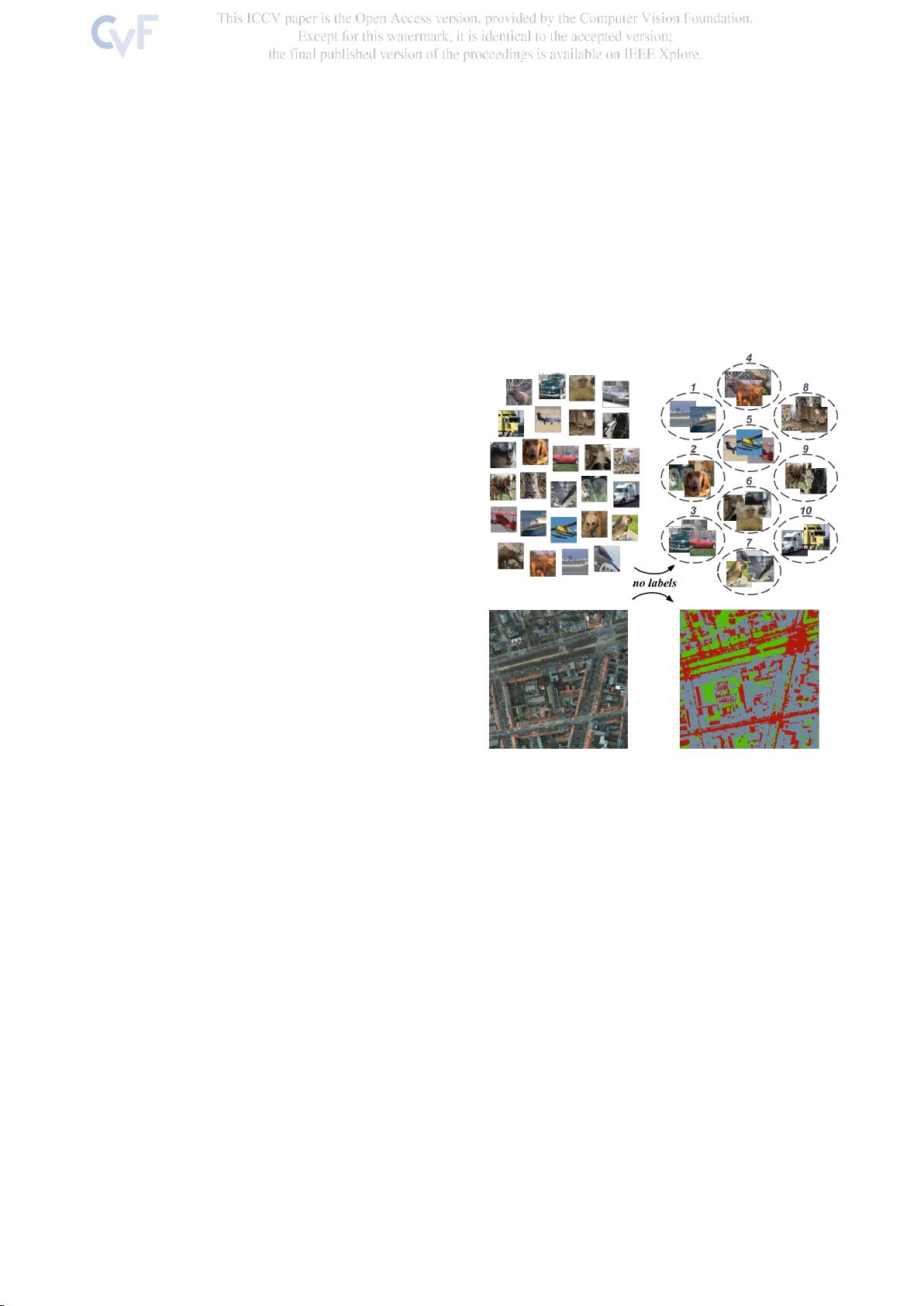

本文主要探讨了一种新的无监督图像分类和分割方法,称为“基于不变信息聚类”(Invariant Information Clustering, IIC)。该方法由牛津大学的研究团队提出,旨在解决深度学习中对大量手动标注数据的依赖问题,特别是在大规模图像分类和分割任务中。传统的监督学习方法需要大量标注数据,而无监督学习则尝试在无标签数据上进行学习,降低对人工标注的依赖。

IIC的核心思想是通过神经网络学习能够保持实例间互信息最大化的表示,从而发现具有语义意义的聚类。这一目标确保了网络能够在不同的无监督聚类基准上,如STL10和CIFAR10,生成准确的类别划分,同时直接输出语义标签,无需额外的后处理步骤。在STL10和CIFAR10上,IIC分别取得了6.6和9.5个百分点的准确率提升,显示出其在无监督图像分类任务上的优越性能。

不仅如此,IIC的方法也适用于图像分割任务,能有效地对像素级别的类别进行划分。在实验中,使用随机变换从每个图像中获取一对样本,增强了模型的泛化能力。此外,IIC不仅限于完全无监督学习,研究者还探索了两个半监督设置,其中一个在STL10分类任务上达到了88.8%的准确率,打破了现有方法的最高记录,无论是在监督、半监督还是无监督场景下。

IIC的目标函数基于信息论,确保了模型避免常见的退化解决方案,这些解决方案可能在传统聚类与深度学习结合时出现。由于其严格的信息理论基础,IIC易于实现,且能够稳健地处理各种数据集。该研究在GitHub上有公开的代码库,方便进一步的研究和应用。

基于不变信息聚类的无监督图像分类与分割技术为深度学习提供了一个有效且高效的解决方案,特别是在处理大规模、高成本标注数据的问题上。通过最大化实例间的互信息,这种方法能够在不依赖标签的情况下,学习到具有语义意义的类别表示,为计算机视觉领域带来了重要的进步。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 网狐工具:核心DLL和程序文件解析

- PortfolioCVphp - 展示JavaScript技能的个人作品集

- 手机归属地查询网站完整项目:HTML+PHP源码及数据集

- 昆仑通态MCGS通用版S7400父设备驱动包下载

- 手机QQ登录工具的压缩包内容解析

- Git基础学习仓库:掌握版本控制要点

- 3322动态域名更新器使用教程与下载

- iOS源码开发:温度转换应用简易教程

- 定制化用户登录页面模板设计指南

- SMAC电机在包装生产线应用的技术案例分析

- Silverlight 5实现COM组件调用无需OOB技术

- C#实现多功能画图板:画直线、矩形、圆等

- 深入探讨C#语言在WPF项目开发中的应用

- 新版2012109通用权限系统源码发布:多角色用户支持

- 计算机科学与工程系网站开发技术源码合集

- Java实现简易导出Excel工具的开发教程