自互蒸馏提升连续手语识别:融合视觉与上下文模块

PDF格式 | 1.52MB |

更新于2025-01-16

| 67 浏览量 | 举报

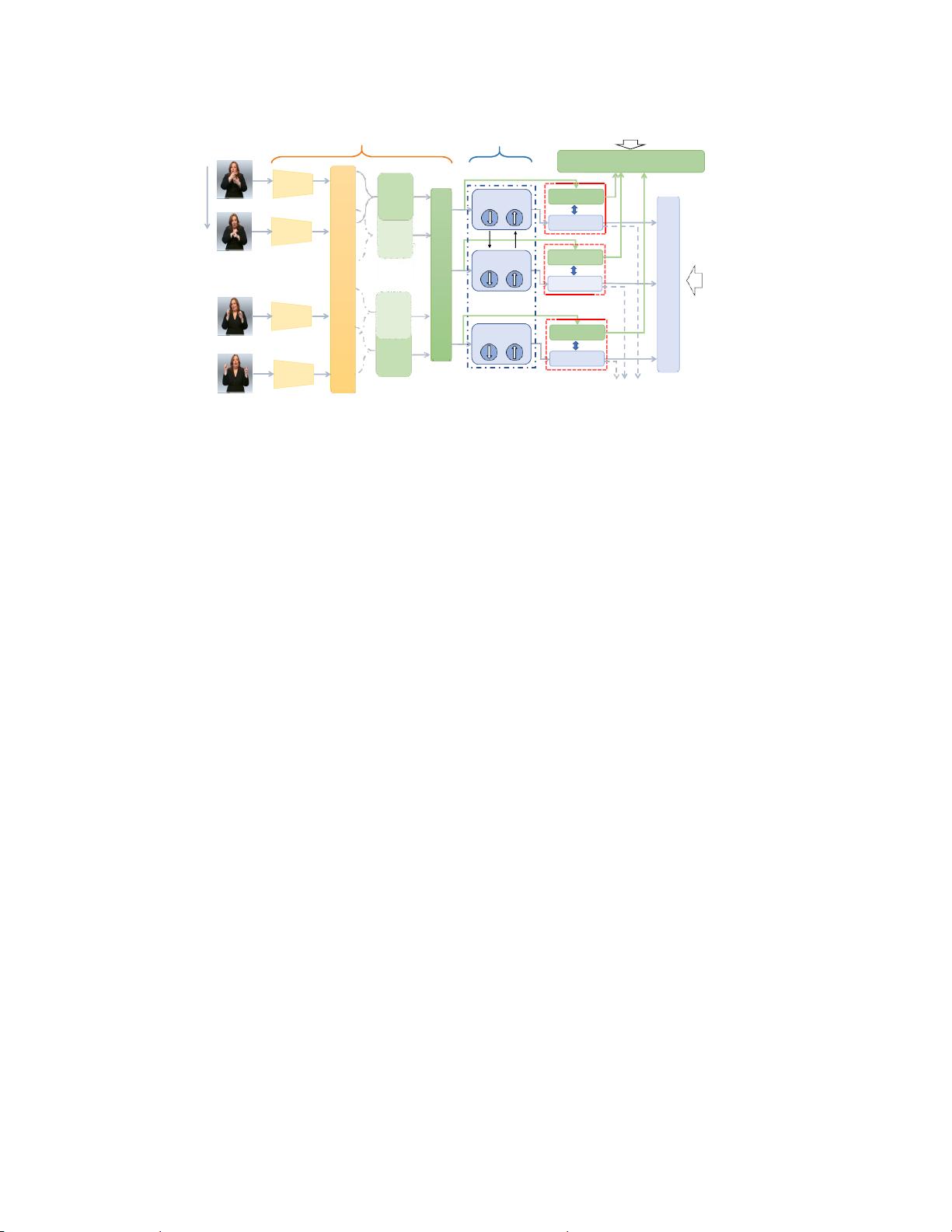

连续手语识别(Continuous Sign Language Recognition, CSLR)是深度学习领域的一个重要研究方向,特别是在视频信号处理中,它旨在理解和翻译手语表达。近期,深度学习技术极大地推动了CSLR的发展,特别是通过构建复杂的网络结构,如结合视觉模块和上下文模块来捕捉空间、短时和长时信息。传统的CSLR模型通常包括:

1. 视觉模块:专注于捕捉手势的空间布局和短期时间特征,它通过深度神经网络(DNN)学习手部、身体动作和环境背景等视觉元素。然而,由于反向传播中的链式规则限制,视觉模块的优化可能受到限制,无法完全适应最佳视觉特征提取。

2. 上下文模块:负责关注更长时间序列中的上下文信息,如手势之间的关联性和动态变化。主流方法使用条件随机场(Conditional Random Field, CRF)或连接主义时间分类(Connectionist Temporal Classification, CTC)损失函数来训练网络,使得上下文模块在优化过程中主要关注上下文而非视觉特征。

为了克服这种不平衡,本文提出了自互蒸馏学习(Self Mutual Knowledge Distillation, SMKD)方法。SMKD的主要创新在于:

- 共享分类器:视觉和上下文模块共享同一分类器的权重,这样两个模块可以相互学习,增强对时空信息的理解,同时提高它们区分短期和长期特征的能力。

- 光泽度分割:引入到视觉模块中的技术,用于减少图像中的峰值现象,如饱和度,从而更好地提取和利用关键帧的视觉信息。

- CTC损失优化:尽管CTC损失有助于选择关键帧,但它可能导致其他帧信息丢失。SMKD通过改进的策略,保持了整体序列的信息完整性。

在实验部分,作者在两个CSLR基准测试集,即PHOENIX14和PHOENIX14-T上验证了SMKD的有效性。结果表明,与传统方法相比,SMKD不仅提升了识别准确率,还实现了视觉和上下文模块的均衡优化,从而在连续手语识别任务中取得了显著的进步。这一研究对于提高手语识别系统的性能,特别是对于促进听力障碍人群的无障碍沟通具有实际意义。

相关推荐

cpongm

- 粉丝: 6

最新资源

- Verilog实现的Xilinx序列检测器设计教程

- 九度智能SEO优化软件新版发布,提升搜索引擎排名

- EssentialPIM Pro v11.0 便携修改版:全面个人信息管理与同步

- C#源代码的恶作剧外表答题器程序教程

- Weblogic集群配置与优化及常见问题解决方案

- Harvard Dataverse数据的Python Flask API教程

- DNS域名批量解析工具v1.31:功能提升与日志更新

- JavaScript前台表单验证技巧与实例解析

- FLAC二次开发实用论文资料汇总

- JavaScript项目开发实践:Front-Projeto-Final-PS-2019.2解析

- 76云保姆:迅雷云点播免费自动升级体验

- Android SQLite数据库增删改查操作详解

- HTML/CSS/JS基础模板:经典篮球学习项目

- 粒子群算法优化GARVER-6直流配网规划

- Windows版jemalloc内存分配器发布

- 实用强大QQ机器人,你值得拥有