学习阈值的通用领域自适应:OVANet方法

PDF格式 | 1.52MB |

更新于2025-01-16

| 164 浏览量 | 举报

通用域自适应(UNDA)是一种研究领域的关键课题,它旨在解决两个数据集之间的领域转移和类别转移问题。在传统无监督域适应(UDA)的基础上,UNDA扩展了适应性范围,考虑了更广泛的情景,如开放集DA(ODA)和部分DA(PDA),其中目标域可能包含源域中未知的类别,或者源域包含目标域中未知的类别。这些情况导致了传统方法的局限性,因为它们依赖于预定义的阈值来区分已知和未知样本,这可能导致误判。

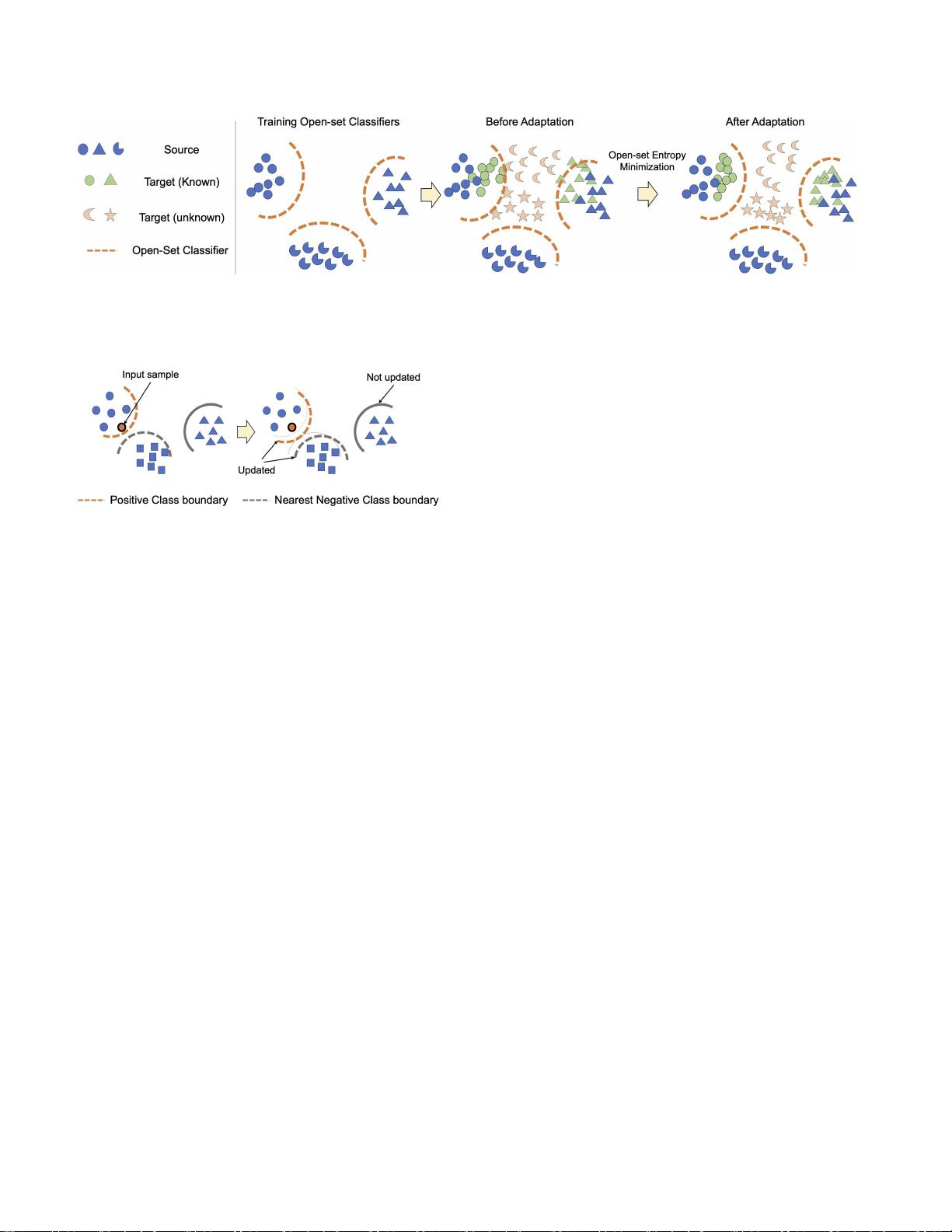

在本研究中,作者提出了OVANet(Open-Variate Auto-encoder Network),一个针对通用域自适应的方法。OVANet的核心创新在于它能够学习和自适应地调整阈值,而不是依赖于人工设定。这个框架的基石是利用源数据中的类间和类内距离信息。具体来说,通过为每个类别训练一个专用的分类器,OVANet能够捕捉不同类别间的区分度。接着,通过最小化类熵,使得这些分类器能够在目标域中进行适应,从而形成一个对超参数不敏感且性能强大的解决方案。

OVANet的独特之处在于其简单易用性,即使在没有关于目标域的先验知识时也能有效地工作。在实际应用中,获取大量标记数据的成本很高,因此,UNDA的设置对于减少标注需求具有显著的价值。然而,实现真正意义上的通用性并不容易,因为它需要处理类别转移的不确定性。作者强调,他们的方法在GitHub上的开源实现可以方便其他研究人员和实践者进一步探索和改进这一领域。

总结来说,OVANet为通用域自适应提供了一个新颖的、自动阈值调整的框架,通过学习源数据的特性来适应目标域,避免了手动阈值设置带来的潜在问题。这对于解决跨领域视觉识别任务中的未知样本处理具有重要的理论和实际意义。

相关推荐

cpongm

- 粉丝: 6

最新资源

- Verilog实现的Xilinx序列检测器设计教程

- 九度智能SEO优化软件新版发布,提升搜索引擎排名

- EssentialPIM Pro v11.0 便携修改版:全面个人信息管理与同步

- C#源代码的恶作剧外表答题器程序教程

- Weblogic集群配置与优化及常见问题解决方案

- Harvard Dataverse数据的Python Flask API教程

- DNS域名批量解析工具v1.31:功能提升与日志更新

- JavaScript前台表单验证技巧与实例解析

- FLAC二次开发实用论文资料汇总

- JavaScript项目开发实践:Front-Projeto-Final-PS-2019.2解析

- 76云保姆:迅雷云点播免费自动升级体验

- Android SQLite数据库增删改查操作详解

- HTML/CSS/JS基础模板:经典篮球学习项目

- 粒子群算法优化GARVER-6直流配网规划

- Windows版jemalloc内存分配器发布

- 实用强大QQ机器人,你值得拥有