参数化俯视模型解析复杂道路布局:深度学习驱动的场景理解

176 浏览量

更新于2025-01-16

收藏 1.55MB PDF 举报

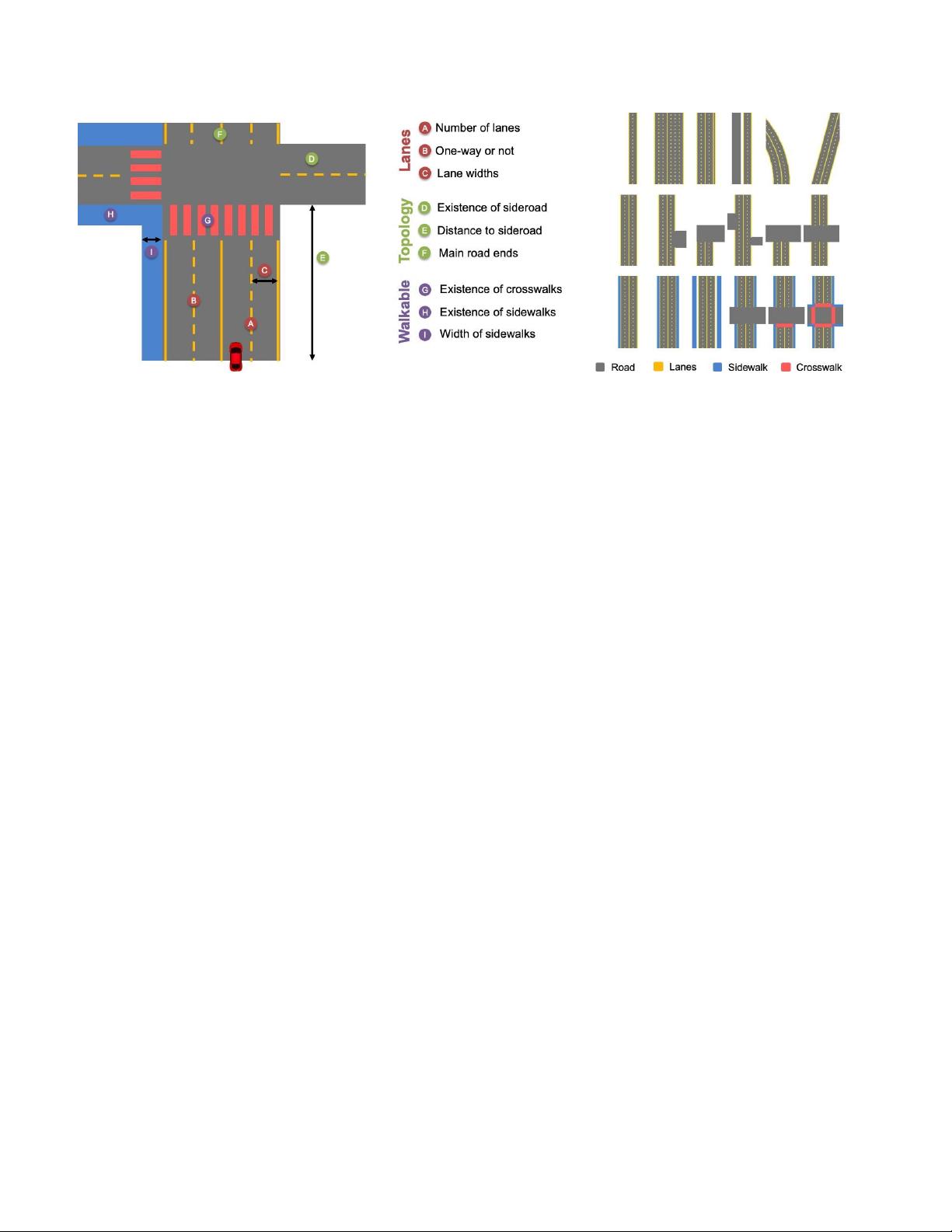

本文主要探讨了复杂道路场景的参数化俯视表示在自动驾驶和机器人导航等领域的应用。作者提出了一种创新的模型,旨在从单个摄像头的输入中推断出道路布局,这种表示不仅直观易懂,还提供了一种可解释的高层次决策框架。该模型强调了参数化的道路布局表示,通过定义车道数量、宽度、不同类型的交叉口、人行横道和人行道等关键特征,使模型更具可解释性和对下游应用的友好性。

在模型设计方面,作者采用了监督域自适应技术,结合模拟数据和人工标注的数据,以训练深度神经网络进行场景模型的推断。这种方法旨在提高模型的泛化能力,使其能在实际复杂场景中表现出色。此外,他们引入了条件随机场(CRF)来增强预测的连贯性和时间平滑性,确保视频帧之间的逻辑一致性,生成语义清晰的结果。

实验结果表明,该参数化俯视图模型在两个公开数据集上展现了良好的性能:

1. 能够有效地描述复杂道路场景的细节和结构;

2. 比单纯依赖手动标注或模拟数据训练的基线方法表现更优,实现了精度和效率的双重提升;

3. CRF的运用显著提升了视频序列的连续性和理解力,为实时的自动驾驶决策提供了有力支持。

这项工作通过参数化俯视表示和结合多种训练策略,推进了对复杂道路场景的理解和建模,对于提升基于深度学习的自动驾驶系统的性能具有重要意义。同时,该研究也展示了将非参数化场景表示转换为参数化形式在高级决策和解释性方面的潜力。

624 浏览量

119 浏览量

157 浏览量

174 浏览量

点击了解资源详情

点击了解资源详情

884 浏览量

517 浏览量

cpongm

- 粉丝: 6

最新资源

- 计算机组成原理期末试题及答案(2011参考)

- 均值漂移算法深入解析及实践应用

- 掌握npm与yarn在React和pg库中的使用

- C++开发学生信息管理系统实现多功能查询

- 深入解析SIMATIC NET OPC服务器与PLC的S7连接技术

- 离心式水泵原理与Matlab仿真教程

- 实现JS星级评论打分与滑动提示效果

- VB.NET图书馆管理系统源码及程序发布

- C#实现程序A监控与自动启动机制

- 构建简易Android拨号功能的应用开发教程

- HTML技术在在线杂志中的应用

- 网页开发中的实用树形菜单插件应用

- 高压水清洗技术在储罐维修中的关键应用

- 流量计校正方法及操作指南

- WinCE系统下SD卡磁盘性能测试工具及代码解析

- ASP.NET学生管理系统的源码与数据库教程