属性生成模型:语义对抗攻击的新视角

85 浏览量

更新于2025-01-16

收藏 1.56MB PDF 举报

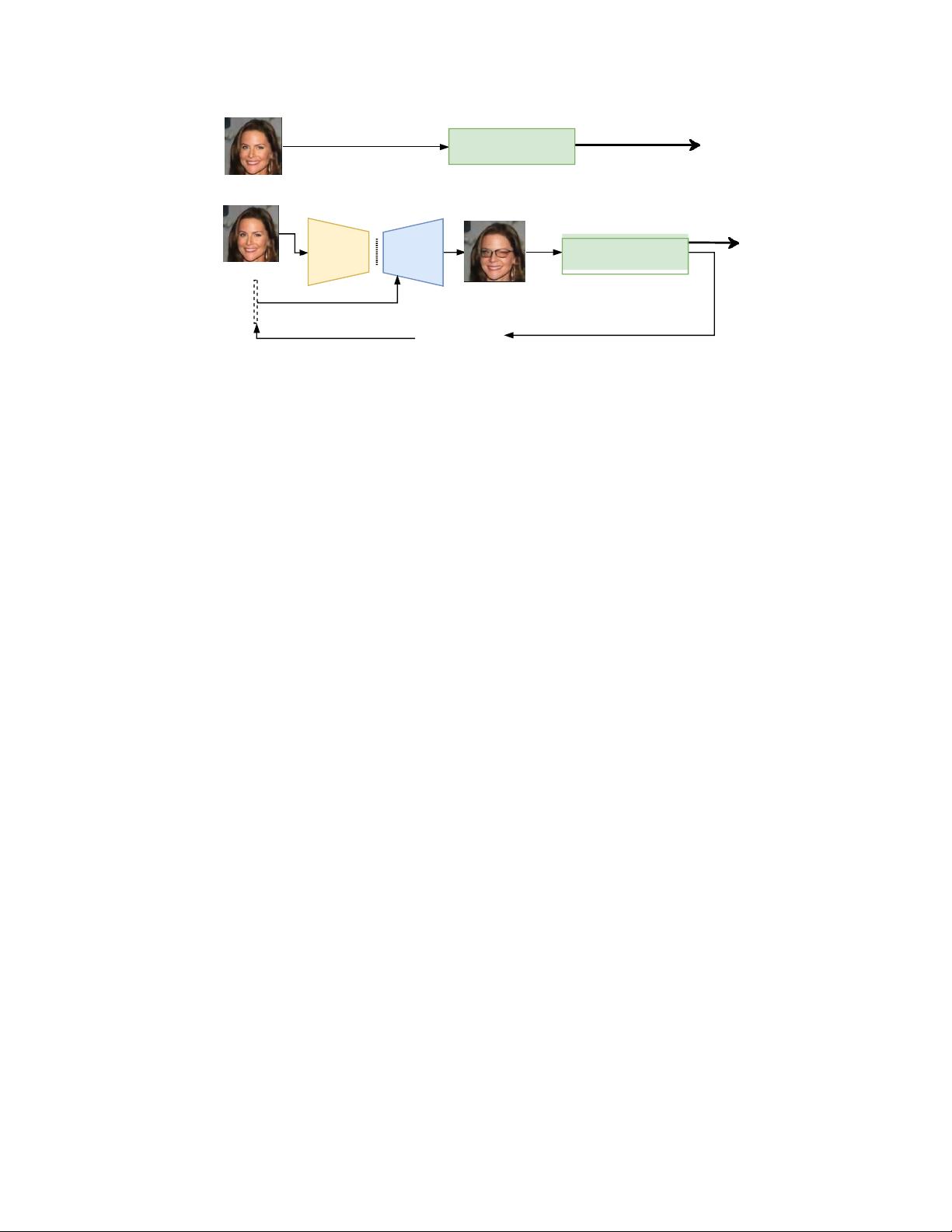

"本文主要探讨了语义对抗攻击在深度学习分类器中的应用,强调了在有限的属性修改情况下,如何生成对抗性示例来愚弄分类器。研究指出,传统对抗性攻击主要关注全局像素空间的微小扰动,而语义对抗攻击则聚焦于改变输入图像的特定属性,例如人脸图像的头发颜色或眼镜等,从而产生自然且能误导分类器的新输入。文章介绍了新提出的属性生成模型,并展示了在人脸识别任务上的应用实例。作者们还对攻击的有效性进行了合成数据和真实数据的评估,并与其他现有攻击方法进行了比较,提供了理论证明和实验结果。该研究受到多个机构的资助,并且得到了NVIDIA公司GPU的硬件支持。"

在深度学习领域,对抗性样本是一个重要的安全问题。传统的对抗性攻击通过在输入图像上添加人眼难以察觉的噪声来误导模型,这些噪声通常受到像素空间内的P-P-范数限制。然而,这种攻击方式并不反映真实世界中的情况,因为对手可能无法完全控制所有像素。因此,语义对抗攻击引入了一个新的视角,即只改变输入图像的某些特定属性,如颜色、纹理或形状,这些改变在视觉上更为自然,但仍可能导致分类错误。

文中提到的人脸图像为例,不变特征如面部结构代表了个体的身份,而可变属性如发型、妆容或配饰可以被用于构建对抗性示例。通过优化属性生成模型,可以在保持图像整体感知自然的同时,改变这些属性,从而生成可以混淆深度分类器的输入。这种方法不仅揭示了深度神经网络的脆弱性,也为提高模型的鲁棒性提出了新的挑战。

作者们实施了一系列实验,包括在合成数据集和真实人脸图像上对攻击的有效性进行评估,并对比了其他已知的对抗性攻击策略。这些比较有助于理解语义对抗攻击的独特性和潜在优势。此外,他们还提供了理论上对这种参数对抗性的证明,进一步证实了在特定属性变换下的对抗性样本确实存在。

这篇论文对语义对抗攻击的探索加深了我们对深度学习模型在实际环境中的局限性的理解,同时也为未来的研究指明了方向,即如何设计更健壮的模型来抵御这类攻击。未来的研究可能会集中在开发防御策略,以增强模型对语义对抗示例的抵抗力,同时保持其在正常输入上的高性能。

219 浏览量

2021-08-12 上传

2021-02-25 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- Verilog实现的Xilinx序列检测器设计教程

- 九度智能SEO优化软件新版发布,提升搜索引擎排名

- EssentialPIM Pro v11.0 便携修改版:全面个人信息管理与同步

- C#源代码的恶作剧外表答题器程序教程

- Weblogic集群配置与优化及常见问题解决方案

- Harvard Dataverse数据的Python Flask API教程

- DNS域名批量解析工具v1.31:功能提升与日志更新

- JavaScript前台表单验证技巧与实例解析

- FLAC二次开发实用论文资料汇总

- JavaScript项目开发实践:Front-Projeto-Final-PS-2019.2解析

- 76云保姆:迅雷云点播免费自动升级体验

- Android SQLite数据库增删改查操作详解

- HTML/CSS/JS基础模板:经典篮球学习项目

- 粒子群算法优化GARVER-6直流配网规划

- Windows版jemalloc内存分配器发布

- 实用强大QQ机器人,你值得拥有