使用卷积神经网络预测对象级场景上下文

134 浏览量

更新于2025-01-16

收藏 782KB PDF 举报

"本文主要探讨了对象级场景上下文预测,即如何从图像中的独立对象属性推断出完整的场景上下文。研究者提出了一种基于卷积神经网络(CNN)的方法,通过对象的类别、形状和位置等属性来预测场景布局,从而编码场景的语义和结构信息。此方法在定量实验和用户研究中表现出色,能够生成更合理的场景上下文,且适用于合成现实场景图像和场景识别。场景上下文在计算机视觉任务如对象检测、识别和分割中具有关键作用,而预测未知上下文是一个新的挑战。文章强调了人类视觉系统如何利用常识知识高效地推断场景,目标是使机器也能具备这种能力。"

在当前的研究中,作者们关注的是如何从图像中独立的对象中提取信息,以预测整个场景的上下文。以往的工作大多集中在利用上下文信息来改善对象检测和识别,而本研究则尝试解决逆问题,即从已知对象推断未知环境。为此,他们设计了一个卷积神经网络模型,该模型能处理不同物体间的复杂关系,并预测出场景中缺失的对象及其位置。

卷积神经网络在图像理解和处理领域已经取得了显著成果,由于其对图像特征的有效提取能力,它在这里被用来预测对象级的场景布局。通过输入对象的属性(如类别、形状和空间位置),模型可以生成一个对场景上下文的语义和结构进行编码的布局。实验结果表明,这种方法相比基线模型能产生更合理的预测,并且可以用于创建部分场景布局的合成图像,同时在场景识别任务中也有应用潜力。

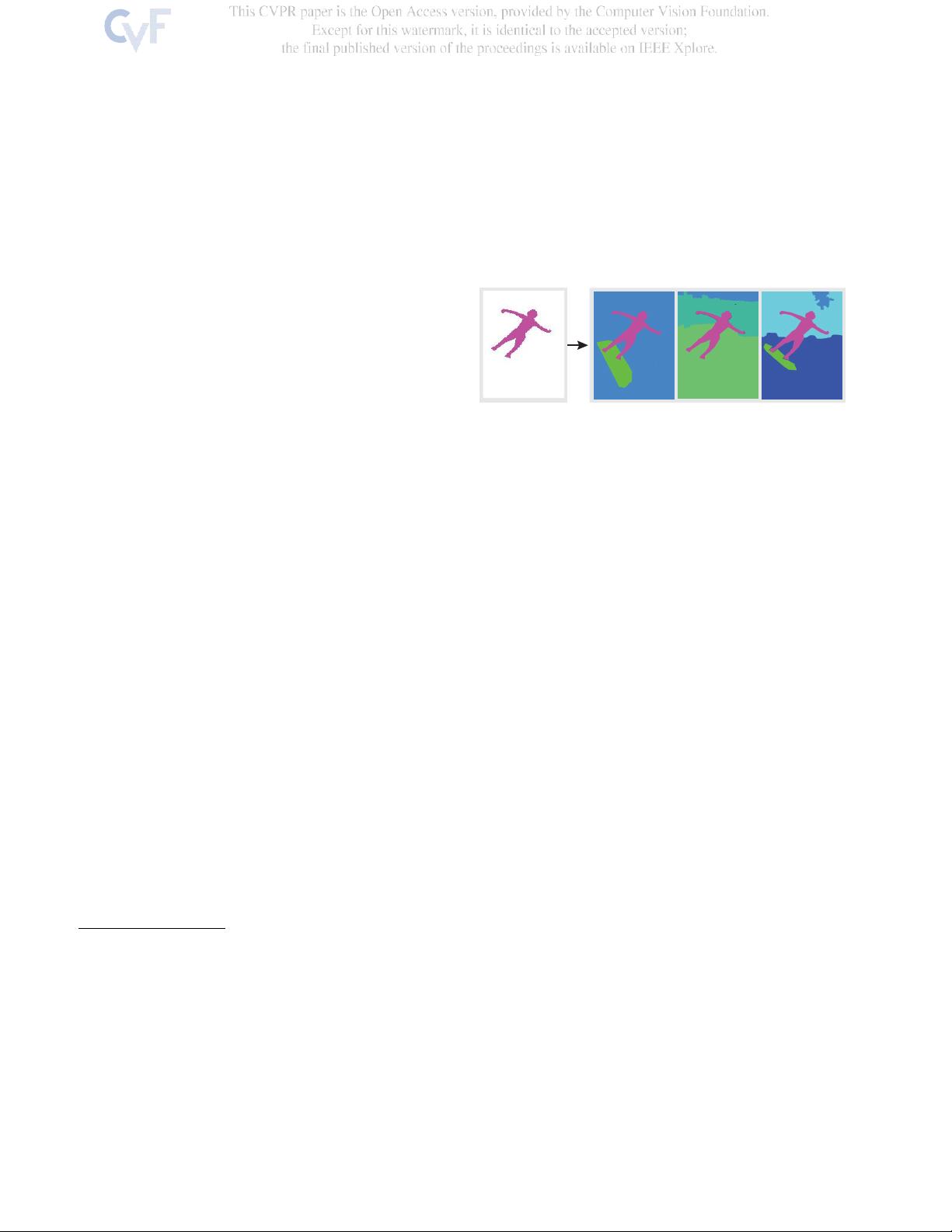

场景上下文的预测对于计算机视觉系统来说是一项重要挑战,因为自然场景中的物体关系多样且复杂。论文通过图1展示了这个概念,即给定一个或几个对象,模型需要利用这些对象提供的信息来推测可能存在的其他对象及其位置。人类可以利用常识和经验做到这一点,但机器需要通过学习和理解来实现。

这项研究为理解和模拟人类的场景推理能力迈出了重要的一步,也为计算机视觉系统增加了新的功能,使其能够预测并理解复杂的视觉环境。通过这种方式,未来的技术可能会在场景生成、虚拟现实、图像修复等领域有广泛应用。

2021-09-25 上传

105 浏览量

127 浏览量

359 浏览量

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- Openaea:Unity下开源fanmad-aea游戏开发

- Eclipse中实用的Maven3插件指南

- 批量查询软件发布:轻松掌握搜索引擎下拉关键词

- 《C#技术内幕》源代码解析与学习指南

- Carmon广义切比雪夫滤波器综合与耦合矩阵分析

- C++在MFC框架下实时采集Kinect深度及彩色图像

- 代码研究员的Markdown阅读笔记解析

- 基于TCP/UDP的数据采集与端口监听系统

- 探索CDirDialog:高效的文件路径选择对话框

- PIC24单片机开发全攻略:原理与编程指南

- 实现文字焦点切换特效与滤镜滚动效果的JavaScript代码

- Flask API入门教程:快速设置与运行

- Matlab实现的说话人识别和确认系统

- 全面操作OpenFlight格式的API安装指南

- 基于C++的书店管理系统课程设计与源码解析

- Apache Tomcat 7.0.42版本压缩包发布