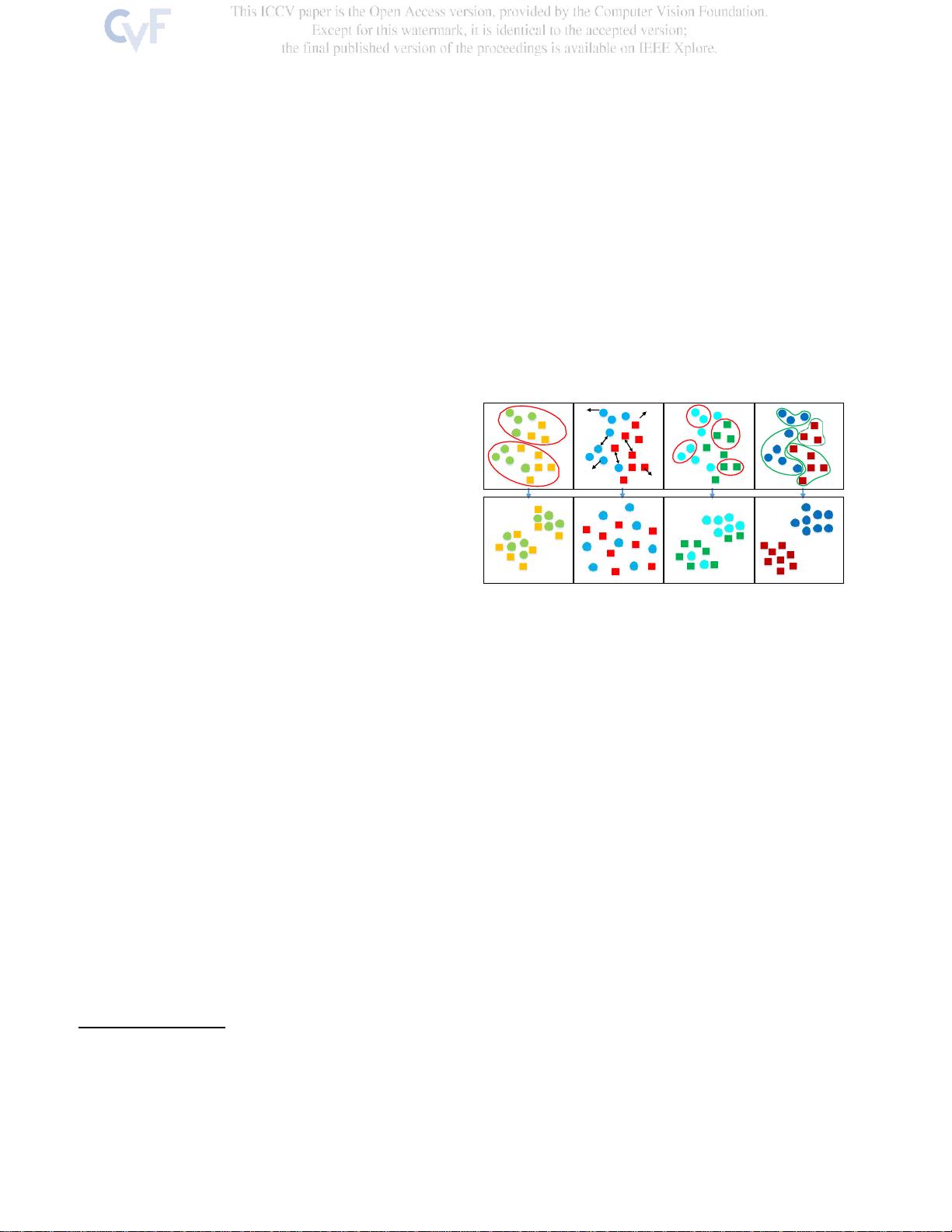

已经提出了Hood发现方法[22,54,23],其通过挖掘

实例到实例的相关性,以类一致性最大化来逐步探索

局部邻居。它们只是将高相似性分配给在特征空间中

具有短欧氏距离的对。当表示位于在欧氏空间中连续

的隐式特征流形中时,欧氏距离仅揭示极小邻域中的

真实语义相似性,并且由于与特征流形上测量的距离

不一致而无法提供大邻域因此,特征区分度仍然是有

限的,如图1的第三列所示。

在本文中,我们提出了一个ISL方法来学习语义相

似性的无监督特征表示的实例。与传统方法不同,传

统方法根据特征空间中的Eu-clidean距离将高相似性分

配给紧密对,我们的方法以无监督的方式挖掘特征流

形并学习不同样本之间的语义相似性,以便在大邻域

中应用可靠的实例到实例关系来监督表示学习模型,

如图的最后一列所示

1.

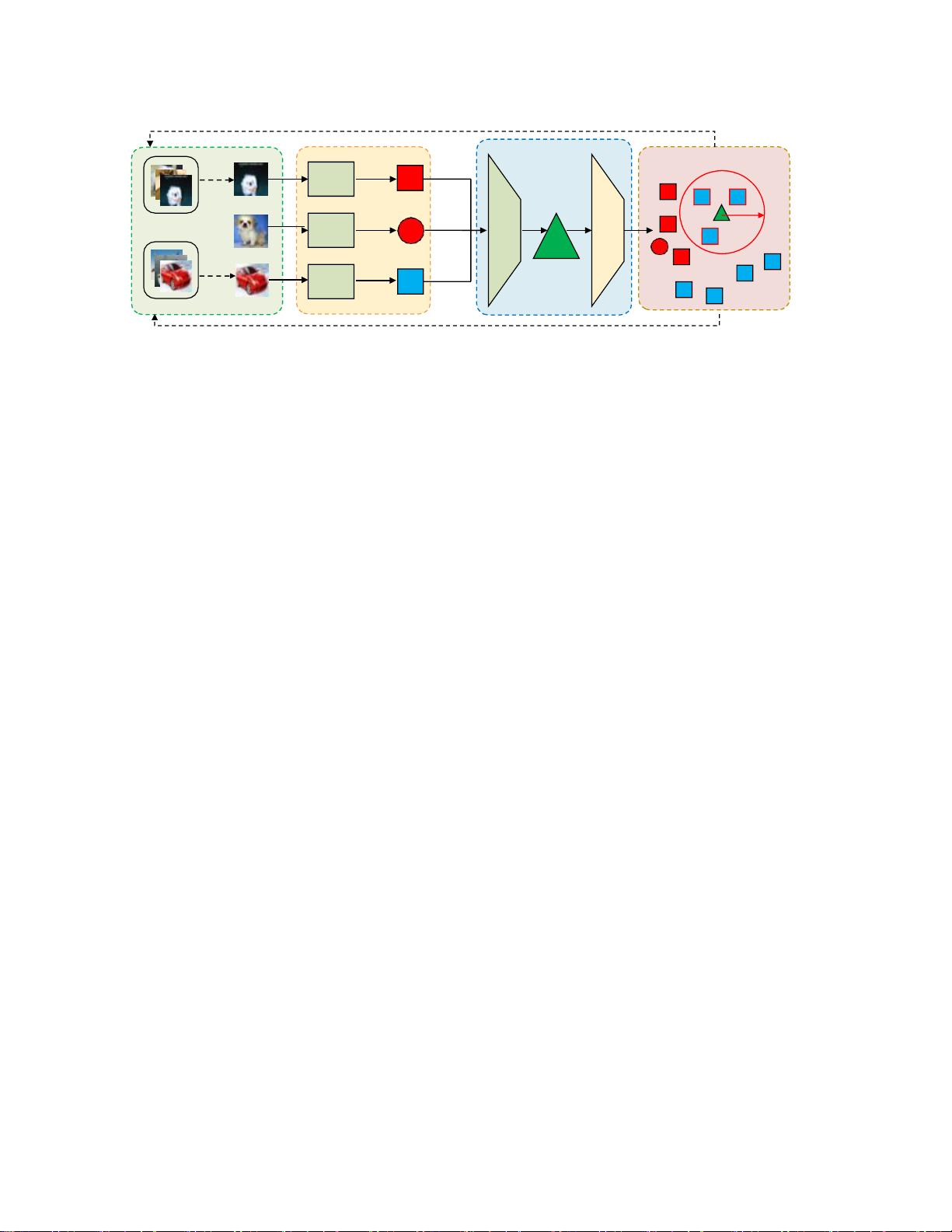

更具体地说,我们采用生成对抗网络(GAN)[13]

来挖掘底层特征人,图2描述了所提出方法的整体流

程。生成器产生代理特征,该代理特征基于所采样的

三元组来挖掘每个锚实例的阳性,并且鉴别器预测所

生成的代理在语义上与所挖掘的伪阳性样本相似的置

信度得分。由于Euclidean距离揭示了小邻域中的样本

相似性,因此将代理特征附近具有高置信度得分的实

例添加到给定锚点的正样本集为了探索更丰富的实例

关系并同时利用挖掘出的正样本集的语义,在GANs的

训练过程中,所生成的代理被强制为与负实例和挖掘

出的伪正在可靠的伪监督下,我们采用对比度损失与

硬 正 增 强 来 学 习 区 分 性 特 征 。 在 CIFAR-10 [28] ,

CIFAR-100 [28],SVHN [36]和ImageNet [6]图像分类

数据集上的广泛实验表明,所此外,我们的ISL可以与

最先进的无监督功能集成,以进一步提高性能。

2.

相关工作

无监督学习引起了广泛的兴趣-- 这是因为它使模型

能够由大量未标记的数据进行训练,并节省了昂贵的

注释成本。现有的方法可以分为五类:集群,在-

立场特异性分析、邻域发现、自监督学习和生成模

型。

聚类:聚类方法[3,47,24,48]采用聚类索引作为

伪标签来训练端到端无监督学习模型。Caron等人[3]共

同学习网络参数和特征的簇分配,其中k均值被应用于

迭代数据分组。此外,Yanget al. [48]应用堆叠的自动

编码器[43],以通过最小化图像重建损失来提供更强

的监督,而不管集群分配。然而,聚类方法是容易出

错的,因为它们不能表示高度复杂的类边界。

实例特异性分析:实例特异性分析[46,2,38,1,

16,21,4,50,18,49]方法将每个实例视为一个独

立的类,并且仅将样本及其转换的实例视为正对,假

设实例语义相似性是通过实例监督自动发现的。Wu等

[46]为了降低实例分类器的复杂度,提出了噪声对比

估计(NCE)来近似全softmax分布,并利用存储库来

存储实例特征。He等人[16]构建动态词典,促进大规

模对比学习。Chen等人[4]组合了具有额外的非线性变

换的各种数据增强技术,以学习有区别的非监督特

征。然而,在实例特异性分析方法中,学习的类边界

是模糊的,因为它们可能推开具有相同类标签的样本

并增加类内方差。

邻居发现:邻域发现方法[22,23,54]通过逐步挖

掘具有类一致性最大化的实例到实例的相关性来减轻

上述两种方法的缺点。Huang

等人

. [22]通过比较每个

实例与课程学习设置中的不同样本的余弦相似性,迭

代地扩大每个实例的邻域,Zhuang等[54]提出了一种

局部聚集的度量,其中鼓励相似的样本一起移动,反

之亦然。然而,现有的邻域发现方法简单地基于其特

征的欧氏距离来分配相似性以训练表示学习模型,这

未能证明大邻域的底层特征流形上的语义相似性。

自我监督学习:自监督学习方法[8,51,44,37,

39,25,35,11]通常设计文本前任务以提供具有人类

先验的手工制作的辅助监督,其中假设经由辅助监督

学习的语义可以被转移到下游任务,例如图像分类和

对象检测。Doersch等人[8]和Norooziet al. [37]在图像

上取样并设计拼图玩具,