稀疏扰动攻击:SparseFool的高效计算与深度网络鲁棒性研究

PDF格式 | 3.88MB |

更新于2025-01-16

| 174 浏览量 | 举报

本文主要探讨了深度神经网络在图像分类任务中的应用以及它们面临的挑战——对抗攻击。深度神经网络的广泛应用使得它们在诸如图像识别、物体检测等领域表现出色,但在面对精心设计的输入数据扰动时,其计算鲁棒性却显得脆弱。这些扰动往往只需少量像素的变化,即使这些变化是稀疏的,即只影响图像的一小部分,也能导致错误的分类结果。

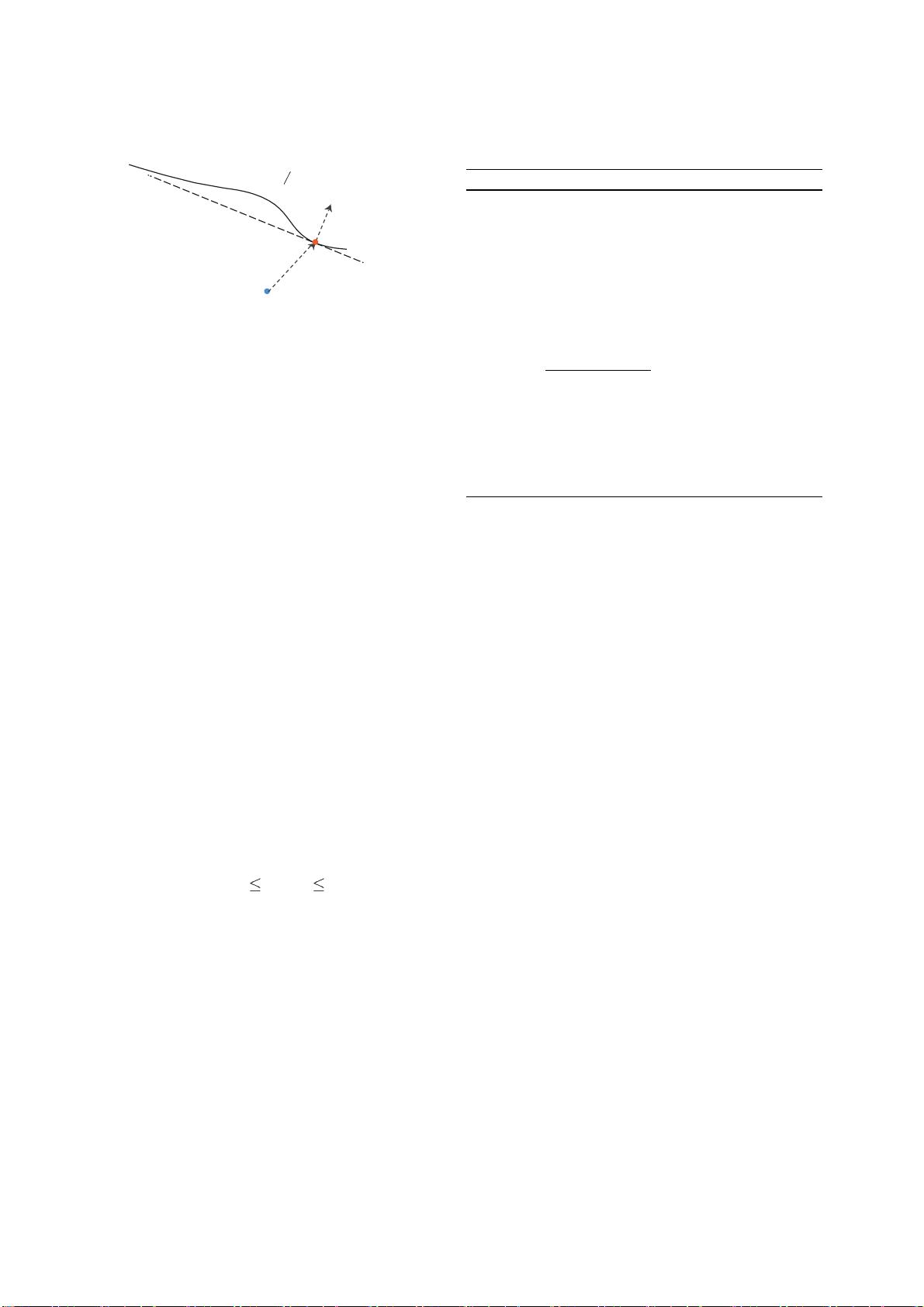

传统的对抗性攻击如Lp最小化扰动,特别是L2和L∞攻击,被广泛研究,这些方法旨在找到使模型输出发生最大改变的最小扰动。然而,尽管这些方法在计算复杂性上有所考虑,但针对稀疏扰动的高效计算方法仍然缺乏。文章的创新之处在于提出了SparseFool算法,它基于深度网络决策边界较低的平均曲率,设计了一个几何启发式的策略来控制扰动的稀疏性。这个方法的显著特点是能够在保持计算效率的同时,有效地处理高维度的数据。

通过广泛的实验,作者验证了SparseFool在计算稀疏扰动方面的高效性,它能够快速生成具有视觉欺骗性的例子,如图1所示的对抗性图像。这些扰动的生成过程随着像素数量的减少,仍然能引起模型误判。此外,研究还探讨了扰动的可转移性,即一个针对特定模型的稀疏扰动可能对其他模型也有效,这揭示了深度网络在处理共享语义信息方面的局限性。

文章还指出,对抗性训练虽然能够一定程度上提高模型对某些类型的攻击的鲁棒性,但对于由SparseFool计算的稀疏扰动,其效果并不明显。这意味着即使在对抗性训练之后,模型仍对稀疏扰动敏感,这为未来的研究提供了新的视角。

本文的贡献在于填补了计算稀疏扰动的有效方法这一空白,为理解和提升深度神经网络在对抗环境下的稳健性提供了新的工具和见解。通过SparseFool,研究人员和工程师可以更好地评估和防御针对稀疏特征的攻击,这对于保障AI系统的安全性和可靠性至关重要。

相关推荐

cpongm

- 粉丝: 6

最新资源

- A7Demo.appstudio:探索JavaScript应用开发

- 百度地图范围内的标注点技术实现

- Foobar2000绿色汉化版:全面提升音频播放体验

- Rhythm Core .NET库:字符串与集合扩展方法详解

- 深入了解Tomcat源码及其依赖包结构

- 物流节约里程法的文档整理与实践分享

- NUnit3.vsix:快速安装NUnit三件套到VS2017及以上版本

- JQuery核心函数使用速查手册详解

- 多种风格的Select下拉框美化插件及其js代码下载

- Mac用户必备:SmartSVN版本控制工具介绍

- ELTE IK Web编程与Web开发课程内容详解

- QuartusII环境下的Verilog锁相环实现

- 横版过关游戏完整VC源码及资源包

- MVC后台管理框架2021版:源码与代码生成器详解

- 宗成庆主讲的自然语言理解课程PPT解析

- Memcached与Tomcat会话共享与Kryo序列化配置指南