OperatorNet: 学习型框架重构3D形状,高效编码与重建

PDF格式 | 2.17MB |

更新于2025-01-16

| 195 浏览量 | 举报

本文主要探讨了一种创新的基于学习的方法,名为OperatorNet,用于从差分运算符中恢复和重构3D形状。作者黄如琪等人,来自巴黎综合理工学院、LIX Ecole Polytechnique以及斯坦福大学的研究团队,提出了一个突破性的框架,旨在解决3D形状编码和重建中的复杂问题。

传统的3D形状表示,如点云、三角网格和体积数据,由于缺乏规则网格结构,对卷积神经网络的适用性有限。为了克服这一挑战,研究者开发了一种新颖的神经网络架构,OperatorNet,它接受一组线性算子作为输入,然后生成形状的3D嵌入。这种方法的优势在于,它能够有效地处理形状的各种变换,无论是刚性运动还是非刚性和铰接变形,这对于保持形状信息的完整性至关重要。

不同于之前纯几何方法,OperatorNet结合了新的函数算子,这使得网络能够捕捉到外部或姿势相关的形状信息,弥补了经典拉普拉斯算子等内在姿势遗忘算子的不足。这种额外的形状信息提供了更精确的重建,即使在形状信息不完整的情况下,也能生成功能性、少失真的映射表示。

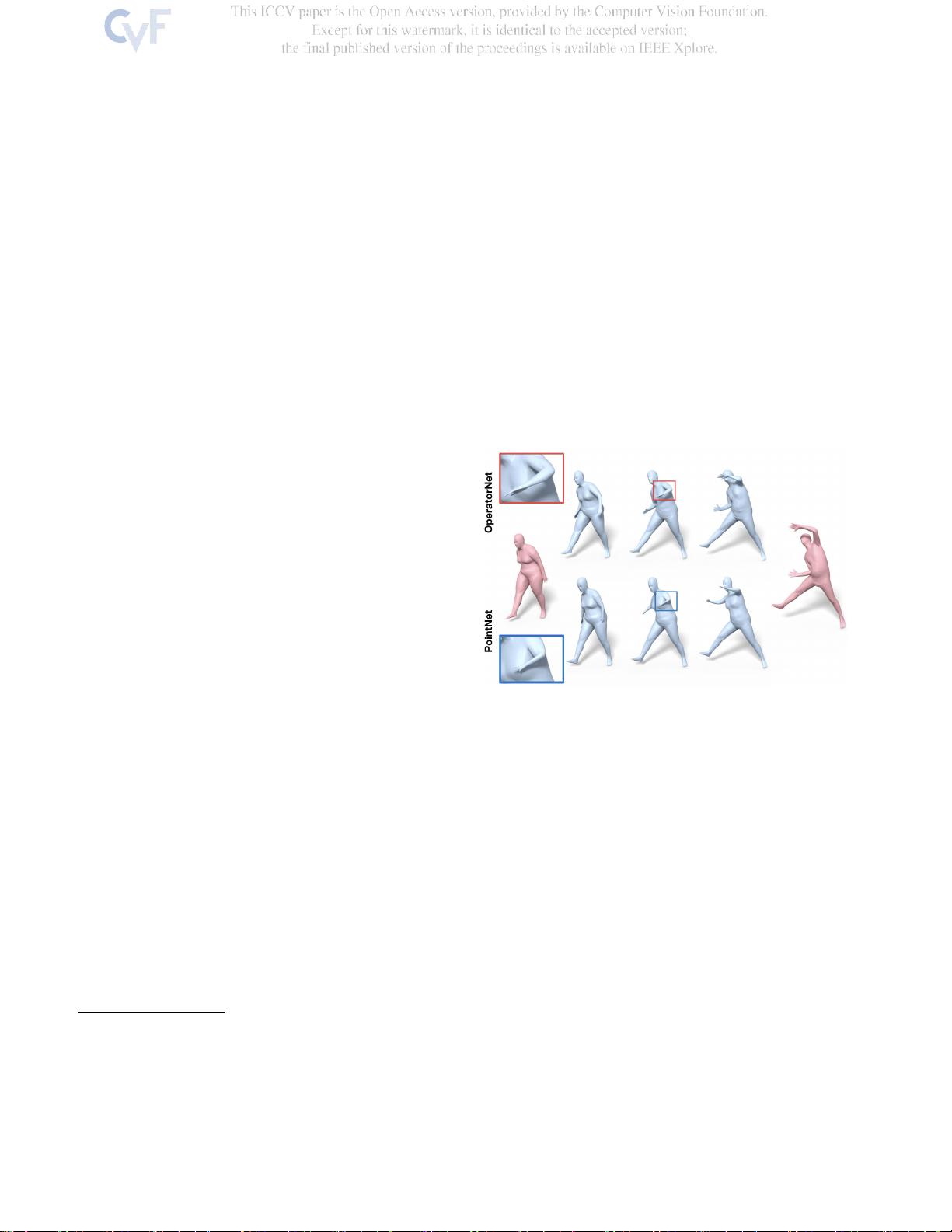

通过实验,文章展示了OperatorNet在形状插值任务中的优越性能,其生成的插值结果相比于PointNet自动编码器更为平滑且少有失真。这表明该方法不仅在形状分析方面表现出色,而且在形状合成,如形状插值和模拟等应用中,展现出强大的潜力。

研究者还进一步证明了通过OperatorNet学习到的算子乘法规则可以被用来合成全新的形状,这是通过形状的函数代数性质实现的,这在图形学和计算机视觉领域具有深远的影响。

这篇论文为3D形状的高效编码和重构提供了一个强大的学习框架,通过OperatorNet实现了在处理复杂形状变换和缺乏规则结构的数据方面的显著改进,为未来在图形生成和形态建模方面的发展奠定了坚实的基础。

相关推荐

12 浏览量

cpongm

- 粉丝: 6

最新资源

- Ruby语言集成Mandrill API的gem开发

- 开源嵌入式qt软键盘SYSZUXpinyin可移植源代码

- Kinect2.0实现高清面部特征精确对齐技术

- React与GitHub Jobs API整合的就业搜索应用

- MATLAB傅里叶变换函数应用实例分析

- 探索鼠标悬停特效的实现与应用

- 工行捷德U盾64位驱动程序安装指南

- Apache与Tomcat整合集群配置教程

- 成为JavaScript英雄:掌握be-the-hero-master技巧

- 深入实践Java编程珠玑:第13章源代码解析

- Proficy Maintenance Gateway软件:实时维护策略助力业务变革

- HTML5图片上传与编辑控件的实现

- RTDS环境下电网STATCOM模型的应用与分析

- 掌握Matlab下偏微分方程的有限元方法解析

- Aop原理与示例程序解读

- projete大语言项目登陆页面设计与实现