用于隐私保护节点分类的垂直联邦图神经网络

陈超超

1

,周军

1

,

2

,郑龙飞

2

,吴慧文

2

,吕玲娟

3

,吴佳

4

,吴炳哲

5

,刘子琪

2

,

王立

2

,郑晓林

1

,

6,

1

浙江大学,

2

蚂蚁集团,

3

索尼

AI

,

4

麦考瑞大学,

5

北京大学,

6

JZTData Technology

{zjuccc,xlzheng} @ zju.edu.cn,Lingjuan. sony.com,jia. mq.edu.au,wubingzhe@pku.edu.cn,

{jun.zhoujun

,

zlf206411

,

huiwen.whw

,

ziqiliu

,

raymond.wangl} @ antgroup.com

摘要

图神经网络(GNN)在处理各种实际的图数据

任务方面取得了显著的进展。高性能的GNN模

型往往依赖于图中丰富的特征和完备的边信

息。然而,这样的信息--

持有人在实践中,这是所谓的数据隔离问题。

为了解决这个问题,本文提出了一种垂直联邦

图神 经网络(Vertically Federated Graph Neur-

ral Network,VFGNN),它是一种用于数据垂

直划分环境下隐私保护节点分类任务的具体来

说,我们将计算图分为两部分。我们保留私有

数据(即,特征、边和标签)相关的计算,并

将其余的计算委托给半诚实服务器。我们还建

议应用差分隐私,以防止潜在的信息泄漏的服

务器。我们在三个基准上进行了实验,结果证

明了VFGNN的有效性。

1

介绍

图神经网络(GNN)由于其能够在同质和异质图上对高

维特征信息和高阶相邻信息进行建模,因此得到了学术

界和工业界越来越多的关注

[

Wuet al. ,2019

]

。高性能

GNN模型的一个重要组成部分是高质量的图形数据,包

括丰富的节点特征和完整的相邻信息。然而,在实际应

用中,这些信息可能被不同的数据持有者隔离,这就是

所谓的

数据隔离

问题。这种数据隔离问题对人工智能的

发展提出了严峻的挑战,成为近年来的研究热点。

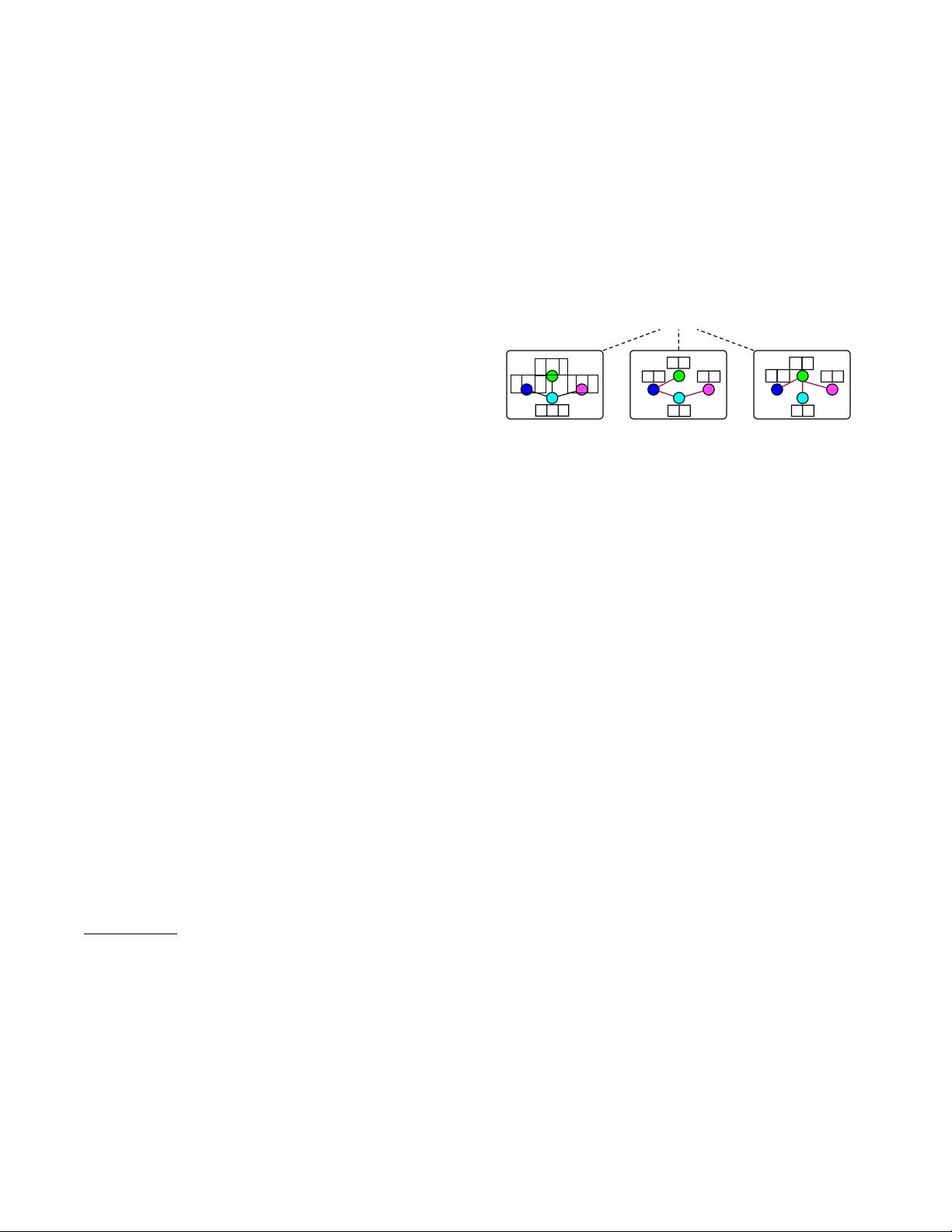

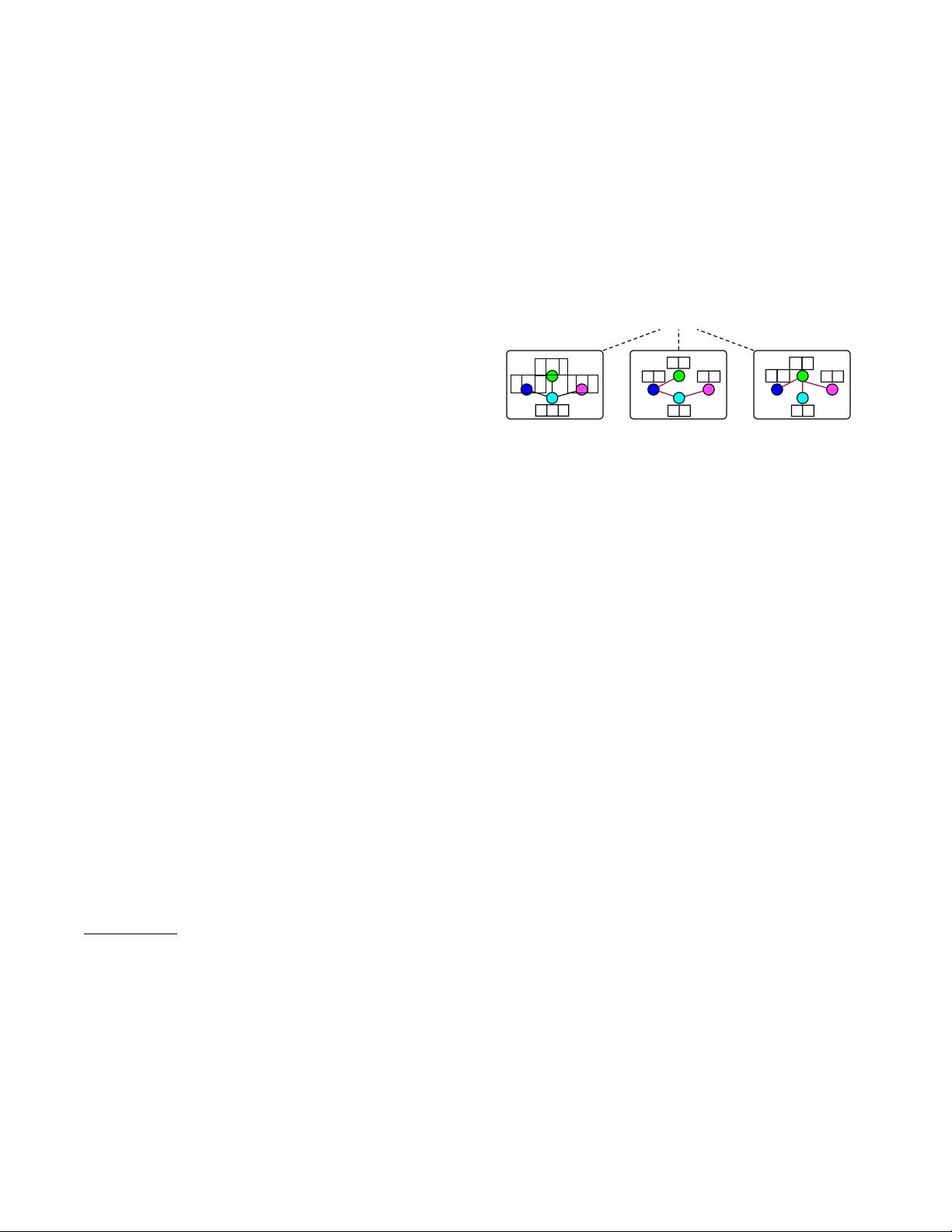

问题. 图1显示了垂直分区数据设置下的隐私保护节点分

类问 题这里,我 们假设有三 个数据持有 者(

A

、

B

和

C),它们

通讯作者

图1:垂直联邦GNN的问题描述。

有四个相同的节点。节点特征被垂直分割,即,有

f1

,

f2

和

f3

, 有

f4

和

f5

, 有

f6

和

f7

。与此同时,、、和可能有自己的优势。例如,节

点之间具有社交关系,而节点之间具有支付关系 我

们还假设

是

拥有节点标签的一方。问题是使用

A

、

B

和

C

的图数据构建联邦

GNN

模型。

相关工作。迄今为止,已经提出了许多种隐私保护机器

学习模型,例如,logistic回归

[

Chenet al. ,2021

]

、决策

树

[

Fangetal.

,

2021

]

和神经网络

[

Waghet al. ,2019

]

。还

有一 些研究GNN中 隐私问题的 工作 ,例如, 图发布

[

Sajadmanesh 和 Gatica-Perez , 2020

]

, GNN 推 理

[

Heet

al. , 2020

]

, 以 及 当 数 据 水 平 分 区 时 的 联 邦 GNN

[

Zhenget al. ,2021;Wuet al. ,2021

]

。到目前为止,很

少有人研究GNN在数据垂直划分时的问题,这在实践中

是普遍存在的。与以前的隐私保护机器学习模型不同,

这些模型假设只有样本(节点)由不同的各方持有,并

且这些样本没有关系,我们的任务更具挑战性,因为

GNN依赖于样本之间的关系,这些样本也由不同的数据

持有者保存。

天真的解决方案。构建隐私保护GNN的一种直接方法是

采用高级加密算法,如同态加密(HE)和安全多方计

算(MPC)

[

Mohassel和Zhang,2017

]

。这种纯密码方式

可以提供高安全性保证,然而,它遭受高计算和通信成

本,这限制了它们的效率

[

Osiaet al. ,2019

]

。

我们的解决方案。相反,我们提出了VFGNN,一个联

邦GNN学习范式的隐私保护节点分类任务下的数据垂直

分 区 设 置 。 动 机 - vated 由 现 有 的 工 作 在 分 裂 学 习

[

Vepakommaet

arXiv

:

2005.11903v3 [cs.LG] 2022

年

4

月