LSTM-C:带有复制机制的图像字幕与新对象分类

98 浏览量

更新于2025-01-16

收藏 898KB PDF 举报

"图像字幕学习机制及新对象分类的研究"

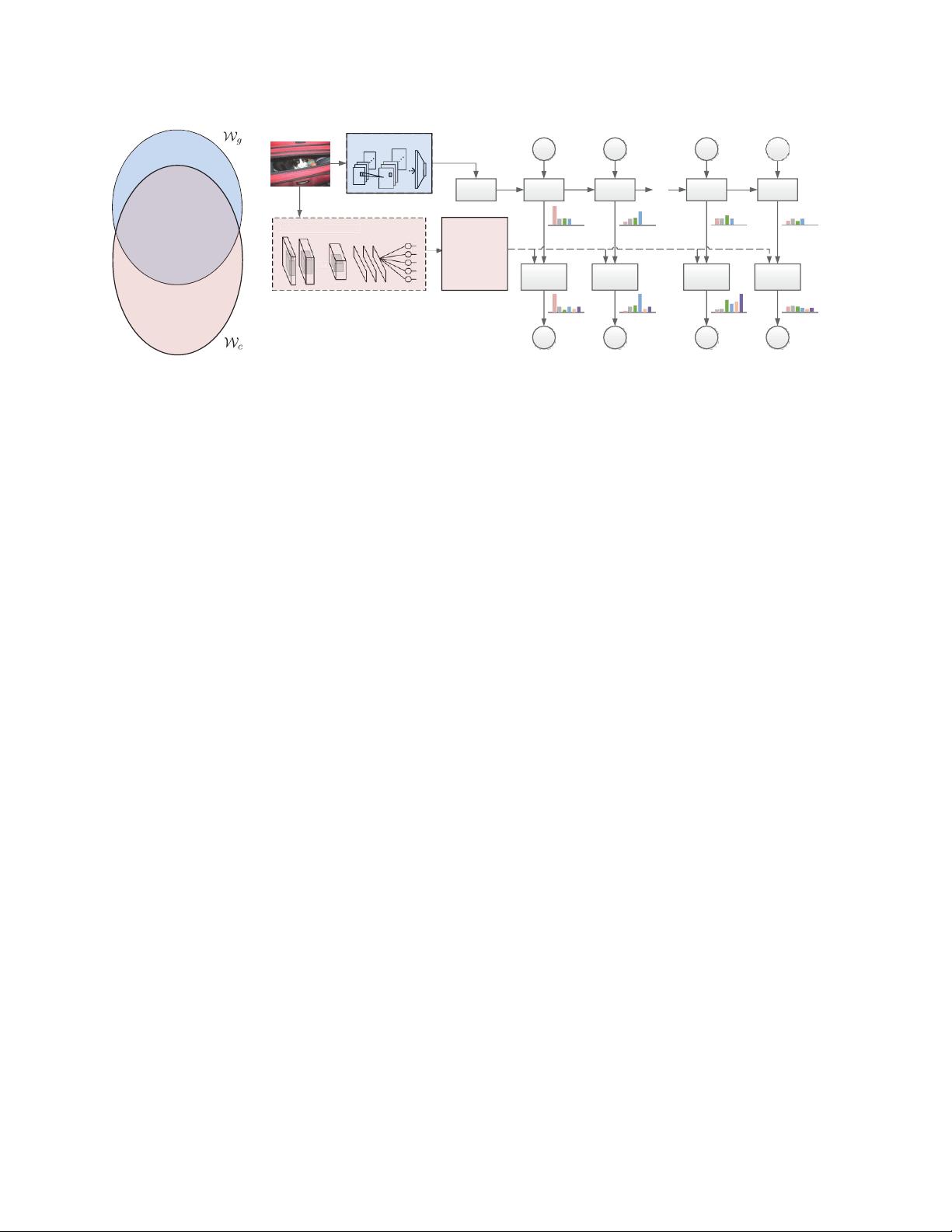

本文探讨的是图像字幕学习中的挑战,特别是在处理新出现或未在训练集中见过的对象时的能力。传统的图像字幕模型,如基于卷积神经网络(CNN)和递归神经网络(RNN)的LSTM-C架构,可能受限于训练数据的局限性,无法有效描述训练集外的新颖对象。为解决这个问题,作者提出了一个名为LSTM-C的新架构,该架构引入了复制机制。

LSTM-C模型的核心是结合了CNN和RNN的图像captioning框架,通过添加复制机制,能够更有效地处理新对象的描述。复制机制允许模型在生成句子时,从预先训练好的新对象分类器中选择合适的词汇,这个分类器是利用免费的对象识别数据集构建的。这样,即使在训练数据中未出现过的新对象,LSTM-C也能在适当的位置插入正确的单词。

为了验证LSTM-C的有效性,作者在两个广泛使用的数据集——MSCOCO图像字幕和ImageNet上进行了大量实验,并与当前最先进的深度学习模型进行了比较。实验结果显示,LSTM-C在描述新对象的能力上表现出显著的优势,证明了其在图像字幕任务中的优越性能。

图像字幕任务本身具有重要的实际应用价值,比如在机器人视觉和辅助视觉障碍者理解图像内容方面。传统的序列学习方法,如基于CNN-RNN的模型,依赖于大量的图像-句子对进行训练,这限制了它们处理未见过对象的能力。而LSTM-C模型的创新之处在于,它能够学习并适应新对象,从而扩展了模型的泛化能力。

在图1中,作者展示了LSTM-C相对于其他方法(如LRCN)的优势。LRCN未能正确识别并描述图像中的“行李箱”,而LSTM-C则成功地识别并生成了包含“行李箱”的句子,这显示了其在处理新对象描述方面的优势。

这项工作为图像字幕模型的改进提供了一种新途径,通过增强模型对新对象的理解和描述,有望推动图像字幕技术的进步,使其更加智能和适应性强。

点击了解资源详情

184 浏览量

2021-03-08 上传

2021-04-12 上传

点击了解资源详情

167 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- 易酷免费影视系统:开源网站代码与简易后台管理

- Coursera美国人口普查数据集及使用指南解析

- 德加拉6800卡监控:性能评测与使用指南

- 深度解析OFDM关键技术及其在通信中的应用

- 适用于Windows7 64位和CAD2008的truetable工具

- WM9714声卡与DW9000网卡数据手册解析

- Sqoop 1.99.3版本Hadoop 2.0.0环境配置指南

- 《Super Spicy Gun Game》游戏开发资料库:Unity 2019.4.18f1

- 精易会员浏览器:小尺寸多功能抓包工具

- MySQL安装与故障排除及代码编写全攻略

- C#与SQL2000实现的银行储蓄管理系统开发教程

- 解决Windows下Pthread.dll缺失问题的方法

- I386文件深度解析与oki5530驱动应用

- PCB涂覆OSP工艺应用技术资源下载

- 三菱PLC自动调试台程序实例解析

- 解决OpenCV 3.1编译难题:配置必要的库文件