必须针对特定场景和传感器来调整ETER,并且通常难

以在运行时间和重建质量的不同方面之间找到良好的

折衷

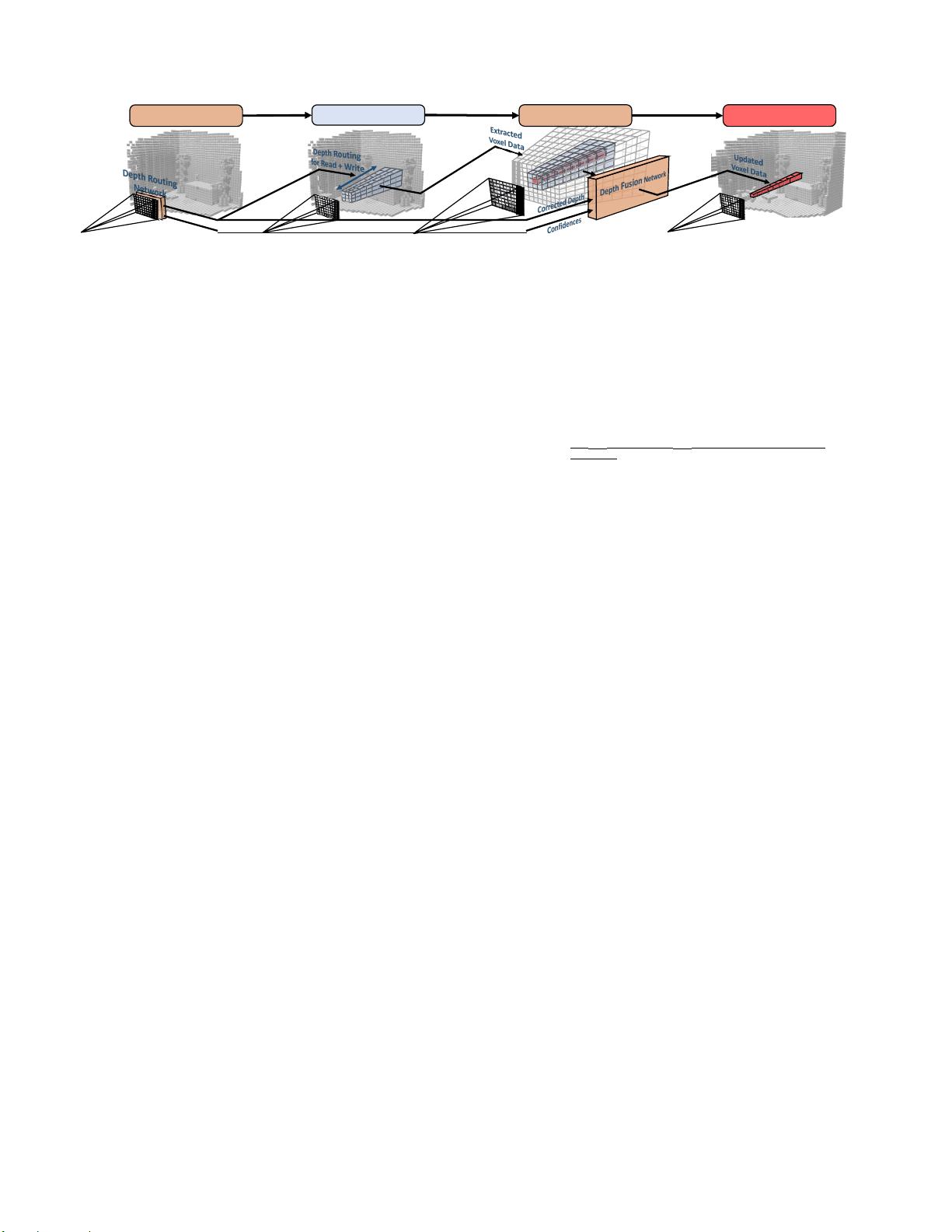

在本文中,我们的目标是解决上述缺点,同时保持

所有的优点,trans-mapping方法与合理的额外的计算

时间,仍然满足实时要求。为此,我们提出了一种学

习方法,将噪声和离群污染的测量融合到单个表面

中,执行非线性更新以更好地处理对象边界和薄结

构,并且对于实时应用来说足够快。图1显示了我们方

法的示例输出。总之,本文

•

提出了一种基于学习的实时深度图融合方法。由于

其紧凑的架构,它只需要很少的训练数据,并且不

容易过度拟合。

•

我们提出了一个可扩展的和实时的神经架构,是独

立的场景大小。因此,它适用于大量的现实世界场

景。

•

我们显示了标准TSDF融合的缺点的显著改进

它具有两个优点:1)它具有自然从多视图设置产生

的各向异性噪声分布; 2)它通过避免不一致的更新

来减轻薄对象和表面边界上的表面增厚效应。

2.

相关工作

体积深度图融合。通过他们的开创性工作,Curless和

Levoy [9]提出了一种用于融合噪声深度图的优雅方

法,该方法后来被KinectFusion [21]等众多作品采用,

更可扩展的 概 括 如体素哈希[37, 33]或分层 场 景 表

示,如体素八叉树[16,49,34]和分层哈希[24]。特别

是对于像Infini-TAM [23]这样的SLAM管道,体积融合

由于其实时能力而成为标准方法。在这种情况下,它

也被扩展为变得更准确和鲁棒[8],以及通过场景部分

的额外表面配准来改善SLAM,以考虑[55,32,11]中

提出的姿势漂移。具有额外中值滤波的方法[42,34,

33]提高了鲁棒性,并且仍然具有实时能力,但有效性

有限。全局优化方法[59,27]如果进一步利用语义信

息[19,6,20,44,43],则可以更好地处理噪声和离

群值,但它们在计算上昂贵且不具备实时能力。在

[65,31]中,作者提出了基于阴影恢复形状的已融合

SDF几何形状的细化方法。这些方法中的绝大多数直

接融合

RGB-D

图像,

Zoll hofer

等人

。

[66]

请提供最近的

调查。所有这些方法通过更新测量深度周围的更宽的

体素带来处理噪声测量,从而导致薄几何形状上的增

厚伪影。

基于曲面的融合方法基于表面的方法用局部点样本逼

近表面,这可以进一步编码附加的局部属性,例如法

线或纹理信息。已经提出了多种方法

e.G. MRSMap [50]使用八叉树来存储多分辨率surfel数

据。基于点的融合方法[25,29]将surfel表示与下一段

讨论的概率融合相结合。ElasticFusion [55]处理实时循

环闭合并在线校正所有表面估计

。

Scho

?

ps

等

[47]

提

出了一种

具有实时网格构造

的深度融合方法

基于面元

的方法的缺点是缺少面元之间的连通性信息。非结构

化的邻域关系只能通过最近邻搜索来建立或通过空间

划分数据结构来简化。在我们的工作中,我们决定依

靠体积表示,但将我们的方法扩展到非结构化设置是

未来工作的一个有趣途径。

概率深度图融合。 为了解释输入深度图中和沿着不同

视线方向的不同噪声水平,融合问题也可以被转换为

概率密度估 计 [15] ,同时通常假设 高斯噪声模型。

Keller等人[25]提出一种基于点的融合方法,其直接更

新点云而不是体素网格。Lefloch等人[29]将该思想扩

展到基于各向异性点的融合,以便在从不同入射角观

察表面时考虑不同的噪声水平。Zienkiewicz

等人

的基

于网格的融合方法。[64]允许在已知固定拓扑的各种

网格分辨率上进行深度融合Woodford和Vo- giatzis [56]

的概率融合方法在[52,51]中也使用了类似的基于射

线的可见性约束,但由于射线势的复杂优化,这些方

法不具备实时能力。各向异性深度图融合方法还跟踪

融合协方差[57]。类似地,PSDF Fusion [13]示例对方

向相关传感器噪声进行建模。与我们的方法相反,所

有这些方法都假设特定的噪声分布,主要是高斯分

布,这通常不能正确地模拟真实的传感器观测。

基于学习的重建方法。已经提出了几种基于学习的方

法来融合、估计或改进几何形状。SurfaceNet [22]联合

估计多视图立体深度图及其体融合,但由于每个相机

视图需要完整的体素网格,因此对内存的要求非常

高。在[30]中,在经典TSDF融合上学习多视图一致

性。RayNet [39]使用马尔可夫随机场沿着射线势对视

图依赖性进行建模3DMV [10]将2D视图信息与预融合

的TSDF场景相结合,以共同优化形状和语义。里格勒

等