TF-Blender:强化视频对象检测的时间关系与特征融合

6 浏览量

更新于2025-01-16

收藏 2.06MB PDF 举报

TF-Blender是一种创新的视频对象检测方法,专为解决视频帧间特征退化问题而设计。传统的视频检测技术往往依赖于相邻帧间的特征聚合来提高检测性能,但这些方法通常聚焦于高级别特征的融合,而忽略了低级别的时间关系模型。TF-Blender旨在弥补这一不足。

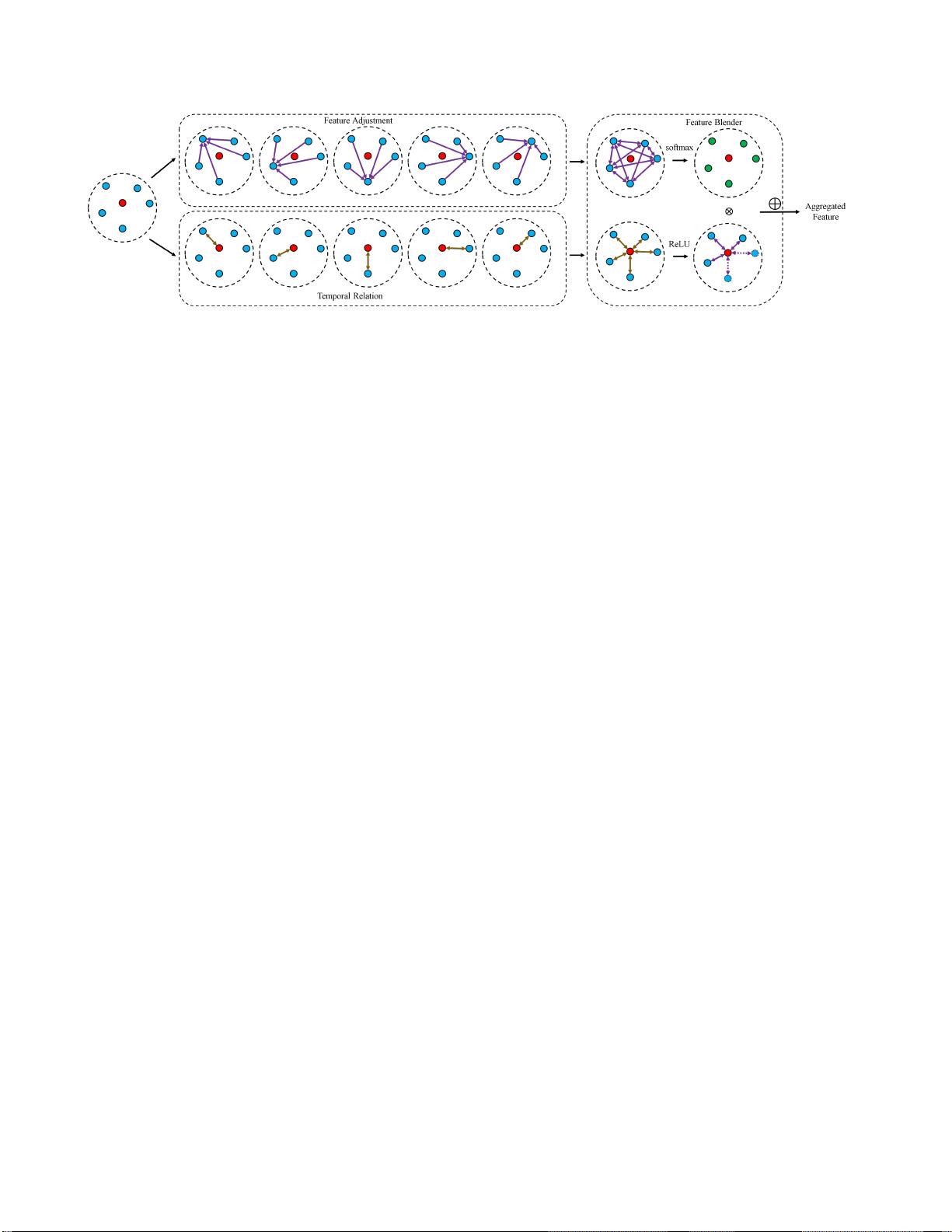

该方法由三个关键模块组成:

1. 时间关系建模模块:这个模块负责捕捉当前帧与相邻帧之间的时空关系,通过保留空间信息,帮助检测算法更好地理解动态场景中的物体。它通过分析帧与帧之间的局部时空变化,增强了对视频流连续性的理解。

2. 特征聚合过程:不同于传统方法简单地平均或加权融合相邻帧的特征,TF-Blender采用一种更细致的方式,对每一对相邻帧进行处理,生成更为丰富的特征表示。这种策略能够捕获更精确的时空特征关联,提高了特征的有效性。

3. 特征混合器:作为整个流程的整合部分,特征混合器将前两个模块的输出进行集成,生成最终的特征表示,这些特征不仅包含当前帧的信息,还融入了周围帧的时空上下文。这样,混合后的特征能够提供更强的表示能力,有助于提高视频对象检测的准确性。

TF-Blender的优势在于其灵活性,可以轻松地嵌入到现有的检测网络中,无需大幅度修改架构,就能显著提升检测性能。在ImageNetVID和YouTube-VIS等基准测试中,TF-Blender展现出明显的性能提升,证明了其在复杂场景中的优越性。该研究的代码可在GitHub上获取,以便其他研究人员和开发者进一步探索和应用。

TF-Blender通过对时间关系的深入建模和特征的精细化聚合,有效应对了视频对象检测中的挑战,展示了在解决视频帧外观变化和特征退化方面的重要突破。其简单易用的特性使其成为未来视频处理领域的一个有力工具。

150 浏览量

236 浏览量

点击了解资源详情

204 浏览量

2021-04-11 上传

150 浏览量

171 浏览量

282 浏览量

1457 浏览量

cpongm

- 粉丝: 6

最新资源

- Openaea:Unity下开源fanmad-aea游戏开发

- Eclipse中实用的Maven3插件指南

- 批量查询软件发布:轻松掌握搜索引擎下拉关键词

- 《C#技术内幕》源代码解析与学习指南

- Carmon广义切比雪夫滤波器综合与耦合矩阵分析

- C++在MFC框架下实时采集Kinect深度及彩色图像

- 代码研究员的Markdown阅读笔记解析

- 基于TCP/UDP的数据采集与端口监听系统

- 探索CDirDialog:高效的文件路径选择对话框

- PIC24单片机开发全攻略:原理与编程指南

- 实现文字焦点切换特效与滤镜滚动效果的JavaScript代码

- Flask API入门教程:快速设置与运行

- Matlab实现的说话人识别和确认系统

- 全面操作OpenFlight格式的API安装指南

- 基于C++的书店管理系统课程设计与源码解析

- Apache Tomcat 7.0.42版本压缩包发布