Trans4Map:视觉变换器在自我中心到他中心语义映射中的应用

98 浏览量

更新于2025-01-16

收藏 1.75MB PDF 举报

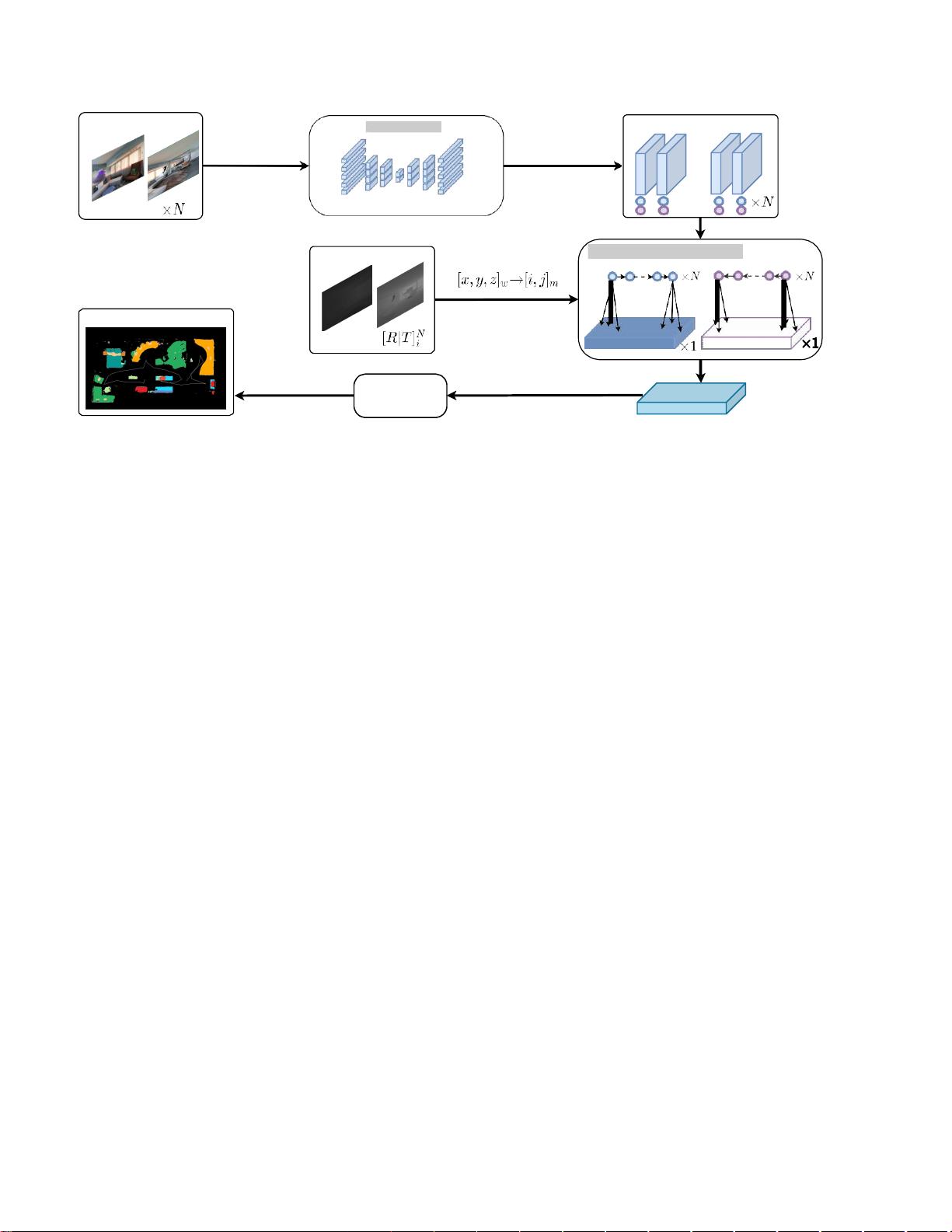

"本文介绍了一种名为Trans4Map的新型视觉变换器,旨在解决移动代理从自我中心图像到他中心语义映射的挑战。Trans4Map是一个端到端的一阶段映射框架,利用Transformer有效地处理长距离依赖性,同时通过双向他中心记忆(BAM)模块实现更高效的空间感知能力。在Matterport3D数据集上的实验显示,Trans4Map在减少参数数量的同时,提高了语义分割的准确性。"

在当前的AI领域,尤其是涉及移动机器人和自动驾驶的技术中,构建和理解全景地图是核心任务之一。传统的卷积神经网络(CNN)由于局部感受野的限制,往往难以捕捉到全局的环境信息,这对于从自我中心视角(即机器人自身的视角)到他中心视角(全局或固定参考系)的转换是个难题。Trans4Map的出现,就是为了克服这个问题。

Trans4Map的核心是使用Transformer架构,Transformer以其强大的序列建模能力而闻名,可以处理序列中的长距离依赖关系。在这个框架中,Transformer被用来从一系列自我中心的图像中提取上下文特征,这有助于构建全面的环境理解。接着,引入的双向他中心记忆(BAM)模块进一步将这些特征投射到他中心视角,形成一个累积的记忆表示,这有助于构建非自我中心的语义地图。

BAM模块的关键在于其“双向”特性,它能够双向更新和融合信息,从而在记忆中既考虑到过去的观察也考虑到来自新观测的更新,这对于实时的在线映射过程尤为重要。最后,映射解码器会解析这个累积的存储器,生成自顶向下的语义分割映射,即全景语义地图。

实验结果显示,Trans4Map在Matterport3D数据集上取得了最先进的性能,相比于其他方法,它在减少67.2%参数量的同时,提高了3.25%的平均交并比(mIoU)和4.09%的精度,证明了其在效率和性能上的优势。

Trans4Map的工作为移动代理提供了一种新的、高效的方法来构建和理解周围环境,这对于自主导航、室内探索以及各种自动化任务来说都是至关重要的。这一进展为未来的研究开辟了道路,可能会进一步推动AI在空间感知和映射方面的进步。

点击了解资源详情

1243 浏览量

552 浏览量

2024-06-04 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- 小学水墨风学校网站模板设计

- 深入理解线程池的实现原理与应用

- MSP430编程代码集锦:实用例程源码分享

- 绿色大图幻灯商务响应式企业网站开发源码包

- 深入理解CSS与Web标准的专业解决方案

- Qt/C++集成Google拼音输入法演示Demo

- Apache Hive 0.13.1 版本安装包详解

- 百度地图范围标注技术及应用

- 打造个性化的Windows 8锁屏体验

- Atlantis移动应用开发深度解析

- ASP.NET实验教程:源代码详细解析与实践

- 2012年工业观察杂志完整版

- 全国综合缴费营业厅系统11.5:一站式缴费与运营管理解决方案

- JAVA原生实现HTTP请求的简易指南

- 便携PDF浏览器:随时随地快速查看文档

- VTF格式图片编辑工具:深入起源引擎贴图修改