RFNet:区域感知融合网络解决不完全多模态脑肿瘤分割

69 浏览量

更新于2025-01-16

收藏 1.08MB PDF 举报

"RFNet: 区域感知融合网络用于不完全多模态脑肿瘤分割"

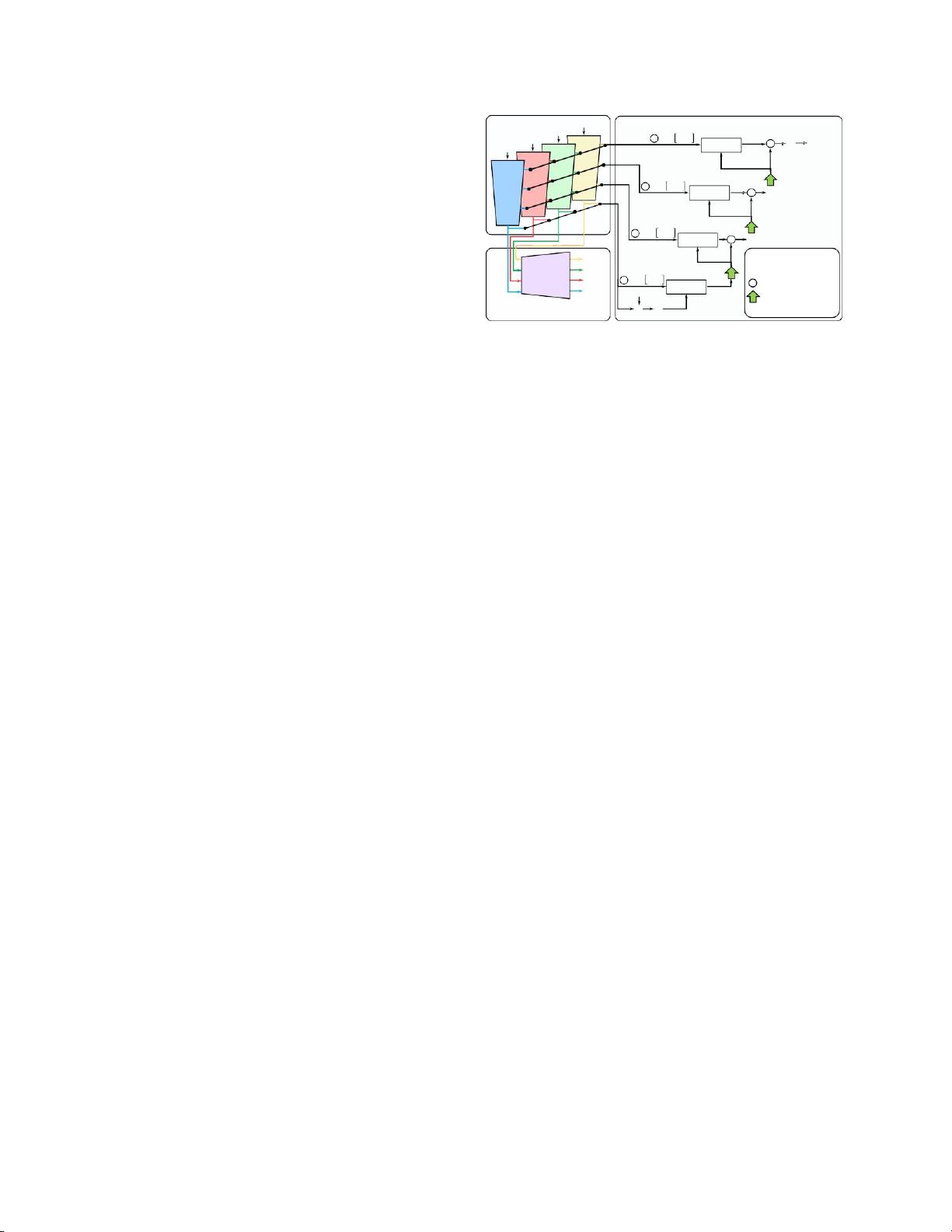

本文介绍了一种名为RFNet的区域感知融合网络,旨在解决在多模态脑肿瘤分割过程中因模态图像缺失而导致的分割性能下降问题。脑肿瘤分割是临床评估和手术规划的重要环节,传统的分割方法通常依赖于四种模态的磁共振成像(MRI)图像,包括Flair、T1c、T1和T2。然而,实际临床应用中,由于各种原因,可能会丢失其中某些模态。

RFNet的核心创新在于其区域感知融合模块(RFM),该模块能够根据可用的图像模态自适应地融合特征,对不完整的多模态数据进行有效分割。考虑到不同模态对不同脑肿瘤区域的敏感性,RFM允许网络针对各个区域选择性地融合模态特征。这种设计有助于在网络训练时避免不完整和不平衡的数据导致的问题。

为了解决由不充分和不平衡训练引发的问题,文章还提出了一种基于分割的正则化器。这个正则化器不仅从融合的模态特征中获取分割结果,还会单独从每个图像模态的编码特征中进行分割。这样,每个模态编码器被迫学习独特且区分性的特征,进而提升融合特征的表达能力。

实验结果显示,RFNet在BRATS2020、BRATS2018和BRATS2015三个数据集上的表现显著优于现有最先进的技术。这表明,RFNet成功地解决了不完全多模态数据的挑战,提高了脑肿瘤分割的准确性和实用性。

此外,作者指出,尽管已有方法尝试解决不完全多模态数据的分割问题,如Havaei等人的工作,但RFNet通过其独特的区域感知和特征融合策略,实现了更优的性能。这进一步证明了RFNet在实际临床应用中的潜在价值,特别是在面对模态图像缺失的情况下。

总结来说,RFNet是一种创新的深度学习模型,专门针对不完全多模态MRI图像的脑肿瘤分割问题。通过区域感知融合模块和基于分割的正则化器,RFNet能够在不完整数据集上实现高质量的分割效果,对于推动医学影像分析领域的发展具有重要意义。

752 浏览量

167 浏览量

127 浏览量

2022-12-15 上传

281 浏览量

427 浏览量

452 浏览量

246 浏览量

cpongm

- 粉丝: 6

最新资源

- WebDrive v16.00.4368: 简易易用的Windows风格FTP工具

- FirexKit:Python的FireX库组件

- Labview登录界面设计与主界面跳转实现指南

- ASP.NET JS引用管理器:解决重复问题

- HTML5 canvas绘图技术源代码下载

- 昆仑通态嵌入版ASD操舵仪软件应用解析

- JavaScript实现最小公倍数和最大公约数算法

- C++中实现XML操作类的方法与应用

- 设计编程工具集:材料重量快速计算指南

- Fancybox:Jquery图片轮播幻灯弹窗插件推荐

- Splunk Fitbit:全方位分析您的活动与睡眠数据

- Emoji表情编码资源及数据库查询实现

- JavaScript实现图片编辑:截取、旋转、缩放功能详解

- QNMS系统架构与应用实践

- 微软高薪面试题解析:通向世界500强的挑战

- 绿色全屏大气园林设计企业整站源码与多技术项目资源