批量最优传输损失提升3D形状识别与深度度量学习性能

38 浏览量

更新于2025-01-16

收藏 1.51MB PDF 举报

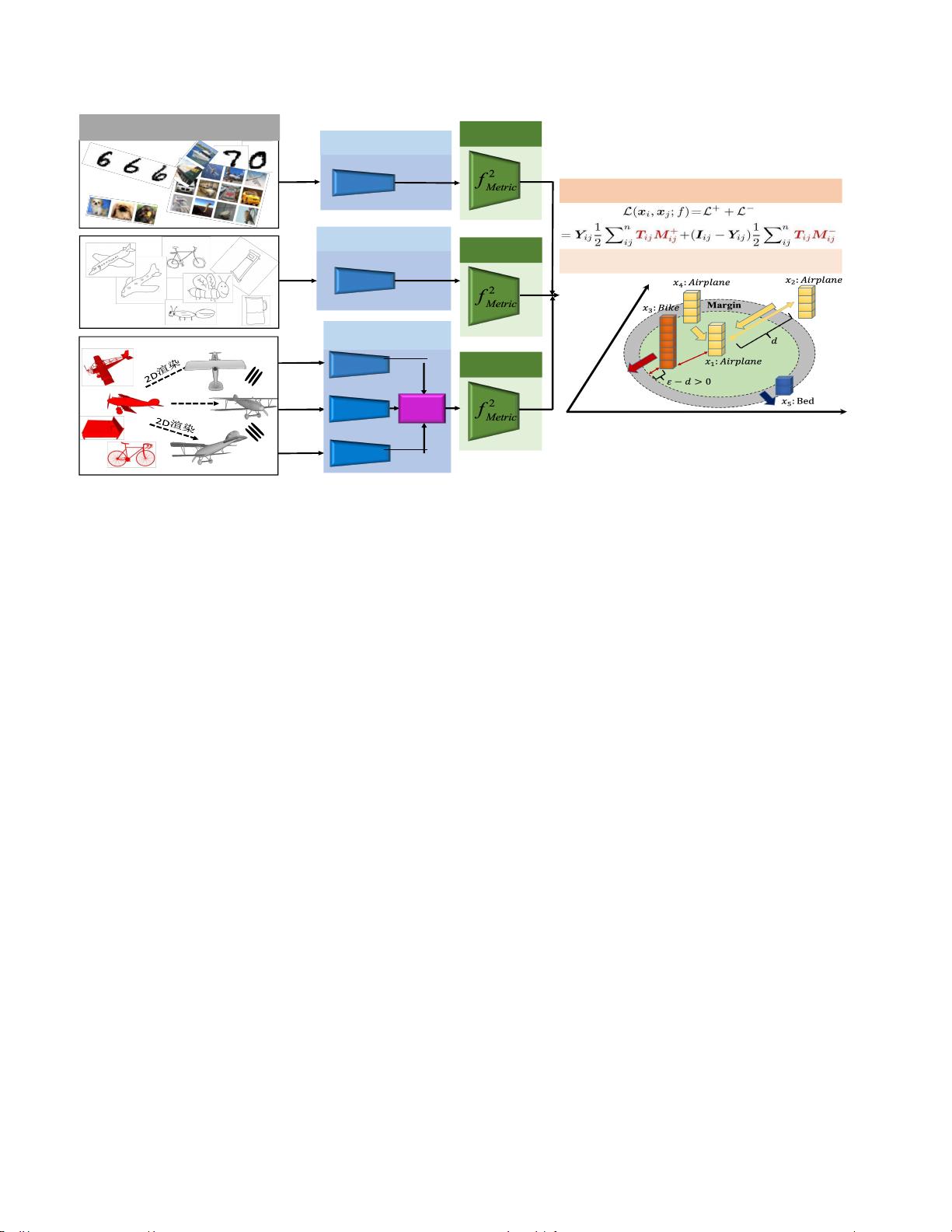

本文主要探讨了基于批量最优传输损失的3D形状识别与深度度量学习相结合的方法。传统的深度度量学习,如常用的两两(或三重)损失目标,存在一些局限性,如无法充分挖掘训练样本的语义信息,对困难样本的关注不足,这导致了学习过程中的收敛速度慢和性能不佳。为了克服这些问题,研究者提出了新的批量最优传输损失。

批量最优传输损失的核心思想是通过优化过程中的批量样本,学习到一个能够自动强调困难样本、驱动收敛的重要性驱动的距离度量。这种方法不再局限于单对或少数样本之间的比较,而是利用整个训练批次的信息,使得相似的正样本被紧密聚类,不相似的负样本被有效分离。这通过批量运输规划得以实现,使得模型能更有效地处理具有大差异的正样本和小差异的负样本,从而提升学习效率。

作者将这个新损失与深度度量学习结合,构建了一个端到端的深度学习框架,用于学习深度特征表示和嵌入度量。实验结果显示,这种方法在MNIST、CIFAR10、SHREC13、SHREC14、ModelNet10和ModelNet40等多个3D形状识别任务上表现优秀,不仅能显著加速模型收敛,还能达到当前最先进的识别性能。

例如,在3D形状识别的具体实验中,研究者发现他们的方法在较短的学习周期内就能取得优于传统方法的识别效果。这不仅证明了批量最优传输损失的有效性,也表明其在实际应用中具有更高的效率和准确性。此外,论文还提到了批量最优传输损失在其他领域的应用潜力,如人脸识别和基于草图的识别,显示出其广泛适用性。

这篇论文为深度度量学习领域提供了一个有力的工具,通过改进损失函数设计,促进了3D形状识别等任务的性能提升,为未来的研究者和开发者提供了新的思路和技术支持。

点击了解资源详情

129 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- 初学者入门必备!Visual C++开发的连连看小程序

- C#实现SqlServer分页存储过程示例分析

- 西门子工业网络通信例程解读与实践

- JavaScript实现表格变色与选中效果指南

- MVP与Retrofit2.0相结合的登录示例教程

- MFC实现透明泡泡效果与文件操作教程

- 探索Delphi ERP框架的核心功能与应用案例

- 爱尔兰COVID-19案例数据分析与可视化

- 提升效率的三维石头制作插件

- 人脸C++识别系统实现:源码与测试包

- MishMash Hackathon:Python编程马拉松盛事

- JavaScript Switch语句练习指南:简洁注释详解

- C语言实现的通讯录管理系统设计教程

- ASP.net实现用户登录注册功能模块详解

- 吉时利2000数据读取与分析教程

- 钻石画软件:从设计到生产的高效解决方案