深度学习去雨:神经元重组提升泛化能力

135 浏览量

更新于2025-01-16

收藏 1.27MB PDF 举报

"神经元重组提高图像去雨能力"

在图像去雨领域,深度学习模型已经取得显著进步,但它们通常在单一合成数据集上学习固定的雨/干净图像映射,这限制了它们在复杂多变的真实雨天场景中的泛化能力。针对这一问题,研究者首次提出了一种神经元重组(NR)方法,旨在整合多个合成数据集的训练知识,以增强深度网络的泛化性能。

在传统的深度模型训练中,模型在单一数据集上学习后,其参数保持不变,导致对未知雨型的处理能力较弱。为了解决这个问题,文章提出了NR算法,该算法借鉴生物大脑的突触巩固机制和知识蒸馏技术。在训练结束后,NR允许去雨网络在保持稳定性的同时,适应新信息,避免灾难性遗忘。这样,模型能够在一系列合成雨数据集上进行训练,形成一个通用的去雨网络,适应多种雨型。

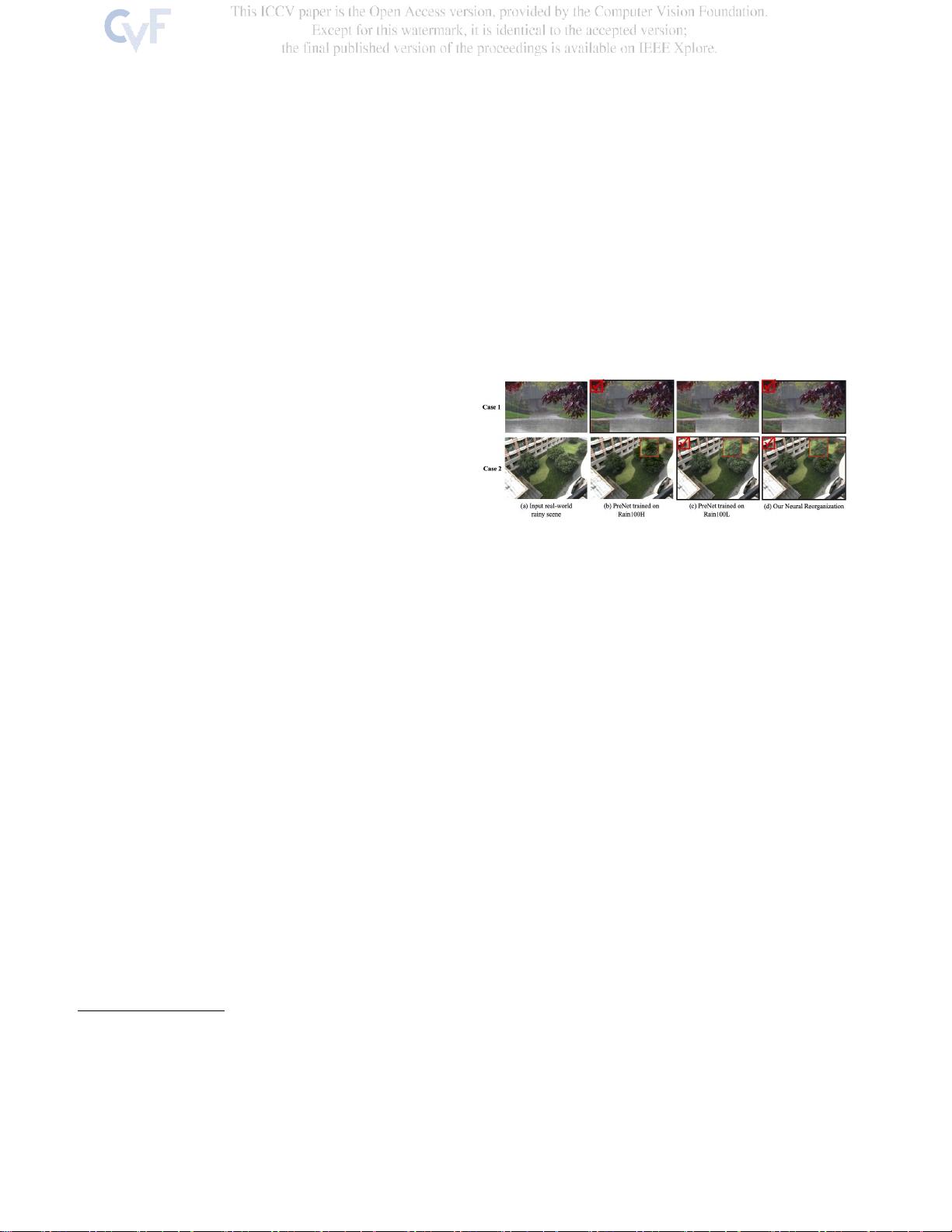

实验结果证明,采用NR的深度模型不仅能够一致地处理多个合成数据集,而且在处理真实世界雨图像时,表现优于最先进的方法。例如,与PreNet相比,提出的神经重组方案能有效地应对大雨和小雨等各种雨天场景,而PreNet则可能在未见过的雨型上表现不佳。

此外,图像去雨任务对于下游的计算机视觉任务至关重要,如物体检测、图像分类和人脸识别。因此,提高去雨网络的泛化能力对于提升整个计算机视觉系统的性能具有深远影响。通过引入神经元重组,研究为深度学习模型在真实世界复杂环境中的应用提供了新的思路和解决方案,有助于推动图像去雨技术的发展。

2023-05-29 上传

2023-08-30 上传

2018-08-06 上传

2022-07-14 上传

2009-06-16 上传

143 浏览量

251 浏览量

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- 武汉大学数字图像处理课程课件精要

- 搭建个性化知识付费平台——Laravel开发MeEdu教程

- SSD7练习7完整解答指南

- Android中文API合集第三版:开发者必备指南

- Python测试自动化实践:深入理解更多测试案例

- 中国风室内装饰网站模板设计发布

- Android情景模式中音量定时控制与铃声设置技巧

- 温度城市的TypeScript实践应用

- 新版高通QPST刷机工具下载支持高通CPU

- C++实现24点问题求解的源代码

- 核电厂水处理系统的自动化控制解决方案

- 自定义进度条组件AMProgressView用于统计与下载进度展示

- 中国古典红木家具网页模板免费下载

- CSS定位技术之Position-master解析

- 复选框状态持久化及其日期同步技术

- Winform版HTML编辑器:强大功能与广泛适用性