远程监控下3D凝视估计:利用眼头身协同的精确方法

PDF格式 | 968KB |

更新于2025-01-16

| 127 浏览量 | 举报

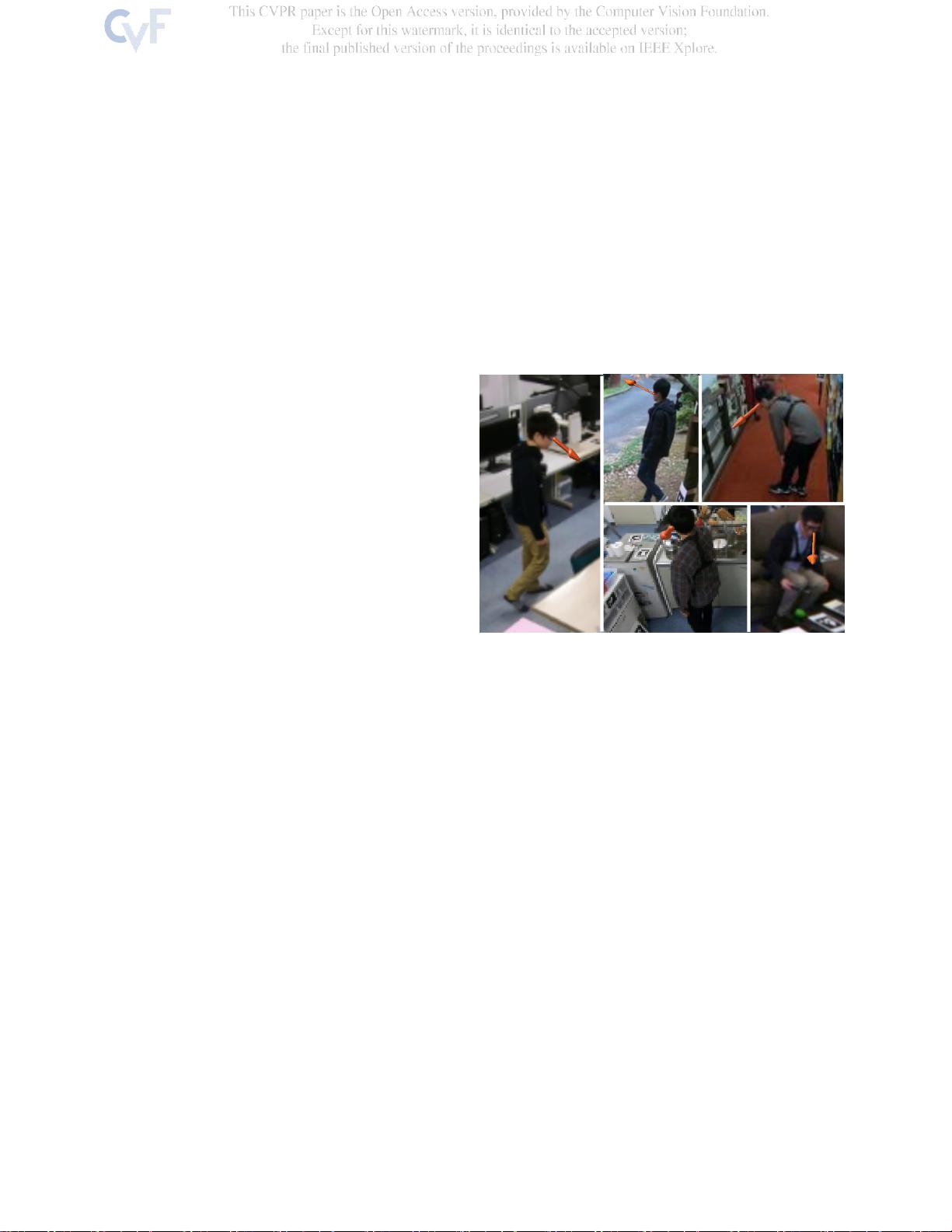

"基于眼-头-身时间坐标的3D凝视估计是一项新颖的研究,旨在解决在远程监控视频中精确追踪人的视线方向的问题。传统的凝视估计方法往往依赖于眼睛的清晰特写图像,但在远距离、遮挡和低分辨率的情况下,这种方法效果受限。我们的研究团队,由京都大学研究生院情报学研究科PRESTO的野中相马等人主导,提出了一个创新性的解决方案。

他们将视线估计转化为贝叶斯预测,利用人类在看东西时目光、头部和身体之间自然的协调性,不仅考虑眼睛的运动,还结合头部和身体的运动轨迹来推断3D凝视方向。这种方法设计了专门的神经网络模型,分别处理头部和身体方向的似然性,以及与注视方向相关的条件先验,最终通过级联输出获得更为准确的3D估计。

为了支持这项研究,研究人员开发了一个全新的动态3D凝视估计监控视频数据集,该数据集包含了在五个不同室内和室外场景中录制的视频,所有视频都经过3D凝视方向的标注。通过在该数据集以及其他数据集上的实验,结果证实了新方法的有效性和准确性,即使在摄像机无法捕捉到面部的情况下,也能从典型监控距离精确估计出注视方向。

传统上,从远处的监控图像进行凝视估计被视为挑战,因为许多方法只能处理近距离或正对镜头的情况。然而,该研究的突破性工作证明了可以从几米到十几米的监视视角进行有效的凝视估计,甚至当人背对摄像头时,也能够判断他们的注视方向。这为实时监控中的行为理解和分析提供了强大的工具,例如对老年人日常活动的监测,有助于洞察个体的心理状态和需求,而不只是表面行为。"

这项研究不仅提升了动态3D凝视估计的准确性和适用范围,而且推动了计算机视觉领域在实际监控场景中的应用,具有显著的实际价值和社会意义。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 自动生成CAD模型文件的测试流程

- 掌握JavaScript中的while循环语句

- 宜科高分辨率编码器产品手册解析

- 探索3CDaemon:FTP与TFTP的高效传输解决方案

- 高效文件对比系统:快速定位文件差异

- JavaScript密码生成器的设计与实现

- 比特彗星1.45稳定版发布:低资源占用的BT下载工具

- OpenGL光源与材质实现教程

- Tablesorter 2.0:增强表格用户体验的分页与内容筛选插件

- 设计开发者的色值图谱指南

- UYA-Grupo_8研讨会:在DCU上的培训

- 新唐NUC100芯片下载程序源代码发布

- 厂家惠新版QQ空间访客提取器v1.5发布:轻松获取访客数据

- 《Windows核心编程(第五版)》配套源码解析

- RAIDReconstructor:阵列重组与数据恢复专家

- Amargos项目网站构建与开发指南