APSUM:稀疏主题模型用于在线评论的细粒度摘要生成

PDF格式 | 1.8MB |

更新于2025-01-16

| 197 浏览量 | 举报

"在线评论中生成细粒度摘要:稀疏主题模型(APSUM)"

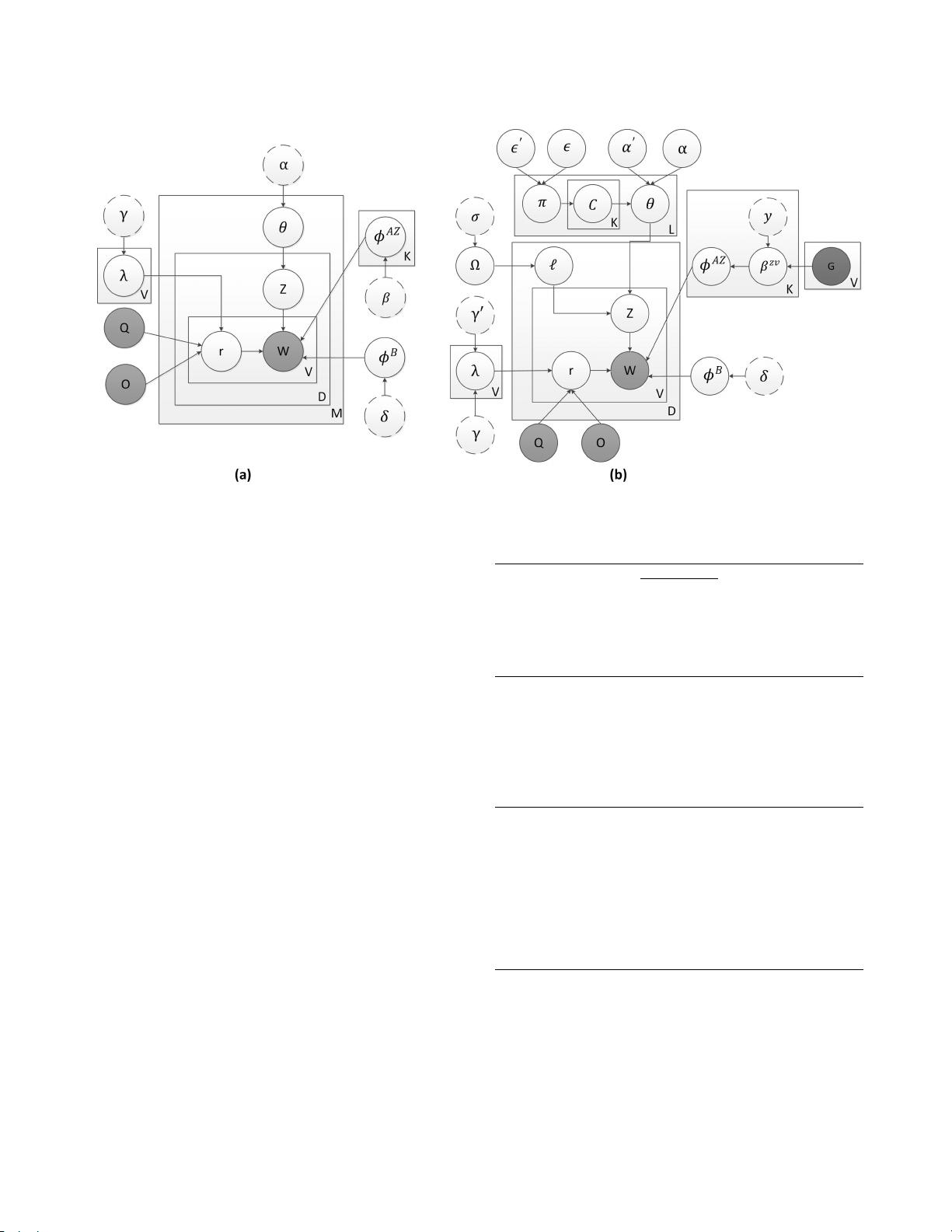

本文主要探讨了如何利用一种名为APSUM(Aspect-based Summarization with Sparse Topic Model)的稀疏主题模型,从在线评论中抽取特定方面的摘要,以帮助消费者在购买决策过程中更有效地获取信息。随着电子商务的发展,消费者在购买产品前会参考大量的在线评论,但这些评论往往数量庞大,难以逐一阅读。针对这一问题,APSUM模型旨在生成细粒度的摘要,将评论的关键信息归纳到不同的产品方面,如性能、功能或质量等。

APSUM模型的核心在于处理方面稀疏性的问题。一方面,它采用了尖峰和厚板先验(spike-and-slab prior)来调整文档的主题分布,这种分布允许模型在识别主题时保持一定的灵活性,同时也能捕捉到与特定方面相关的稀疏信息。另一方面,模型还引入了语言监督词(linguistic supervision word)来引导主题建模,确保生成的摘要能够紧密围绕消费者关心的特定方面。

在实验部分,APSUM模型在多个数据集上与其他先进的方面摘要模型进行了比较,结果表明APSUM在性能上优于现有方法,能生成更具洞察力的细粒度摘要。这些摘要可以帮助消费者快速定位他们关注的产品特性,从而简化购买决策过程。

该研究进一步关联了几个计算机科学领域的关键概念,如数据挖掘、信息检索、文档主题模型和机器学习。其中,主题建模是APSUM模型的核心技术,通过概率生成模型分析文本数据,识别出隐藏的主题结构。信息检索则涉及如何从大量评论中提取与消费者查询相关的信息。

APSUM模型为在线评论的处理提供了新的视角,通过细致入微的摘要生成,提升了消费者获取产品信息的效率,同时也为电子商务平台提供了优化用户体验的工具。该研究对于理解和改进在线评论的处理方式具有重要的理论与实践意义。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 网页自动刷新工具 v1.1 - 自定义时间间隔与关机

- pt-1.4协程源码深度解析

- EP4CE6E22C8芯片三相正弦波发生器设计与实现

- 高效处理超大XML文件的查看工具介绍

- 64K极限挑战:国际程序设计大赛优秀3D作品展

- ENVI软件全面应用教程指南

- 学生档案管理系统设计与开发

- 网络伪书:社区驱动的在线音乐制图平台

- Lettuce 5.0.3中文API文档完整包下载指南

- 雅虎通Yahoo! Messenger v0.8.115即时聊天功能详解

- 将Android手机转变为IP监控摄像机

- PLSQL入门教程:变量声明与程序交互

- 掌握.NET三层架构:实例学习与源码解析

- WPF中Devexpress GridControl分组功能实例分析

- H3Viewer: VS2010专用高效帮助文档查看工具

- STM32CubeMX LED与按键初始化及外部中断处理教程