深度学习驱动的大规模图像搜索优化:CNN模型与GPU效率探索

PDF格式 | 1.3MB |

更新于2025-01-16

| 89 浏览量 | 举报

“深度学习技术在大规模图像搜索中的应用与优化”

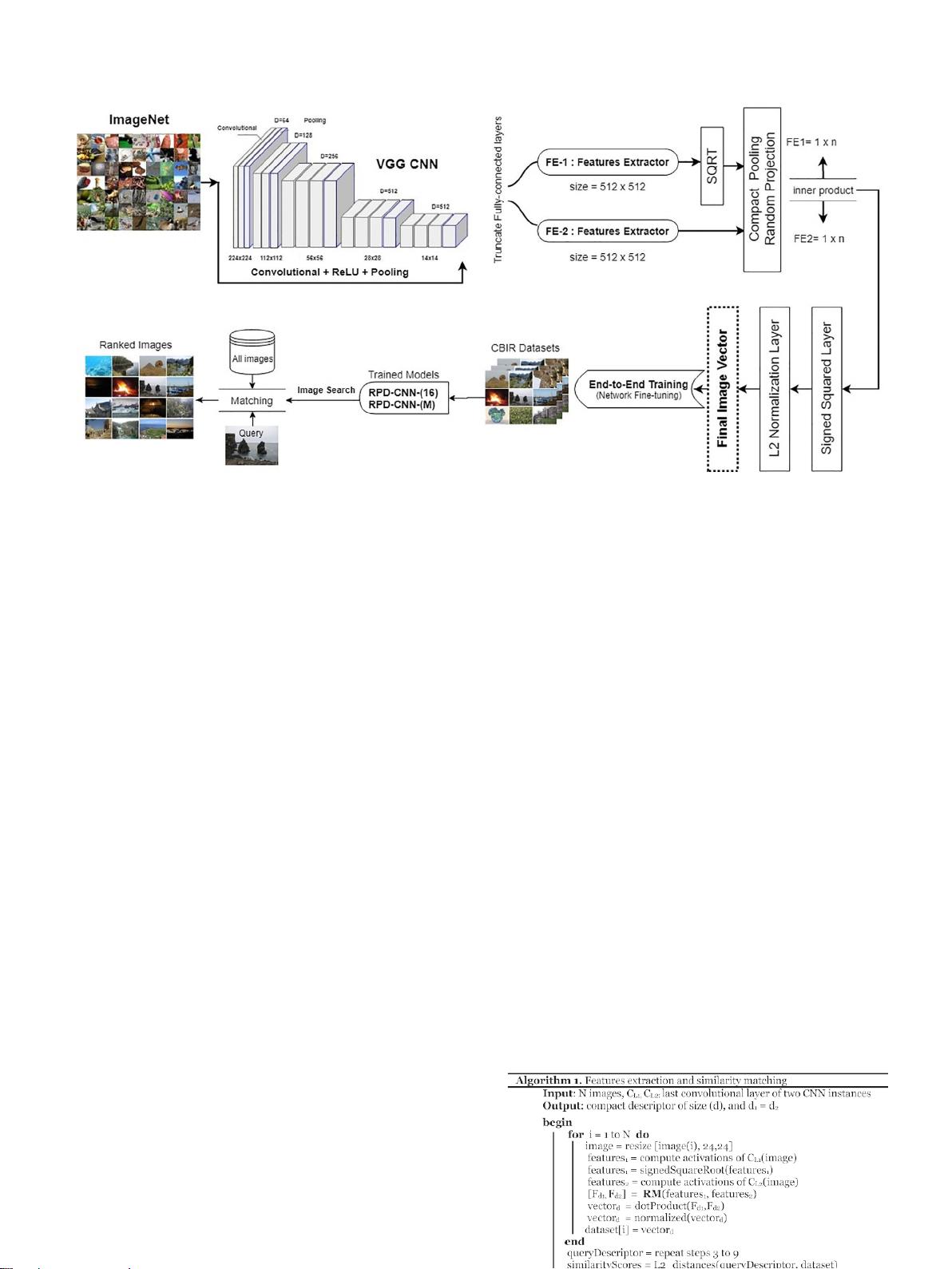

本文主要探讨了深度学习技术在大规模图像搜索中的应用及其优化策略,特别是利用卷积神经网络(CNN)进行图像检索。随着深度学习模型的发展,它们在处理和提取复杂图像特征方面的能力显著提升,为解决计算机视觉问题提供了新途径。然而,这些模型的计算需求高,尤其是在处理大规模图像库时。

文章中,作者介绍了如何利用随机麦克劳林投影生成低维图像描述子,这种方法旨在降低特征维度,同时保持足够的鉴别能力。通过在标准图像数据集上进行实验,评估了这种低维表示的效率。此外,作者还在高性能计算(HPC)平台上对一个包含100万个图像的数据集进行了深度学习架构的可扩展性评估,关注点在于检索准确性、特征提取速度以及内存成本。

在实际应用中,GPU的性能对于深度学习模型的运行至关重要。因此,作者还研究了几种优化因素,如控制GPU内核,以提升处理和检索性能。实验结果显示,所提出的模型在多个关键指标上表现出色,包括检索精度、GPU利用率、特征提取速度和图像索引存储。

深度学习模型的扩展性和优化对于应对大规模图像检索的挑战至关重要。尽管深度学习算法和架构的计算复杂性较高,但通过有效的优化策略,可以实现高效、精确的图像搜索。这包括对模型的调整、并行化以及针对特定硬件(如GPU)的优化,以充分利用其计算能力。

在当前的计算机视觉研究中,深度学习已经成为主流,尤其在图像识别、场景理解等任务上。深度预训练的CNN模型可以从大量训练数据中学习到通用特征,这些特征可以被转移到其他任务中,提高整体性能。与传统的机器学习方法相比,CNN在许多应用场景中表现出了优越性。

这篇论文强调了深度学习在大规模图像搜索中的潜力,同时也指出了优化这些模型以适应大规模数据集的重要性。通过深入研究和实践,可以进一步提升深度学习在图像检索领域的效率和效果,推动计算机视觉技术的进步。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 久度免费文件代存系统 v1.0:全技术领域源码分享

- 深入解析caseyjpaul.github.io的HTML结构

- HTML5视频播放器的实现与应用

- SSD7练习9完整答案解析

- 迅捷PDF完美转PPT技术:深度识别PDF内容

- 批量截取子网页工具:Python源码分享与使用指南

- Kotlin4You: 探索设计模式与架构概念

- 古典风格茶园茶叶酿制企业网站模板

- 多功能轻量级jquery tab选项卡插件使用教程

- 实现快速增量更新的jar包解决方案

- RabbitMQ消息队列安装及应用实战教程

- 简化操作:一键脚本调用截图工具使用指南

- XSJ流量积算仪控制与数显功能介绍

- Android平台下的AES加密与解密技术应用研究

- Место-响应式单页网站的项目实践

- Android完整聊天客户端演示与实践