模板引导的图像抠图:基于渐进细化网络与粗糙模板

157 浏览量

更新于2025-01-16

收藏 2.46MB PDF 举报

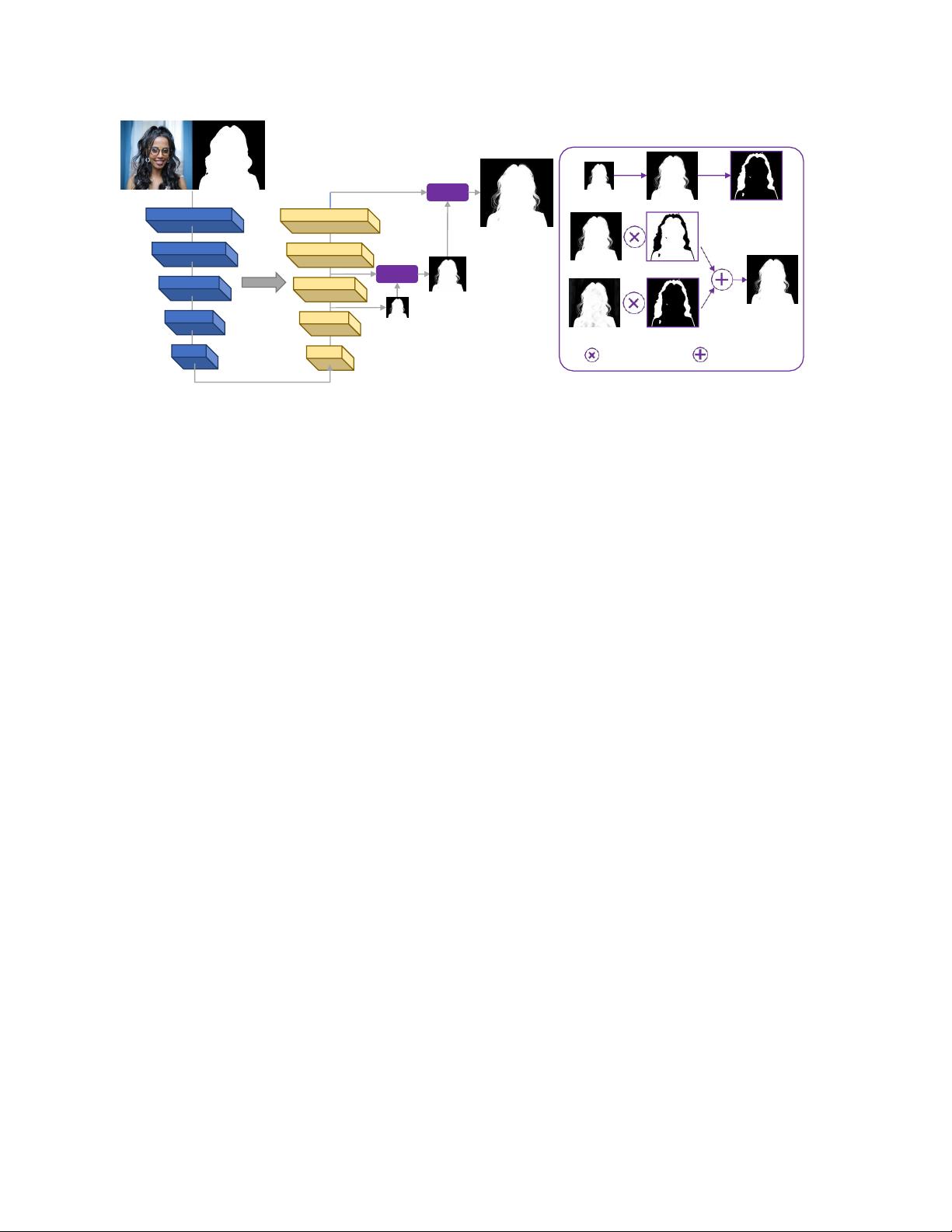

"这篇论文提出了一种新的图像抠图方法,称为基于粗糙模板的模板引导抠图(MGMatting),该方法利用渐进细化网络(PRN)来逐步细化不确定区域,尤其适用于无三重图抠图场景。通过在训练过程中引入一系列指导罩扰动,PRN能够适应不同类型如三重图和低质量alpha蒙版的指导输入,扩大了其在各种应用场景中的适用性。此外,论文还提出了一种简单的前景色预测改进,解决了数据集问题。MGMatting在真实和合成基准测试中表现出最先进的性能,并且代码和模型已在GitHub上开源。"

本文主要关注的是图像抠图技术,这是一个基础的计算机视觉任务,旨在预测图像中特定区域的alpha抠图。传统方法通常依赖于trimap作为辅助输入,但trimap的创建对用户来说较为繁琐,限制了其在非交互式应用中的使用。因此,研究开始转向无三重图抠图,即无需trimap的解决方案。

作者提出的方法名为Mask Guided (MG) Matting,它基于渐进细化网络(Progressive Refinement Network,PRN)。PRN的独特之处在于它能自我指导,通过解码过程逐渐细化那些边界模糊或不确定的区域。在训练阶段,通过一系列指导罩的扰动,PRN得以适应不同类型的指导输入,包括未见过的三重图和低质量的alpha蒙版,这使得它能广泛应用于各种图像处理管道。

此外,论文还探讨了前景色预测问题,并提出了一种简洁的改进策略,有效解决了数据集存在的问题。这一改进对于在复杂现实世界图像上推广抠图模型至关重要。通过对真实世界和合成图像基准的评估,MGMatting展示了卓越的性能,证明了其在各种指导输入类型下的有效性。

为了促进研究和应用,MGMatting的代码和模型已公开发布在GitHub上,可供其他研究者和开发者使用和进一步开发。这种方法的贡献在于提供了一种更灵活、更具适应性的图像抠图解决方案,降低了对精确人类标注的依赖,提升了无三重图抠图的准确性和实用性。

263 浏览量

948 浏览量

2023-04-15 上传

150 浏览量

221 浏览量

265 浏览量

163 浏览量

2025-01-03 上传

163 浏览量

cpongm

- 粉丝: 6

最新资源

- 支付宝订单监控免签工具:实时监控与信息通知

- 一键永久删除QQ空间说说的绿色软件

- Appleseeds训练营第4周JavaScript练习

- 免费HTML转CHM工具:将网页文档化简成章

- 奇热剧集站SEO优化模板下载

- Python xlrd库:实用指南与Excel文件读取

- Genegraph:通过GraphQL API使用Apache Jena展示RDF基因数据

- CRRedist2008与CRRedist2005压缩包文件对比分析

- SDB交流伺服驱动系统选型指南与性能解析

- Android平台简易PDF阅读器的实现与应用

- Mybatis实现数据库物理分页的插件源码解析

- Docker Swarm实例解析与操作指南

- iOS平台GTMBase64文件的使用及解密

- 实现jQuery自定义右键菜单的代码示例

- PDF处理必备:掌握pdfbox与fontbox jar包

- Java推箱子游戏完整源代码分享