硬感知深度度量学习:挖掘全部样本信息的新框架

PDF格式 | 1.76MB |

更新于2025-01-16

| 86 浏览量 | 举报

"硬感知深度度量学习框架是针对深度度量学习中的一种新方法,旨在优化数据嵌入,提高样本间的相似性度量。该框架通过线性插值和标签合成策略,解决传统深度度量学习方法中训练样本不足的问题,从而充分利用所有样本信息,提升度量的挑战性和准确性。在CUB-200-2011、Cars196和StanfordOnlineProducts等数据集上,该方法展现出优秀的性能。"

深度度量学习是机器学习领域的一个重要分支,其目标是学习一个映射,将原始数据转换到一个特征空间,使得在这个空间中,相似的数据点之间的距离更小,不相似的数据点之间的距离更大。深度神经网络常被用作构建这个映射,因为它能学习到复杂的非线性特征表示。

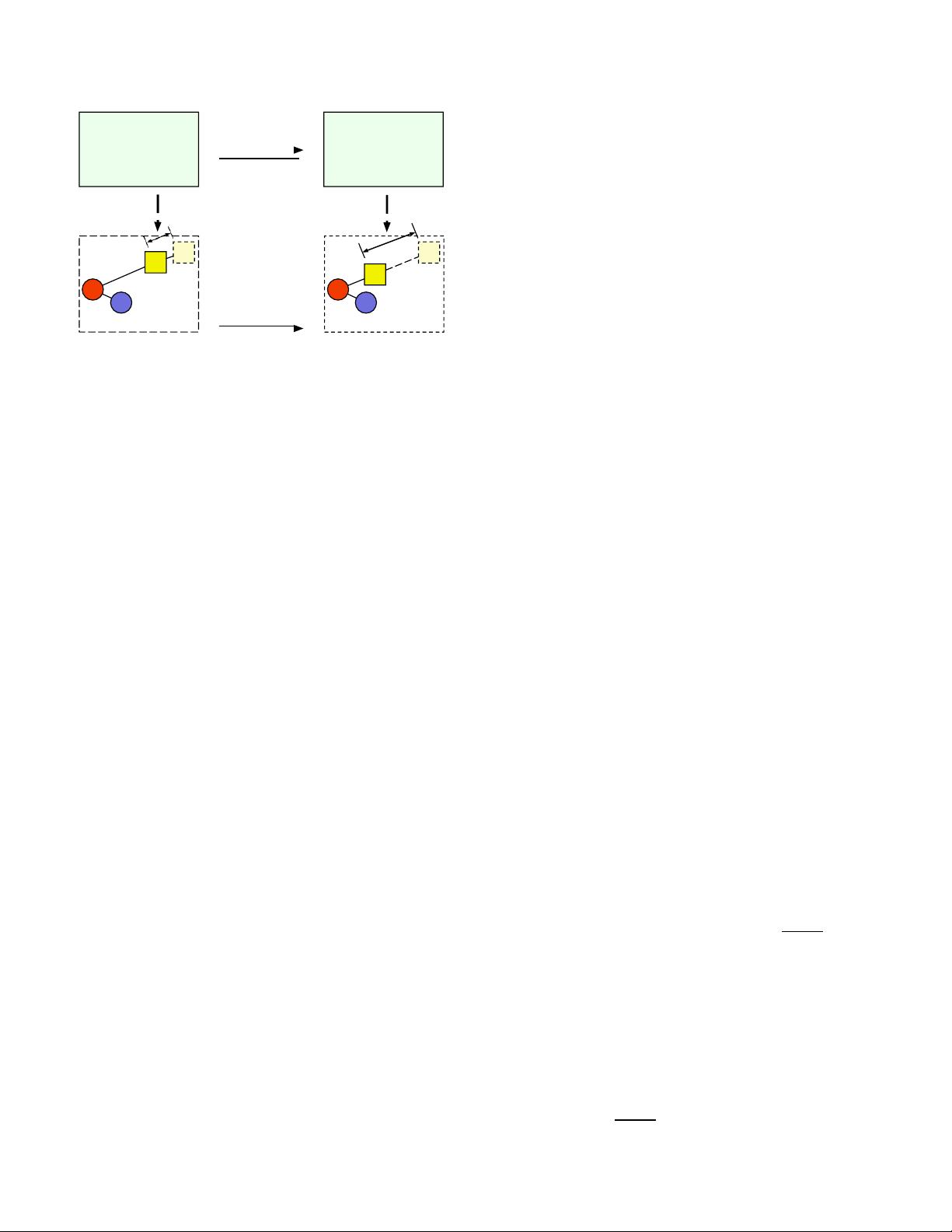

传统的深度度量学习方法通常依赖于“硬否定挖掘”策略,这种方法只选取部分训练样本进行处理,可能导致丢失全局嵌入空间的几何信息。为解决这一问题,硬感知深度度量学习(HDML)框架引入了线性插值。线性插值用于调整样本的“硬水平”,即样本所属类别间的距离,以此生成新的合成样本。这些合成样本保留了原始标签,同时通过调整它们的“硬度”(类间距离),能够更好地反映全局嵌入空间的结构。

此外,HDML框架还利用了一个标签合成器,它能够在保持原有标签不变的情况下,生成新的训练样本,这有助于再循环训练,确保所有样本的信息都被充分挖掘。这种自适应的硬度控制策略不会改变同一类别内样本的距离,确保了类内的紧密度,同时增加了类间的区分度。

这种方法对于图像检索、行人重识别和地理定位等任务具有显著优势。通过在多个基准数据集上的实验,硬感知深度度量学习证明了其在提升模型性能和泛化能力方面的优越性,为深度度量学习提供了新的思路和方法。

硬感知深度度量学习框架是一种创新性的深度学习技术,它通过改进样本处理方式,增强了度量学习的效果,尤其是在处理有限样本和复杂数据分布时。这一框架的应用和研究将有助于推动深度学习在图像识别、模式匹配和相关领域的进步。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 支付宝订单监控免签工具:实时监控与信息通知

- 一键永久删除QQ空间说说的绿色软件

- Appleseeds训练营第4周JavaScript练习

- 免费HTML转CHM工具:将网页文档化简成章

- 奇热剧集站SEO优化模板下载

- Python xlrd库:实用指南与Excel文件读取

- Genegraph:通过GraphQL API使用Apache Jena展示RDF基因数据

- CRRedist2008与CRRedist2005压缩包文件对比分析

- SDB交流伺服驱动系统选型指南与性能解析

- Android平台简易PDF阅读器的实现与应用

- Mybatis实现数据库物理分页的插件源码解析

- Docker Swarm实例解析与操作指南

- iOS平台GTMBase64文件的使用及解密

- 实现jQuery自定义右键菜单的代码示例

- PDF处理必备:掌握pdfbox与fontbox jar包

- Java推箱子游戏完整源代码分享