深度学习与连续广义零次学习:动态适应新类的框架

124 浏览量

更新于2025-01-16

收藏 1.96MB PDF 举报

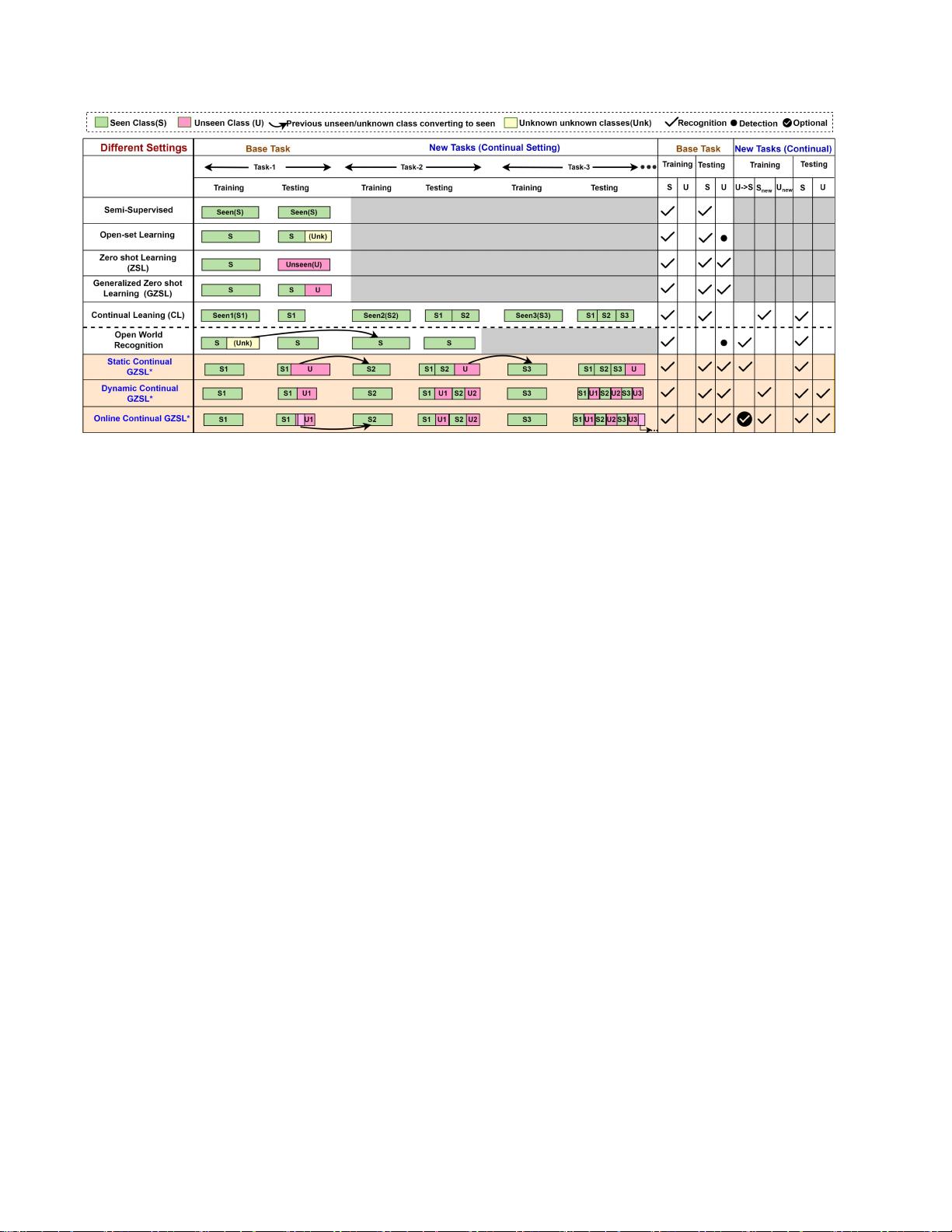

"这篇论文探讨了有限监督学习的最新发展,特别是关注连续广义零次学习(Continuous Generalized Zero-Shot Learning, CGSRL)和在线设置。在这些环境中,模型需要在没有大量标记数据的情况下适应新类别的出现。文章介绍了深度神经网络(DNNs)在计算机视觉应用中的广泛使用,但也指出了它们对大规模标记数据的依赖限制了其在现实世界中的应用。现实世界的数据分布往往遵循长尾分布,导致部分类别难以获取充分的标注样本。"

1. 知识点解析

(1) 有限监督学习:有限监督学习是指在有限的标记样本下训练模型,目标是让模型能够泛化到未见过的样本或类别。在这种情况下,模型必须学会从少量示例中学习抽象特征。

(2) 广义零次学习(Generalized Zero-Shot Learning, GSTOL):在GSTOL中,模型在训练时并未接触过所有类别的数据,但在测试时需要识别新类别。这通常通过利用类别之间的先验知识(如属性或语义关系)来实现。

(3) 连续广义零次学习(Continuous Generalized Zero-Shot Learning, CGSRL):CGSRL扩展了GSTOL,允许模型在运行过程中不断适应新的可见和不可见类别,这更符合实际场景,其中新类别可能会不断出现。

(4) 在线学习:在线学习是一种动态学习方式,模型在接收新数据时不断更新,无需重新训练整个数据集。这对于处理连续流式数据和适应新类别至关重要。

(5) 灾难性遗忘:当模型在学习新任务时忘记旧任务,称为灾难性遗忘。这是在线学习和终身学习中的一个挑战,因为它会导致模型的泛化性能下降。

(6) 双向增量对齐:为了克服灾难性遗忘和适应新类别,论文提出了一种统一的特征生成框架——CGCARL,利用双向增量对齐方法,使模型能够在不丢失已有类别知识的同时,有效学习新类别的特征。

(7) 基准数据集:论文通过在五个基准数据集上进行实验,评估了提出的CGCARL方法的效果,这表明其在CGSRL和更实用的在线设置上都优于现有方法。

2. 技术应用

深度神经网络在计算机视觉任务中广泛应用,但对大量标记数据的依赖限制了它们在现实世界中的有效性。CGSRL和在线学习的研究旨在解决这个问题,使模型能够处理现实世界的动态变化。CGCARL框架提供了一种灵活且适应性强的方法,它能够在新类别出现时动态调整,且不受标记数据的限制。

3. 结论

该研究对于有限监督学习领域具有重要意义,它推动了模型在实际场景中的应用,尤其是在新类别不断出现的情况下。提出的CGCARL框架为解决连续广义零次学习中的挑战提供了一种实用的解决方案,有助于提升模型的泛化能力和适应性。

基于MATLAB的广义连续函数碰撞检测框架下的无人机运动规划:详细解析与学习参考,广义连续函数碰撞检测框架(CCD)的无人机运动规划 基于MATLAB建立广义连续函数碰撞检测框架(CCD)的无人机运动

2025-02-09 上传

125 浏览量

1389 浏览量

1492 浏览量

280 浏览量

286 浏览量

点击了解资源详情

386 浏览量

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- 易酷免费影视系统:开源网站代码与简易后台管理

- Coursera美国人口普查数据集及使用指南解析

- 德加拉6800卡监控:性能评测与使用指南

- 深度解析OFDM关键技术及其在通信中的应用

- 适用于Windows7 64位和CAD2008的truetable工具

- WM9714声卡与DW9000网卡数据手册解析

- Sqoop 1.99.3版本Hadoop 2.0.0环境配置指南

- 《Super Spicy Gun Game》游戏开发资料库:Unity 2019.4.18f1

- 精易会员浏览器:小尺寸多功能抓包工具

- MySQL安装与故障排除及代码编写全攻略

- C#与SQL2000实现的银行储蓄管理系统开发教程

- 解决Windows下Pthread.dll缺失问题的方法

- I386文件深度解析与oki5530驱动应用

- PCB涂覆OSP工艺应用技术资源下载

- 三菱PLC自动调试台程序实例解析

- 解决OpenCV 3.1编译难题:配置必要的库文件