upworks通过自我训练[28]、自我升华[42] [13]等进一

步提高性能。

具有知识转移的弱监督目标检测。迁移学习通常用

于 域 适 应 ( DA ) [38] 。 它 可 以 桥 接 不 同 的 数 据 集

[36],类别[3],甚至任务[11,12],这降低了训练成

本,并利用了来自另一个数据集/域/任务的知识。在本

文中,我们专注于弱监督对象检测中的知识转移。附

加数据通常用于提供用于检测的辅助先验信息[35,1]

使用类别标签文本的词嵌入来表示类别之间的语义关

系,并且使用类别的依赖性来辅助对象检测。[30,

29,19]将在源域中学习的模型转移到目标域。此外,

一些作品[15,11,35]使用权重预测来有效地将图像

分类器转换为对象检测器。最近的研究[6,37,18,

23]提出了共享源域中学习到的一般知识的想法。知识

可以是对象预测器[6,23],对象候选区域[37]或一般

边界框回归[18,43]。然而,由于两个数据集的类别

通常是不相同的,现有的大多数方法在这种情况下都

不起作用。在本文中,我们将WSOD与平均教师框架

相结合,以充分利用来自公共全监督数据集和弱监督

数据集的知识,这也可以解决类别不匹配问题。

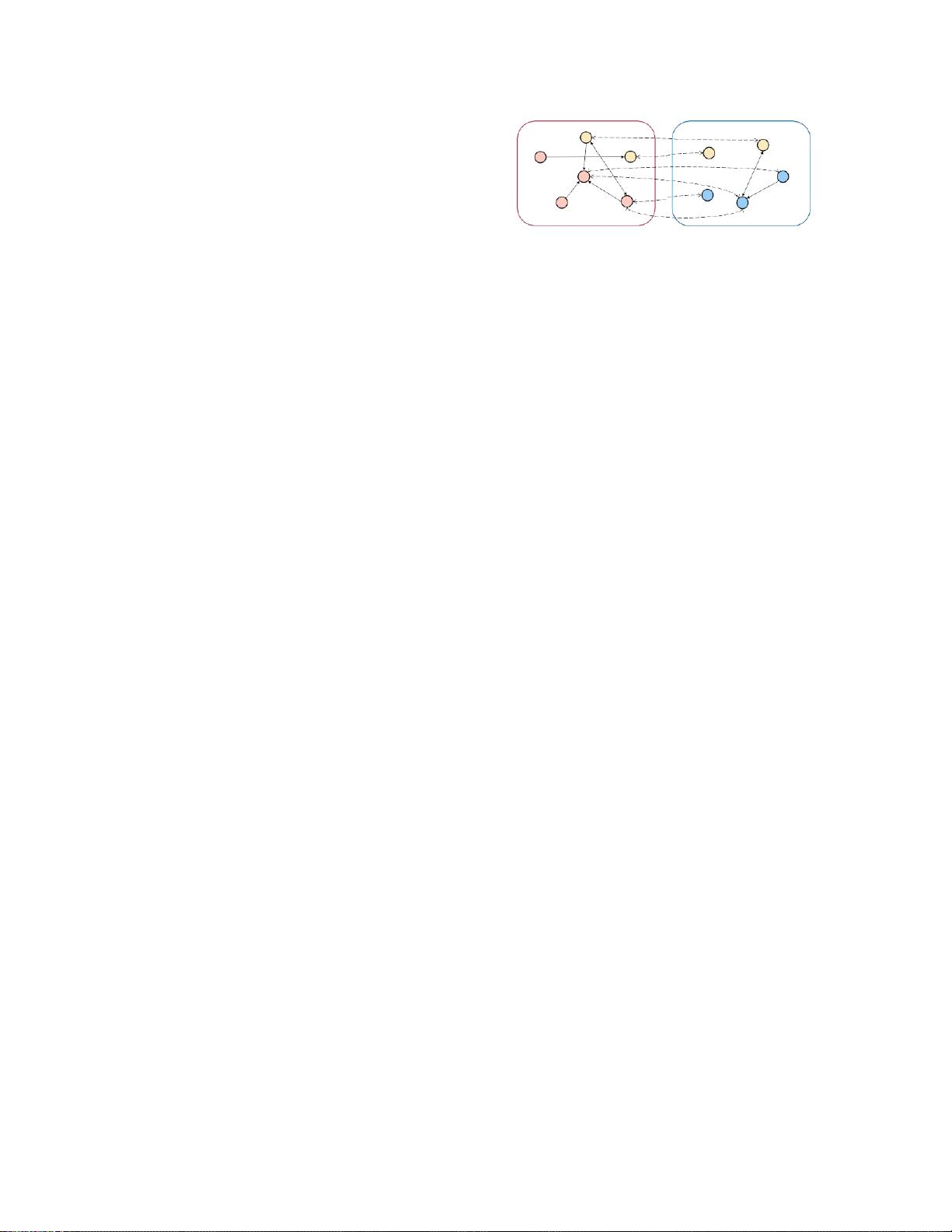

知识引导的图形推理。图推理在许多任务中被证明

是有效的,包括图像分类[5,4],对象检测[40,39],

基于人体骨架的动作识别[21]或运动预测[22]等。这些

方法将领域知识建模为图,以基于类别依赖性,对象

空间关系或对象语义关系传递知识。一些分类模型

[5,4]基于数据集统计信息构建类别依赖图。[40]使用

知识图来发现用于特征进化的最相关类别。我们的方

法不仅使用语义图的完全监督和弱监督数据集的原因

类别的依赖性,但也转移两个数据集之间的类别相似

性或依赖性知识。

3.

类别转移框架

问题表述。在数学上,给定弱监督数据集

w

,数据

集 中 的 每 个 图 像 x

w

具 有 图 像 级 类 别 标 签 y

w

, 其 中

y

w

R

C

w

,其中C

w

是弱监督数据集类别的数量。

并且

y

(

i

)

R

C

f

是图像中的第

i

个的类别标签

C

f

是完全监督的数据集类别的数量。我们的目标是

在

w

上训练一个模型,并从

f

转移知识。 对于每个测

试图像

x

,模型可以

输出实例级检测,包括估计的

边

界框和类别估计

;

即

B

,

Y

=

M

(

x

)。

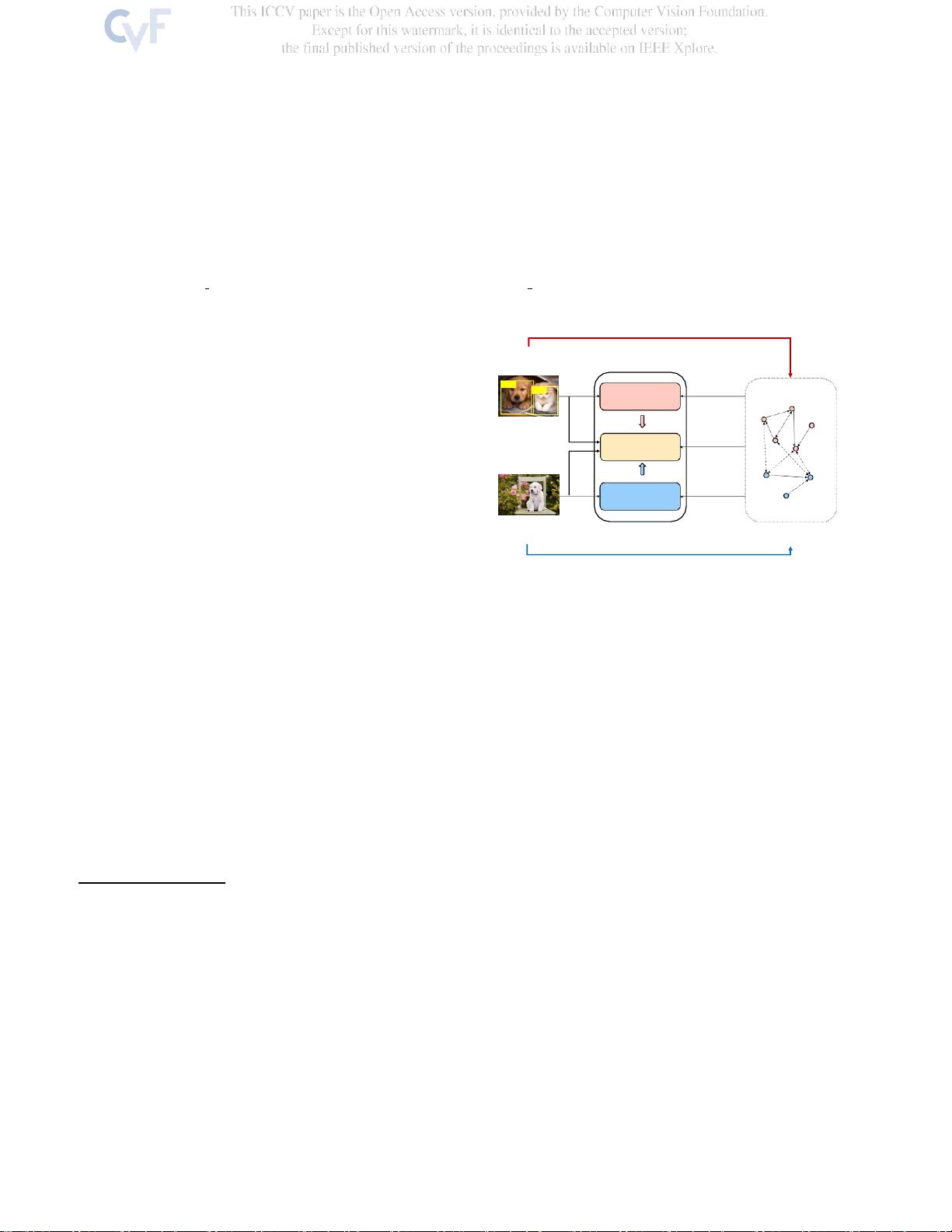

概况. 为了设计这样一个模型,我们特别考虑了类

别转移;也就是说,利用完全监督数据集中的对象识别

的类别信息来增强检测器的辨别能力,该检测器是在

弱监督数据集上训练的。类别转移使得区分能力能够

从全监督数据集转移到弱监督检测器,从而导致更好

的检测性能。

如图3所示,建议的类别跨- FER框架包括三个部

分:骨干网、双监督教师网络(第3.1节)和语义图卷

积网络(第3.2节)。对于输入图像,我们的主干网络

遵循Faster R-CNN [27]的主干,提取视觉特征并生成

提案区域。双监督均值教师网络采用每个区域中的池

化视觉特征,并且通过利用来自全监督和弱监督数据

集两者的边界框和重叠类别信息来估计边界框和类为

了进一步实现非重叠类别转移,语义图卷积网络利用

类别之间的语义相关性并输出每个类别的语义特征。

为了对每个区域进行分类,我们将语义图卷积网络产

生的语义特征和来自双监督均值教师网络的R-CNN输

出的视觉特征进行聚合,以生成最终的类别特征,从

而提高识别能力。

3.1.

双重监督意味着教师网络

建议的双监督平均教师网络遵循传统的平均教师,

但有两个不同的学生分支。这种新颖的架构可以弥合

的领域差距,估计边界框和类通过重叠的类别转移。

网络架构。 该网络由完全监督的学生分支、弱监督

的学生分支和教师分支组成。三个分支中的每一个都

将由骨干网络产生的建议区域的池化视觉特征作为输

入,并通过几个卷积层更新视觉特征;也就是说,给定

池化视觉特征F

p

,则更新后的视觉特征F p将被更新。