深度跟踪数据集推动RGBD目标跟踪新进展:DeT方法与性能提升

67 浏览量

更新于2025-01-16

收藏 2.3MB PDF 举报

深度跟踪:RGBD目标跟踪的新方法及数据集

随着机器人技术、自动驾驶、智能家居等领域的发展,RGBD(红绿蓝深度)目标跟踪技术变得越来越重要,因为它结合了视觉和深度信息,提高了在复杂环境中物体识别和定位的能力。然而,现有的RGBD跟踪器通常依赖于先进的RGB跟踪器,利用RGB数据进行训练,而深度通道则主要用于处理遮挡和细节问题,因为缺乏大规模的RGBD训练数据。

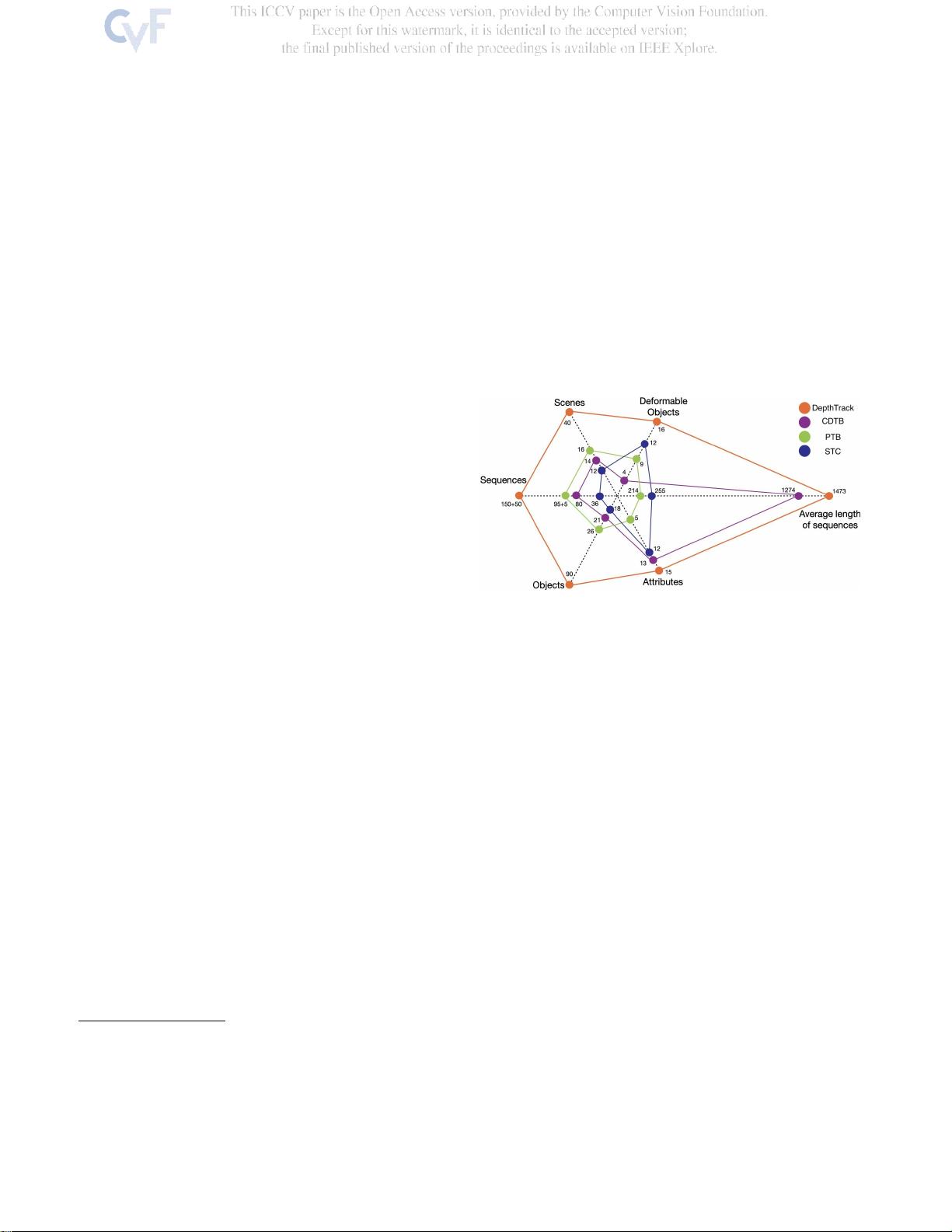

以往的工作存在数据集规模有限的问题,这限制了深度跟踪器的性能提升和深度线索的有效利用。为了解决这一问题,本研究提出了一项突破——深度跟踪(DepthTrack)数据集。这个新数据集相较于现有最大规模的数据集,拥有显著的增强,包括:

1. 增加的序列数量:DepthTrack包含200个序列,几乎是现有最大数据集的两倍,为深度学习模型提供了丰富的样本。

2. 扩展的场景类型:涵盖40种不同的场景,使得跟踪器能够适应多样化的环境条件。

3. 更多的对象种类:包含90个不同对象,增加了模型的泛化能力。

4. 长序列的平均长度:每个序列平均长度达到1473帧,模拟了更长时序的跟踪挑战。

5. 变形对象的考虑:数据集中有16个可变形对象,测试跟踪器在形状变化情况下的性能。

6. 注释跟踪属性:提供15个关键的跟踪属性标签,有助于评估跟踪质量的多个维度。

为了验证DepthTrack的价值,研究者在该数据集上运行了SotARGB和RGBD跟踪器,并开发了一种新的RGBD跟踪基线——DeT(Depth-based Tracking),它展示了深度信息在大规模训练数据支持下对跟踪性能的提升。DeT的结果表明,深度RGBD跟踪确实可以从一般的训练数据中受益。

这项工作的主要贡献在于创建了一个更具挑战性和代表性的RGBD跟踪数据集,以及提供了一种基准方法,推动了RGBD跟踪技术的进一步发展。研究人员希望,DepthTrack将促进深度感知跟踪算法的研究和创新,并最终提升各种应用中对目标对象的精准定位能力。

代码和数据集可以在<https://github.com/xiaozai/DeT>获取,供学术界和工业界使用,共同推动RGBD目标跟踪技术的进步。

204 浏览量

点击了解资源详情

3189 浏览量

2021-04-05 上传

2022-08-03 上传

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- A7Demo.appstudio:探索JavaScript应用开发

- 百度地图范围内的标注点技术实现

- Foobar2000绿色汉化版:全面提升音频播放体验

- Rhythm Core .NET库:字符串与集合扩展方法详解

- 深入了解Tomcat源码及其依赖包结构

- 物流节约里程法的文档整理与实践分享

- NUnit3.vsix:快速安装NUnit三件套到VS2017及以上版本

- JQuery核心函数使用速查手册详解

- 多种风格的Select下拉框美化插件及其js代码下载

- Mac用户必备:SmartSVN版本控制工具介绍

- ELTE IK Web编程与Web开发课程内容详解

- QuartusII环境下的Verilog锁相环实现

- 横版过关游戏完整VC源码及资源包

- MVC后台管理框架2021版:源码与代码生成器详解

- 宗成庆主讲的自然语言理解课程PPT解析

- Memcached与Tomcat会话共享与Kryo序列化配置指南