高分辨率立体匹配:实时性能与深度感知研究

150 浏览量

更新于2025-01-16

收藏 1.94MB PDF 举报

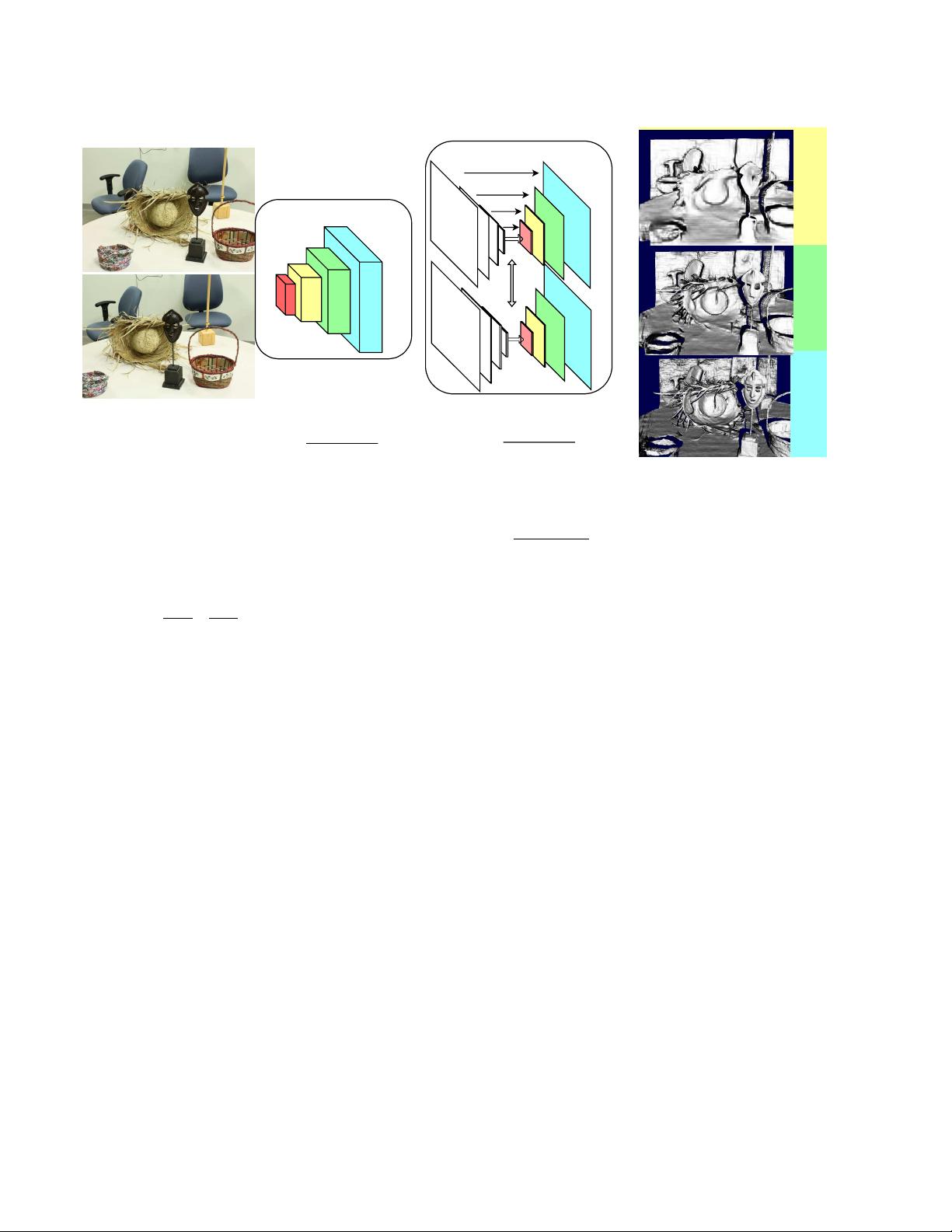

"本文主要研究了在高分辨率图像中实现实时立体匹配的技术及其在自动驾驶等时间敏感应用中的重要性。作者提出了一种新的端到端框架,通过粗到细的层次结构来处理高分辨率图像,有效解决了内存和速度限制的问题。他们还创建了一个包含高分辨率立体对的数据集,用于训练和评估新方法。该方法在Middlebury-v3和KITTI-15数据集上表现出最先进的性能,并且运行速度快于现有竞争方案。此外,它的分层设计使得能够以低延迟快速预测近距离物体的深度,这对于自动驾驶等需要即时响应的应用至关重要。

立体匹配是确定图像对中对应像素间深度差异的过程,是获取场景三维信息的关键技术。传统观点认为,立体匹配在远距离感测中准确性较低,因为误差随着距离的平方增长。然而,高分辨率的立体匹配有可能克服这一限制,提供更精确的深度信息。

文章指出,尽管LiDAR(光探测和测距)是常见的深度感测解决方案,但其空间密度有限,尤其在长距离感测中。而高分辨率、全局快门的立体匹配系统可以解决这些问题,提供更高的密度和更好的动态场景适应性。作者通过实验验证了这种高性能与速度之间的权衡策略,适用于对时间要求严格的应用,如自动驾驶,能够在不牺牲精度的情况下实现快速深度感知。

此外,文章还强调了数据集在研究中的重要性,指出由于高分辨率立体数据集相对稀缺,所以创建新的数据集对于推动相关研究和技术发展至关重要。作者在ArgoAI的实习期间完成了这项工作,并计划公开数据和代码,以促进后续研究和应用。"

2022-02-14 上传

248 浏览量

248 浏览量

125 浏览量

266 浏览量

382 浏览量

739 浏览量

cpongm

- 粉丝: 6

最新资源

- 计算机组成原理期末试题及答案(2011参考)

- 均值漂移算法深入解析及实践应用

- 掌握npm与yarn在React和pg库中的使用

- C++开发学生信息管理系统实现多功能查询

- 深入解析SIMATIC NET OPC服务器与PLC的S7连接技术

- 离心式水泵原理与Matlab仿真教程

- 实现JS星级评论打分与滑动提示效果

- VB.NET图书馆管理系统源码及程序发布

- C#实现程序A监控与自动启动机制

- 构建简易Android拨号功能的应用开发教程

- HTML技术在在线杂志中的应用

- 网页开发中的实用树形菜单插件应用

- 高压水清洗技术在储罐维修中的关键应用

- 流量计校正方法及操作指南

- WinCE系统下SD卡磁盘性能测试工具及代码解析

- ASP.NET学生管理系统的源码与数据库教程