人类手在交互式物体理解中的关键作用与数据驱动挑战

PDF格式 | 43.62MB |

更新于2025-01-16

| 162 浏览量 | 举报

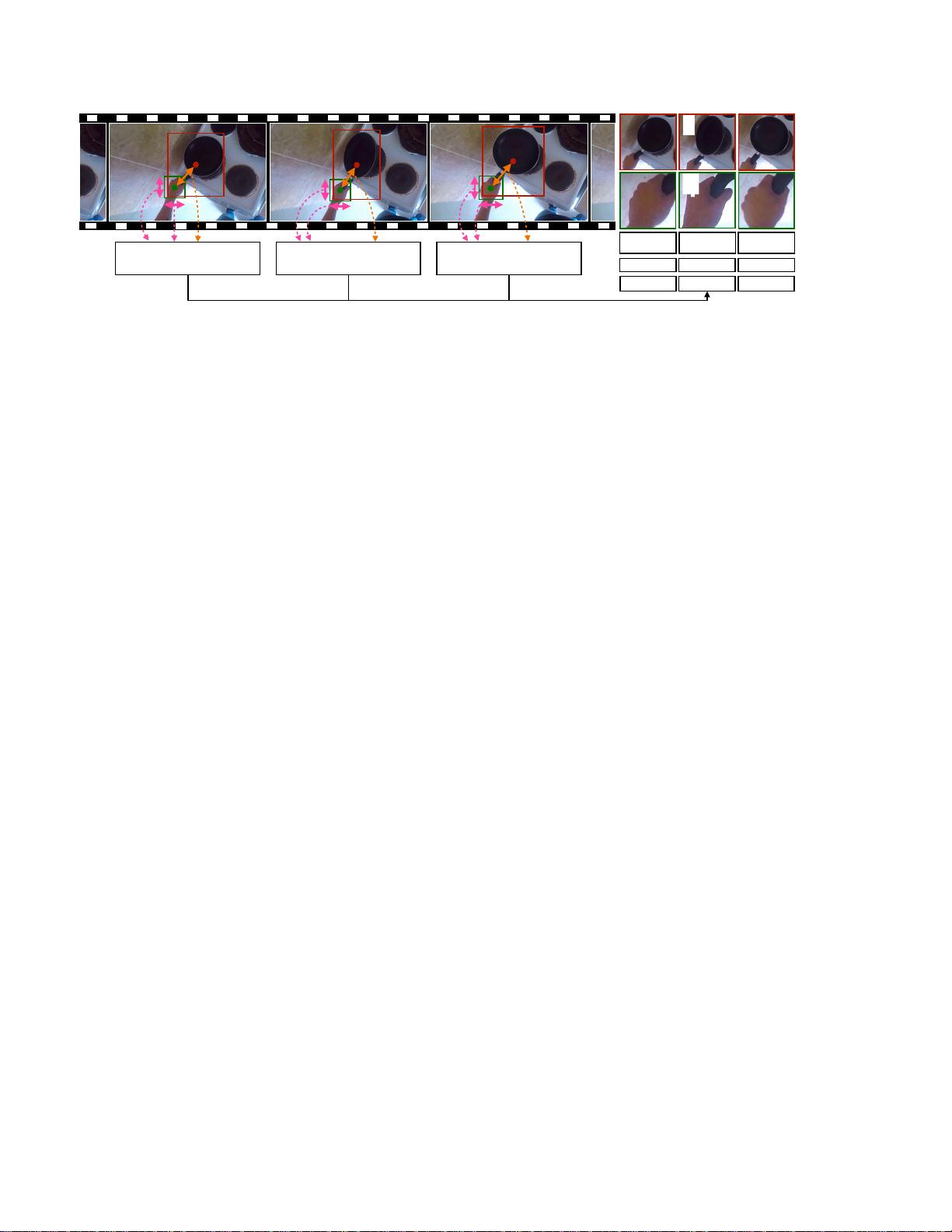

交互式物体理解是计算机视觉领域的重要课题,涉及理解物体的功能和操作方式。本文聚焦于人类手部在这一过程中的关键作用。作者提出通过观察自中心视频中的人类手部动作,可以为机器学习提供宝贵的信息,帮助理解物体的状态敏感特征和交互可能性。

首先,人类手部作为一个“探针”,能够快速定位并稳定活动中的物体,这对于机器学习来说是非常重要的线索。通过跟踪手部与物体的互动,研究者可以推断出物体可能的交互位置和操作方式,这些都是实现有效交互所必需的。例如,通过观察手部距离的变化,可以形成一个状态敏感的特征空间,使得机器能够识别物体的不同用途,而不仅仅是其基本类别。

其次,手部可以揭示物体的抓取区域和适宜的操作位置,这对于机器的探索行为和策略制定具有指导意义。比如,对于柜子这样的物体,它的状态(如关闭、打开、满载等)和提供给用户的抓取点(如把手)对于机器人执行打开或放置物品的任务至关重要。然而,现有的大规模标记数据集在这方面相对匮乏,因为物体的状态和操作方式通常依赖于复杂的上下文,且手动标注这类信息既耗时又难以避免主观偏差。

因此,本文提出了一种新颖的方法,利用人类手部在自我中心视频中的动态信息,解决大规模标记数据集的缺失问题。通过这种方法,研究者能够在EPIC-KITCHENS数据集上训练模型,学习到状态敏感的特征和物体的抓取区域,从而更深入地理解物体的交互性。这一研究不仅推进了计算机视觉在交互式场景下的应用,也为未来的机器人交互设计和自主学习提供了新的视角和数据驱动的支持。

相关推荐

11 浏览量

9 浏览量

5 浏览量

cpongm

- 粉丝: 6

最新资源

- 小学水墨风学校网站模板设计

- 深入理解线程池的实现原理与应用

- MSP430编程代码集锦:实用例程源码分享

- 绿色大图幻灯商务响应式企业网站开发源码包

- 深入理解CSS与Web标准的专业解决方案

- Qt/C++集成Google拼音输入法演示Demo

- Apache Hive 0.13.1 版本安装包详解

- 百度地图范围标注技术及应用

- 打造个性化的Windows 8锁屏体验

- Atlantis移动应用开发深度解析

- ASP.NET实验教程:源代码详细解析与实践

- 2012年工业观察杂志完整版

- 全国综合缴费营业厅系统11.5:一站式缴费与运营管理解决方案

- JAVA原生实现HTTP请求的简易指南

- 便携PDF浏览器:随时随地快速查看文档

- VTF格式图片编辑工具:深入起源引擎贴图修改