一致性注意Siamese网络:深度学习人重识别的关键突破

PDF格式 | 963KB |

更新于2025-01-16

| 34 浏览量 | 举报

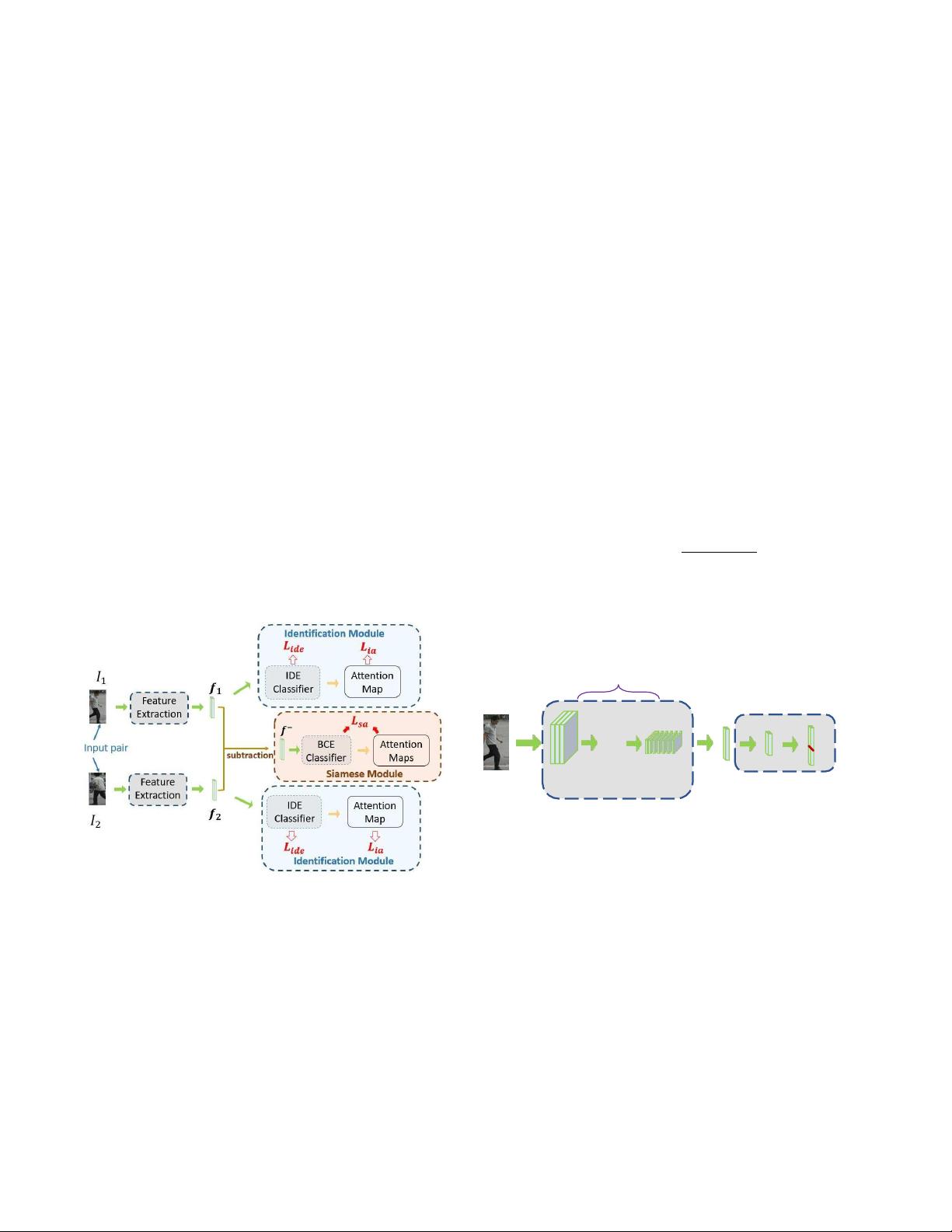

"本文介绍了一种新的深度学习架构——一致性注意Siamese网络,用于解决人重新识别(re-id)中的关键挑战。该方法着重于跨视角匹配中的空间定位和视图不变表示学习,旨在提高re-id在真实世界应用中的可靠性。文章的主要贡献包括:(a)一个仅依赖身份标签的注意力生成框架,(b)强调同一人图像间注意力一致性的明确机制,(c)引入一个新的暹罗框架,结合注意力和一致性,创建有原则的监督信号,同时提供对暹罗网络预测的解释能力。这种方法在多个数据集上进行了广泛的评估,表现出竞争力。

1. 人重新识别问题

人重新识别是一项技术,目标是根据在不同摄像头视角下的图像找到同一人。随着监控和其他视频分析应用的需求增长,re-id的研究日益受到关注。尽管已取得显著进步,但由于视角变化、光照差异和遮挡等因素,re-id在实际应用中仍面临挑战。

2. 一致性注意Siamese网络的创新点

- 灵活框架:该方法使用身份标签指导注意力的生成,无需额外标注,提高了模型学习的效率和效果。

- 注意力一致性:通过设计机制确保同一人的不同图像具有相似的注意力分布,增强跨视角匹配的稳定性。

- Siamese框架扩展:将注意力和一致性相结合,不仅提升了匹配性能,还允许理解模型的决策过程,增强了模型的可解释性。

3. 应用与评估

该方法在CUHK03-NP、DukeMTMC-ReID和Market-1501等标准数据集上进行了实验,展示了与现有方法相媲美的性能。这表明一致性注意Siamese网络在解决re-id任务中的空间定位和局部表示学习问题上具有潜力。

4. 结论

一致性注意Siamese网络为re-id提供了一个综合解决方案,它结合了空间定位、特征表示和跨视角匹配,有望推动re-id技术在复杂环境中的实际应用。通过端到端训练,模型能够在处理视图变化和遮挡等问题时,实现更准确的人员匹配。"

相关推荐

79 浏览量

cpongm

- 粉丝: 6

最新资源

- WebDrive v16.00.4368: 简易易用的Windows风格FTP工具

- FirexKit:Python的FireX库组件

- Labview登录界面设计与主界面跳转实现指南

- ASP.NET JS引用管理器:解决重复问题

- HTML5 canvas绘图技术源代码下载

- 昆仑通态嵌入版ASD操舵仪软件应用解析

- JavaScript实现最小公倍数和最大公约数算法

- C++中实现XML操作类的方法与应用

- 设计编程工具集:材料重量快速计算指南

- Fancybox:Jquery图片轮播幻灯弹窗插件推荐

- Splunk Fitbit:全方位分析您的活动与睡眠数据

- Emoji表情编码资源及数据库查询实现

- JavaScript实现图片编辑:截取、旋转、缩放功能详解

- QNMS系统架构与应用实践

- 微软高薪面试题解析:通向世界500强的挑战

- 绿色全屏大气园林设计企业整站源码与多技术项目资源