交错。该体系结构捕获节点之间的本地和全局关系第

三 , 我 们 提 出了 一 个端 到 端的 学 习框 架 ,以 表 明

SemGCN还可以结合外部信息,如图像内容,以进一

步提高3D人体姿势回归的性能。

我们的方法的有效性通过采用严格的消融研究进行

综合评价并与标准3D基准上的最新技术水平进行比较

来验证。我们的方法与Human3.6M [24]上最先进技术

的性能相匹配,仅使用2D关节坐标作为输入,参数减

少了90%。同时,我们的方法在结合图像特征时优于

现有技术。此外,我们还展示了SemGCN的可视化结

果,定性地证明了我们的方法的有效性。请注意,所

提出的框架可以很容易地推广到其他回归任务,我们

将其留给未来的工作。

2.

相关工作

图卷积网络。将

CNN

推广到具有图形结构的输入

是深度学习领域的一个重要课题在文献中,已经有

几次尝试使用递归神经网络来处理在图域中表示为

有 向 非 循 环 图 的 数 据 在

[17

,

28

,

49]

中 引 入 了

GNN

,作为处理任意图形数据的更常见的解决方案

在图上构造

GCN

的原理通常遵循两个流:光谱透视

和空间透视。我们的工作属于第二个流

[28

,

39

,

60]

,其中卷积滤波器直接应用于图节点及其邻居。

最近对计算机视觉的研究已经通过利用GCN对视觉

对象[68,70]或时间序列[66,67]之间的关系进行建模

来实现最先进的性能。本文遵循他们的精神,同时我

们探索将GCN应用于回归任务,特别是2D到3D人体姿

势回归。

3D姿态估计。Lee和Chen [30]首先研究了从其相应

的2D投影推断3D关节。后来的方法要么是利用最近的

邻居,

bors来改进姿势推断的结果[18,25]或前手工制作的特

征[1,23,47]以用于以后的回归。其他方法创建了适

合于将人类姿势表示为稀疏组合的过完备基础[2,4,

44,62,77]。越来越多的研究关注

介绍了一种简单有效的方法,该方法完全基于2D检测

来预测3D关键点。Fang等人[13]通过姿势语法网络进

一步扩展了该方法。这些工作集中在2D到3D姿态回

归,这是最相关的本文的上下文。

其他方法使用合成数据集,这些数据集是通过使用

地面实况[8,42,48]对人类模板模型进行变形而生成

的,或者除了关节之外,还引入了涉及高级知识[40,

53,69]的损失函数。它们是对其他人的补充。剩余工

作的目标是利用时间信息[11,18,21,57]进行3D姿

态回归。它们超出了本文的范围,因为我们的目标是

从一个单一的图像处理2D姿态。然而,我们的方法可

以很容易地扩展到序列输入,我们把它留给未来的工

作。

3.

语义图卷积网络

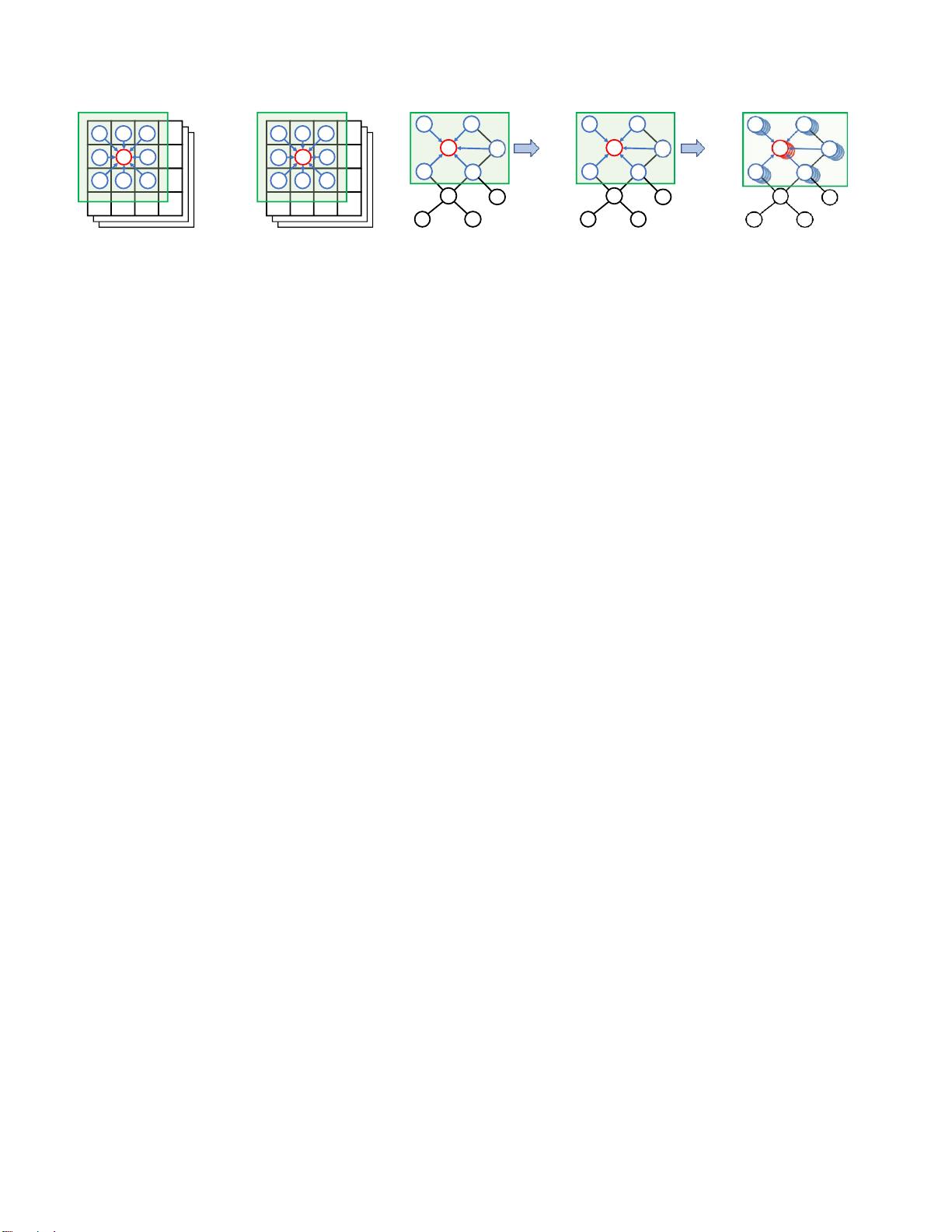

我们提出了一种新的图网络架构,以处理一般的回

归任务,涉及的数据,可以表示在图的形式。本文首

先介绍了GCN的背景和相关的基线方法.然后介绍了

SemGCN的详细设计。

我们假设图形数据共享相同的拓扑结构,例如人体

骨架[10,26,61,67],3D

morphable models [33 , 45 , 72] and citation networks

[50].其他在同一域中具有不同图结构的问题,

例如

,

蛋白质-蛋白质相互作用[60]和量子化学[15]不在本文

的范围内。这个假设使得学习图结构中隐含的先验成

为可能,这激发了SemGCN。

3.1.

ResGCN:基线

我们将首先简要回顾

[28]

中提出的

“香草”GCN

。设

G

=

{

V

,

E

}

表示一个图,其中

V

是

K

个节点的集合,

E

是边,而

→

−

x

(

l

)

∈

R

D

l

和

→

−

x

(

l

+1

)

∈

R

D

l

+

1

是节点

i

的表示,

分别在第l次卷积之前和之后的曲线图

基于卷积的传播可以在两个步骤中应用于节点

i

首

先 , 将 节 点 表示变 换 为 一 个 可 学 习 的 参 数 矩阵

W

∈

RDl

+1

×

Dl

.

其次

,这些转换后的节点表示被收集起

来,

节点

i

从其相邻节点

j

∈ N

(

i

),后跟一个非线性函

数(

ReLU [37]

)。如果节点表示被收集到矩阵

X

(

l

)

∈

R

D

l

×K

中,则卷积运算可以写为: