并行最优传输GAN算法:提升GAN训练效果与模式多样性

PDF格式 | 1.05MB |

更新于2025-01-16

| 141 浏览量 | 举报

"并行最优传输GAN算法是针对生成对抗网络(GAN)训练质量和模式覆盖问题的一种新方法,由吉尔·亚伯拉罕、严佐汤和姆·德拉蒙德提出。该算法在低维表示空间内并行执行最优传输,以改善GAN训练的稳定性和生成样本的质量,增加数据分布的模式覆盖。研究表明,这种方法在CIFAR-10、OxfordFlowers和CUBBirds数据集上实现了显著的定性和定量提升。"

生成对抗网络(GANs)是一种强大的生成模型,由两个相互竞争的网络组成:生成器(Generator)和鉴别器(Discriminator)。生成器尝试从随机噪声中生成逼真的样本,而鉴别器试图区分真实数据与生成的样本。然而,GANs在训练过程中存在一些固有问题,如低模态多样性和样本失真,这些问题主要源于距离度量的不准确估计。

最优传输(Optimal Transport)理论在统计学和机器学习中有广泛应用,其在解决大规模问题时表现出良好的直观性和数值稳定性。在GANs中,最优传输被用来估计Wasserstein距离,有助于缓解训练不稳定性,如消失梯度和模式崩溃。

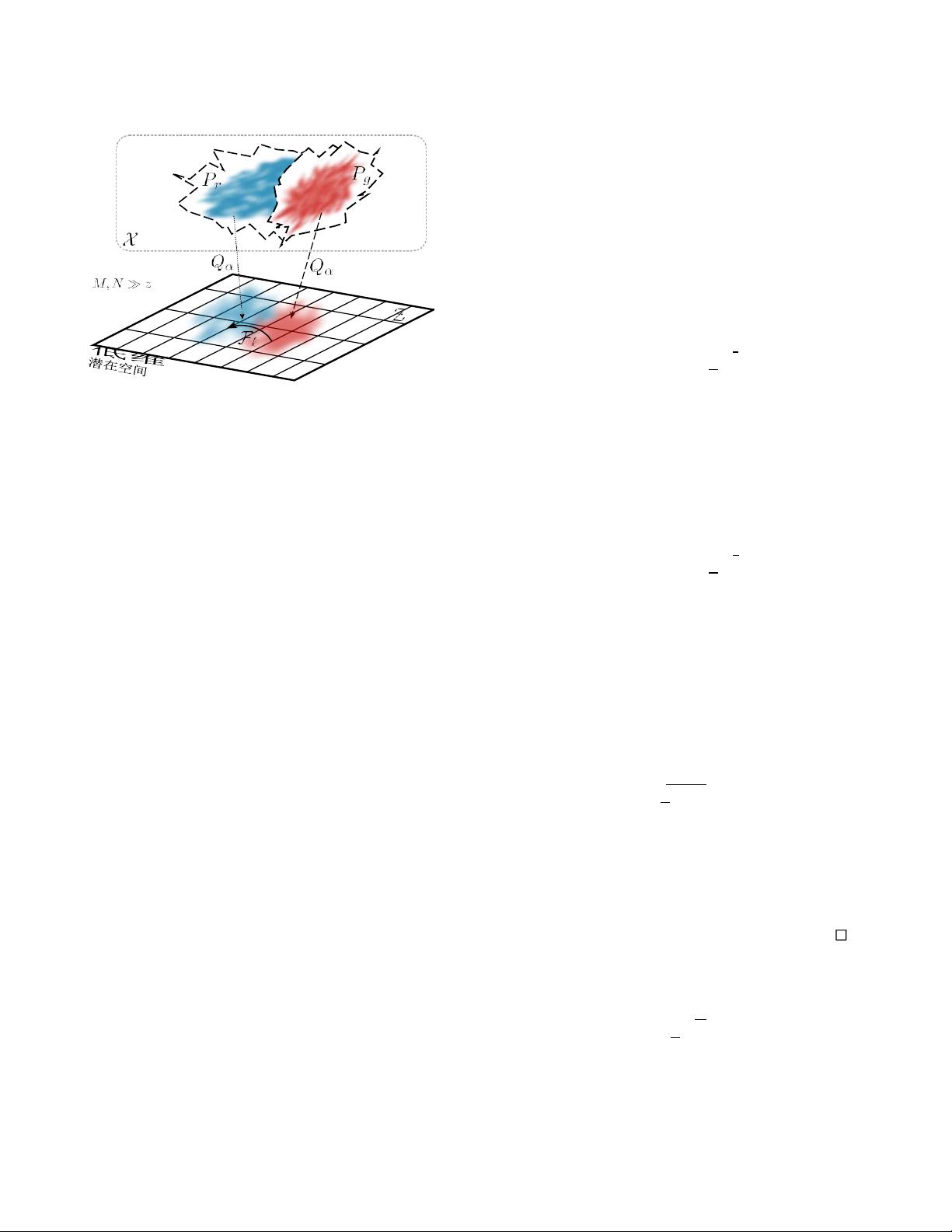

论文中提出的并行最优传输GAN算法引入了一个新的正则化项,这个项在数据分布的低维表示空间中并行执行,以加速Wasserstein距离的估计收敛速度。通过这种方式,算法能够提供更稳定的训练过程,生成更高质量的样本,并增加对原始数据分布的模式覆盖。

实验结果表明,这种方法在多个数据集上的表现优于传统GAN训练,包括在CIFAR-10(一个常用的彩色图像数据集)、OxfordFlowers(花卉识别数据集)和CUBBirds(鸟类识别数据集)上,不仅提高了生成样本的视觉质量,还量化地提升了模式多样性。

这一并行最优传输GAN算法为解决GAN训练中的挑战提供了新的视角,通过优化距离度量的估计,提高了生成模型的性能,有望在图像生成和其他应用领域带来更优秀的成果。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 自动生成CAD模型文件的测试流程

- 掌握JavaScript中的while循环语句

- 宜科高分辨率编码器产品手册解析

- 探索3CDaemon:FTP与TFTP的高效传输解决方案

- 高效文件对比系统:快速定位文件差异

- JavaScript密码生成器的设计与实现

- 比特彗星1.45稳定版发布:低资源占用的BT下载工具

- OpenGL光源与材质实现教程

- Tablesorter 2.0:增强表格用户体验的分页与内容筛选插件

- 设计开发者的色值图谱指南

- UYA-Grupo_8研讨会:在DCU上的培训

- 新唐NUC100芯片下载程序源代码发布

- 厂家惠新版QQ空间访客提取器v1.5发布:轻松获取访客数据

- 《Windows核心编程(第五版)》配套源码解析

- RAIDReconstructor:阵列重组与数据恢复专家

- Amargos项目网站构建与开发指南