ENVEDIT:增强环境编辑提升视觉语言导航性能

12 浏览量

更新于2025-01-16

收藏 2.21MB PDF 举报

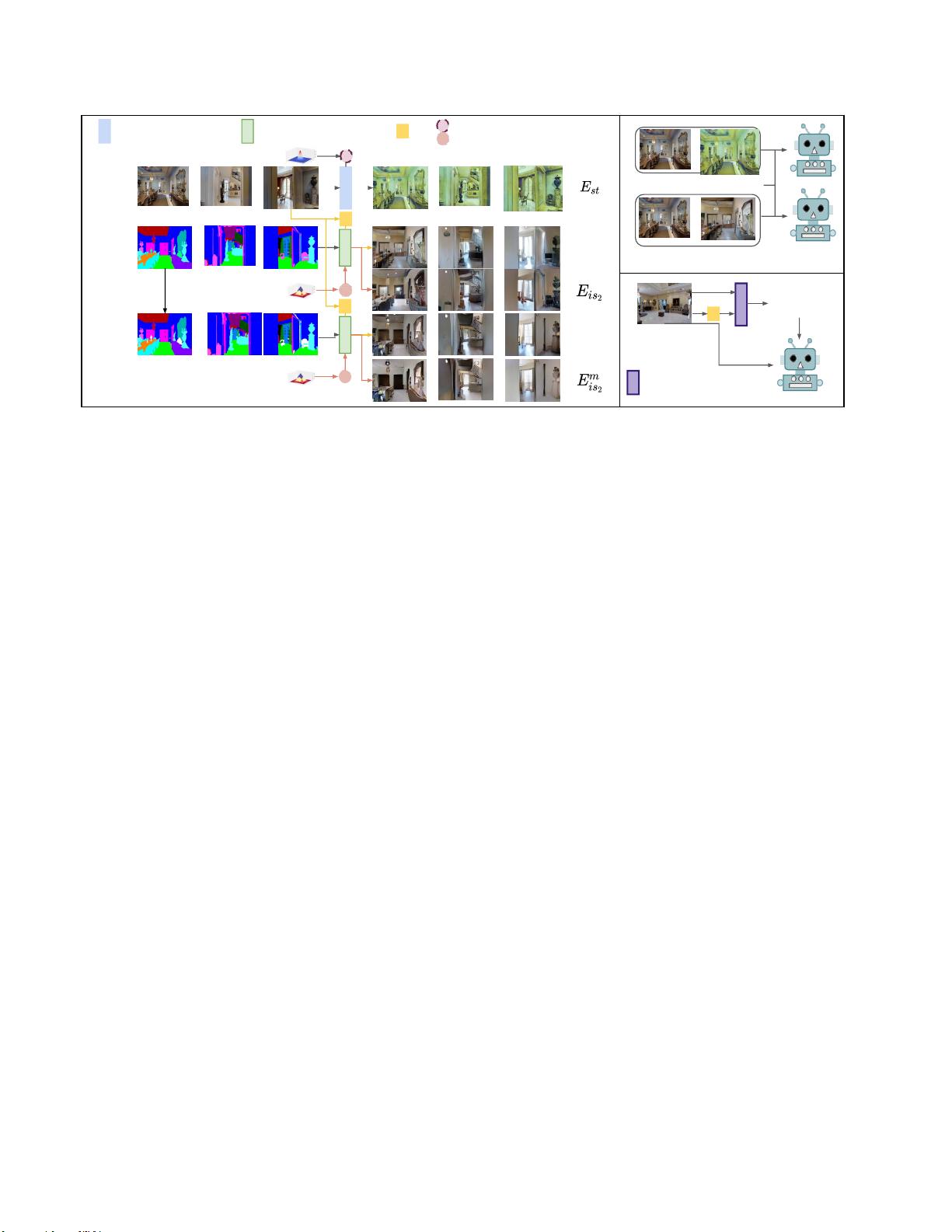

ENVEDIT是一种创新的数据增强方法,专为视觉和语言导航(VLN)任务设计,以解决智能体在面对有限训练数据和多样化的实际导航环境时的适应性问题。该方法的核心在于通过编辑现有环境的三个方面来创建新的训练环境:风格、对象外观和对象类。

1. **训练环境与测试环境**:

- 在传统的VLN设置中,训练数据往往受限于规模和多样性,这限制了智能体的泛化能力。ENVEDIT旨在通过模拟不同的环境变异性来扩大训练样本,使代理能够应对更广泛的场景。

2. **环境级增强**:

ENVEDIT实现了环境级别的增强,即它不只是简单的图像变换,而是涉及到环境的深层次结构变化,如房间风格、家具布局以及物体类别。这有助于提高智能体对不同环境特征的理解和适应。

3. **编辑样式与外观**:

方法通过编辑训练环境的样式,比如改变墙壁颜色、家具风格等,来模拟不同的室内装饰风格。同时,编辑对象外观则可能涉及更改物体的颜色、纹理或形状,以增加视觉多样性。

4. **编辑对象类**:

通过添加或替换不同类型的物体,如家具、装饰品等,ENVEDIT确保智能体能够处理不同环境中的常见物体,增强其识别和理解能力。

5. **编辑合成环境**:

创建的合成环境是在训练过程中作为数据增强的一部分使用的,这样可以让智能体在类似但有所区别的环境中学习,从而减少对特定训练场景的依赖。

6. **实验结果**:

通过在Room-to-Room和多语言Room-Across-Room数据集上的实验,ENVEDIT展示了显著的性能提升,无论是在预训练还是非预训练的代理上,且在测试排行榜上取得了新的领先位置。这证明了编辑环境策略的有效性和通用性。

7. **编辑方法的互补性**:

结果还表明,集成不同编辑方法的VLN代理能够进一步增强智能体的表现,说明这些编辑手段是互补的,可以相互补充训练效果。

ENVEDIT是一种有力的工具,通过环境编辑扩展了智能体的训练范围,增强了其对未知环境的适应能力,从而推动了视觉和语言导航任务的研究进展。

106 浏览量

点击了解资源详情

点击了解资源详情

621 浏览量

2021-03-31 上传

265 浏览量

292 浏览量

2021-05-31 上传

2021-05-01 上传

cpongm

- 粉丝: 6

最新资源

- Saber仿真下的简化Buck环路分析与TDsa扫频

- Spring框架下使用FreeMarker发邮件实例解析

- Cocos2d捕鱼达人路线编辑器开发指南

- 深入解析CSS Flex布局与特性的应用

- 小学生加减法题库自动生成软件介绍

- JS颜色选择器示例:跨浏览器兼容性

- ios-fingerprinter:自动化匹配iOS配置文件与.p12证书

- 掌握移动Web前端高效开发技术要点

- 解决VS中OpenGL程序缺失GL/glut.h文件问题

- 快速掌握POI技术,轻松编辑Excel文件

- 实用ASCII码转换工具:轻松实现数制转换与查询

- Oracle ODBC补丁解决数据源配置问题

- C#集成连接器的开发与应用

- 电子书制作教程:你的文档整理助手

- OpenStack计费监控:使用collectd插件收集统计信息

- 深入理解SQL Server 2008 Reporting Services