深度逐点PVN3D:6DoF姿态估计的创新关键点网络

PDF格式 | 1.25MB |

更新于2025-01-16

| 121 浏览量 | 举报

PVN3D:深度逐点3D关键点投票网络在6DoF位姿估计中的应用

【介绍】

本文探讨的是6DoF(六个自由度)对象姿态估计问题,这是计算机视觉领域中的核心任务,因为它对机器人抓取、自动驾驶、增强现实等众多实际应用至关重要。由于光照变化、噪声、遮挡和物体切割等复杂因素,精确的6DoF估计具有高度挑战性。传统的非深度学习方法往往依赖于人工设计的特征匹配,如SIFT或SURF,但这些方法在面对光照变化时表现受限。

近期,随着深度学习的兴起,特别是深度神经网络(DNN)的引入,研究者们开始探索如何利用这些技术进行端到端的6DoF估计。早期的工作,如[50,52],尝试直接通过DNN回归物体的旋转和平移,但这往往难以捕捉到物体的精确结构信息。

【方法创新】

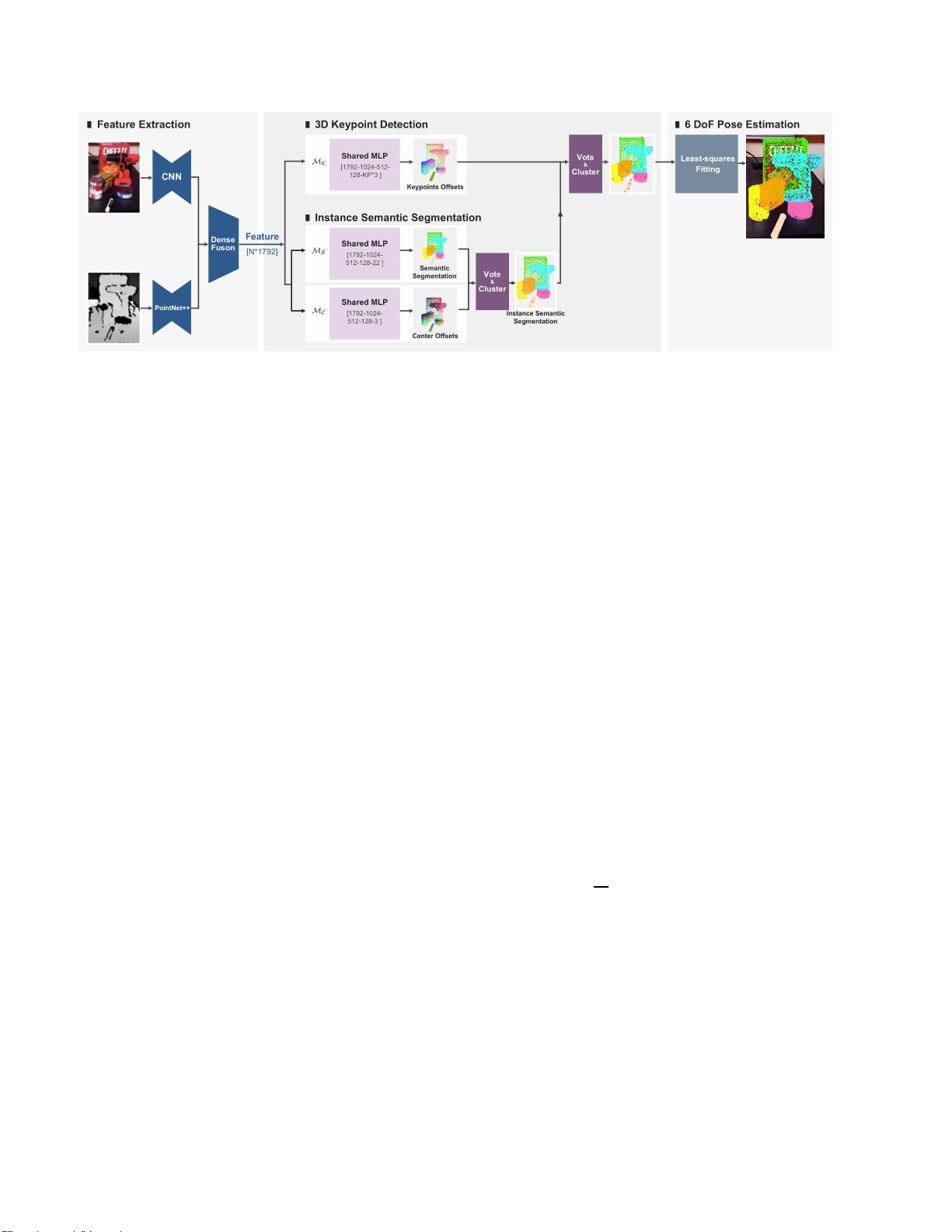

PVN3D(Point Voting Network for 3D Pose Estimation)提出了一种新颖的数据驱动策略,不同于直接回归,它采用了关键点检测的方法。首先,网络设计了一个深度Hough投票网络,专门针对RGBD(RGB图像和深度图像)数据,用于高效地检测物体的3D关键点。这种方法是对2D关键点方法的扩展,后者已经在基于RGB的6DoF估计中展现出优异性能。

通过深度Hough投票机制,网络能够从每个像素点对选定的关键点进行投票,随后聚集并选择关键点的聚类中心作为预测结果。这种方法有效地结合了刚体物体的几何约束和深度信息,使得网络学习和优化更加容易,同时增强了对复杂场景的鲁棒性。

【实验验证】

作者们进行了大量实验,旨在证明在6DoF姿态估计任务中,3D关键点检测的有效性和优势。实验结果显示,相比于现有的最先进的方法,PVN3D在多个基准测试中取得了显著的性能提升,特别是在光照变化、遮挡和物体截断等具有挑战性的条件下。

【结论与开源资源】

这项工作不仅提升了6DoF姿态估计的准确性和鲁棒性,而且展示了深度学习技术在解决这类问题中的潜力。PVN3D的成功案例表明,利用深度关键点检测和几何约束的结合,可以在保持高效的同时处理复杂的视觉任务。所有相关的代码和视频资料已发布在GitHub上,以便于研究者们进一步研究和参考(<https://github.com/ethnhe/PVN3D.git>)。

【未来展望与资助背景】

这项研究得到了国家重点研究发展计划(2018YFC0831700)的支持,预示着在未来的研究中,深度学习将继续推动6DoF姿态估计技术的发展,为更多实际应用场景提供更为精准和可靠的解决方案。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 易酷免费影视系统:开源网站代码与简易后台管理

- Coursera美国人口普查数据集及使用指南解析

- 德加拉6800卡监控:性能评测与使用指南

- 深度解析OFDM关键技术及其在通信中的应用

- 适用于Windows7 64位和CAD2008的truetable工具

- WM9714声卡与DW9000网卡数据手册解析

- Sqoop 1.99.3版本Hadoop 2.0.0环境配置指南

- 《Super Spicy Gun Game》游戏开发资料库:Unity 2019.4.18f1

- 精易会员浏览器:小尺寸多功能抓包工具

- MySQL安装与故障排除及代码编写全攻略

- C#与SQL2000实现的银行储蓄管理系统开发教程

- 解决Windows下Pthread.dll缺失问题的方法

- I386文件深度解析与oki5530驱动应用

- PCB涂覆OSP工艺应用技术资源下载

- 三菱PLC自动调试台程序实例解析

- 解决OpenCV 3.1编译难题:配置必要的库文件