反馈学习架构:早期预测与深度表示的优势

163 浏览量

更新于2025-01-16

收藏 1.11MB PDF 举报

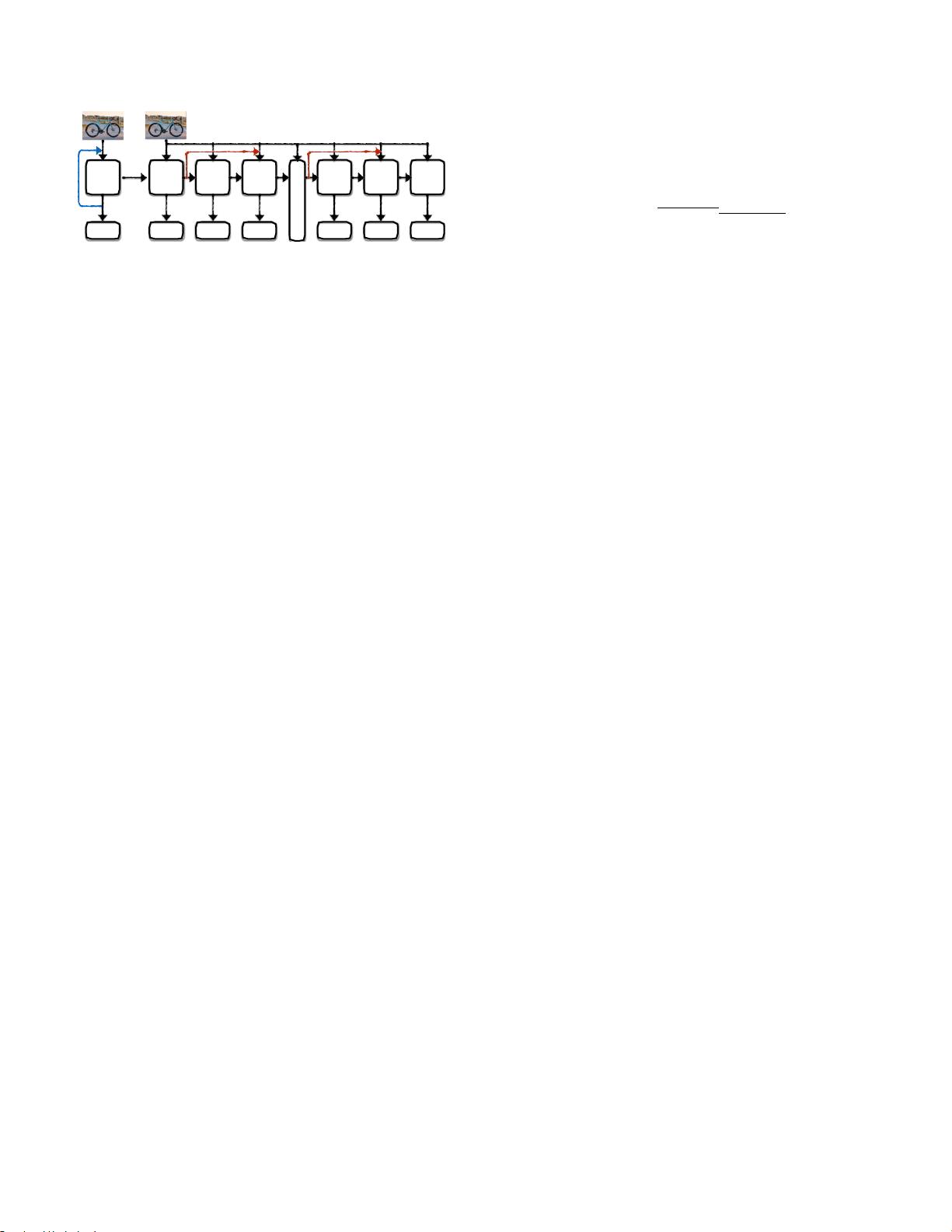

"基于反馈的学习架构及其优势"这一研究探讨了计算机视觉领域中的一种新型学习策略,与传统的前馈多层神经网络(如卷积神经网络,ConvNets)不同,它采用了基于反馈的方法。这种方法的核心在于,它不是一次性地生成连续表示,而是通过迭代的方式,根据从先前输出中获得的反馈来逐步构建表示。反馈网络的优势显著:

1. 早期预测能力:反馈网络允许系统在推理过程中提供更早的预测,因为预测是迭代进行的,而非一次性完成。这在需要实时响应的应用场景中极具价值,比如自动驾驶中的即时决策。

2. 自然符合层次结构:反馈网络的输出自然地适应于标签空间的层级结构,例如,物体识别中的类别关系(如自行车、车辆、轮式车辆等)。这种结构有利于理解和组织复杂的类别关系。

3. 课程学习的新视角:反馈网络的设计为课程学习提供了新的理论基础,因为它强调了迭代过程中的学习和调整,有助于在学习过程中逐步深入理解概念层次。

4. 不同的表示学习:相比于前馈网络,反馈网络能够生成更为精细且区分度高的表示,这可能在性能上有所提升。

5. 通用架构:研究人员提出了一个通用的基于反馈的学习架构,可以通过现有的循环神经网络(RNN)实例化。实验结果表明,这种反馈网络在性能上至少与现有前馈网络相当,甚至在某些情况下表现更优。

6. 生物学启示:研究还提及反馈机制在大脑中扮演的重要角色,这进一步强调了反馈网络在复杂认知任务中的潜力。

总结来说,基于反馈的学习架构因其独特的迭代性质和层次结构优势,为计算机视觉和其他领域的学习模型开辟了新的可能性,不仅提高了预测精度,还为深度学习的理论基础提供了新的洞察。随着技术的发展,这种方法有望在未来的AI研究中占据更重要的地位。

2021-07-14 上传

2009-04-29 上传

2021-09-19 上传

165 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- C#实现程序A的监控启动机制

- Delphi与C#交互加密解密技术实现与源码分析

- 高效财务发票管理软件

- VC6.0编程实现删除磁盘空白文件夹工具

- w5x00-master.zip压缩包解析:W5200/W5500系列Linux驱动程序

- 数字通信经典教材第五版及其答案分享

- Extjs多表头设计与实现技巧

- VBA压缩包子技术未来展望

- 精选多类型导航菜单,总有您钟爱的一款

- 局域网聊天新途径:Android平台UDP技术实现

- 深入浅出神经网络模式识别与实践教程

- Junit测试实例分享:纯Java与SSH框架案例

- jquery xslider插件实现图片的流畅自动及按钮控制滚动

- MVC架构下的图书馆管理系统开发指南

- 里昂理工学院RecruteSup项目:第5年实践与Java技术整合

- iOS 13.2真机调试包使用指南及安装