3277

0

形态学特征极大地提高了基本HMM的M-1准确率

,从63.1提升到了75.5。在深度学习时代,研究人

员对无监督POS标注的HMM进行了大量的关注。L

in等人(2015年)提出了高斯HMM(GHMM)

,其中p(xi∣yi)对应于xi的预训练词嵌入(在训练期

间固定)相对于yi的高斯分布的概率。Tran等人(

2016年)提出了神经HMM模型(NHMM),其

中p(xi∣yi)和p(yi−1∣yi)都通过具有POS标签和词嵌

入作为输入的神经网络计算得出。He等人(2018

年)通过引入可逆神经投影(INP)组件来扩展Lin

等人(2015年)的高斯HMM,用于预训练词嵌入

,这在训练期间具有调整词嵌入的类似效果。他们

的INP高斯HMM(INP-GHMM)方法迄今为止在

PTB上实现了最先进的(SOTA)M-1准确率(80.

8)。HMM的主要缺点是在发射概率p(xi∣yi)中存

在强独立性假设,这直接阻碍了来自强大的预训练

语言模型(PLMs)如ELMo/BERT(Peters等人,

2018;Devlin等人,2019)的上下文化词表示的

使用。这是一个遗憾,因为PLMs能够极大地提升

许多NLP任务的性能。在这项工作中,我们首次提

出了一种用于无监督POS标注的神经条件随机场自

编码器(CRF-AE)模型,受到Ammar等人(201

4年)提出的非神经CRF-AE模型的启发。在CRF-A

E的判别式编码器中,我们直接引入了ELMo词表示

。此外,受到特征丰富的HMM(Berg-Kirkpatric

k等人,2010年)的启发,我们将手工特征重新引

入CRF-AE的解码器。总之,这项工作做出了以下

贡献:●

我们首次提出了一种用于无监督POS标注的神经C

RF-AE模型。

0

●

我们在CRF-AE模型中成功地将PLMs和手工特征

0

●

我们的模型在45个标签的英文PTB数据上实现了83.21

的新SOTA

0

●

经过一些简单的调整,我们的模型在12个标签的多

语言通用依存树库v2.0(UD)上实现了新的SOTA

M-1准确率,平均超过了之前的最佳结果4.97。我

们在https://github.c上发布了我们的代码

0

x

0

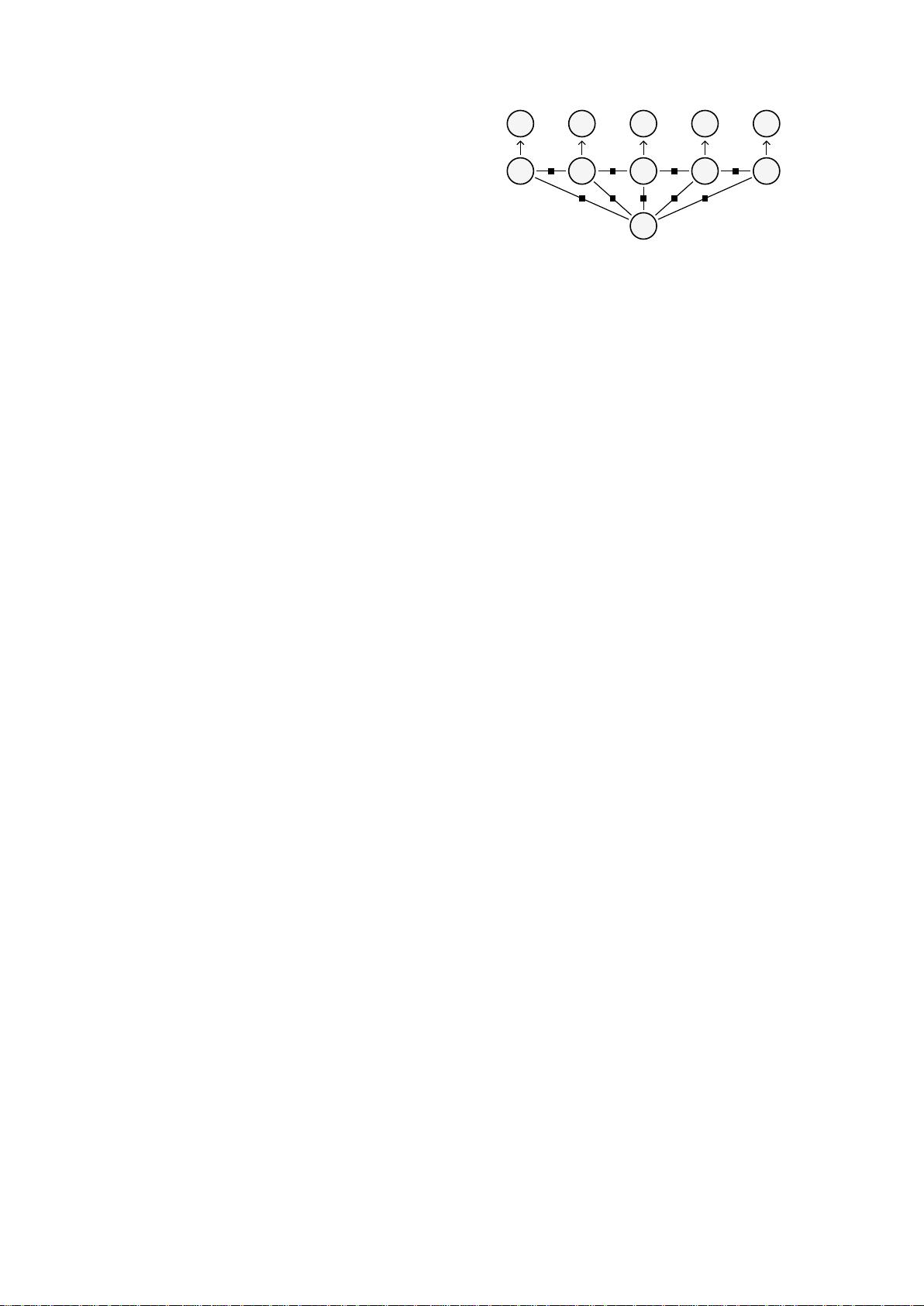

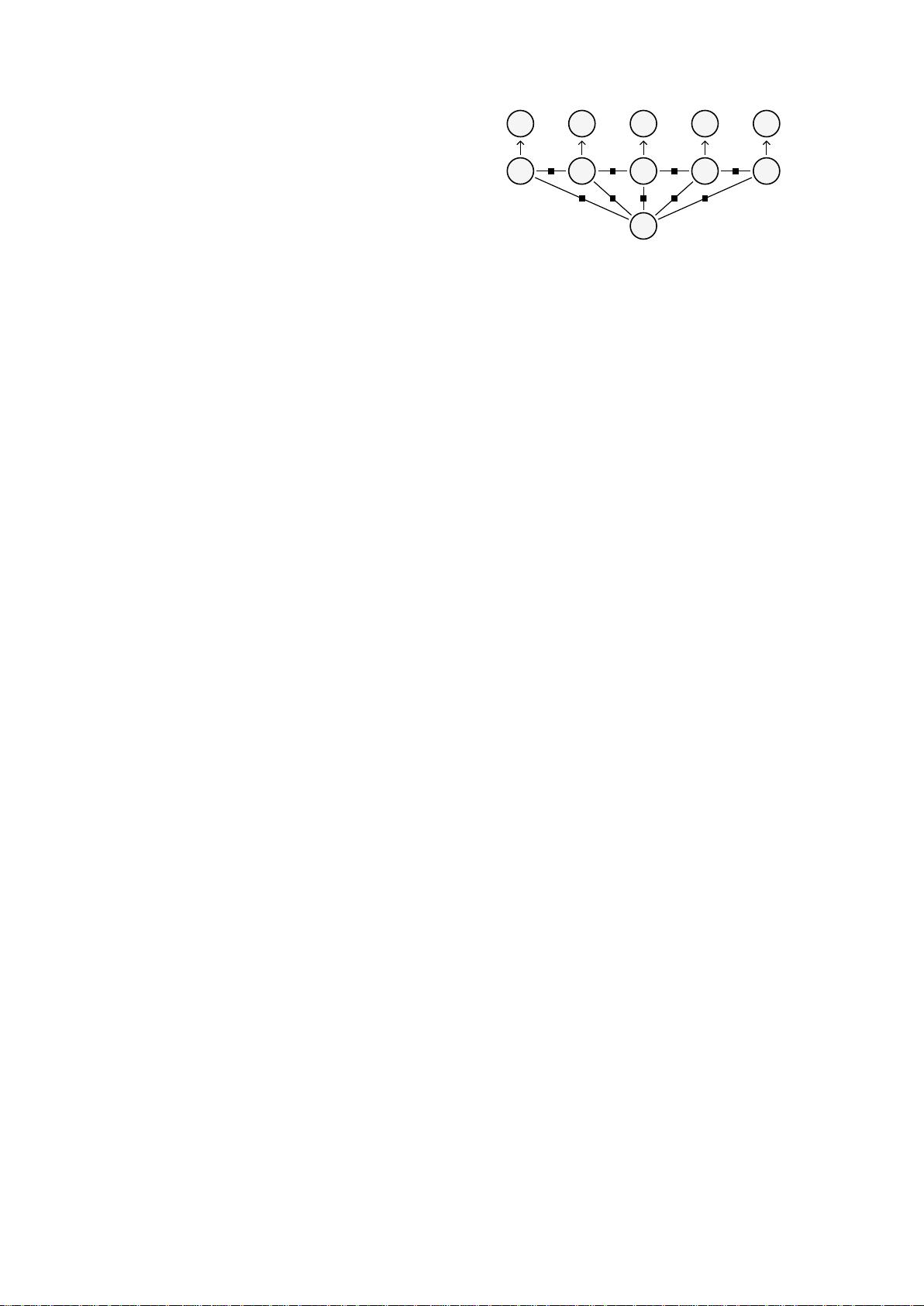

y1y2y3...yn

0

x1x2x3...xn

0

图2:CRF-AE的示意图

0

https://github.com/Jacob-Zhou/FeatureCRFA

E,包括我们重新实现的HMM和FHMM模型。

0

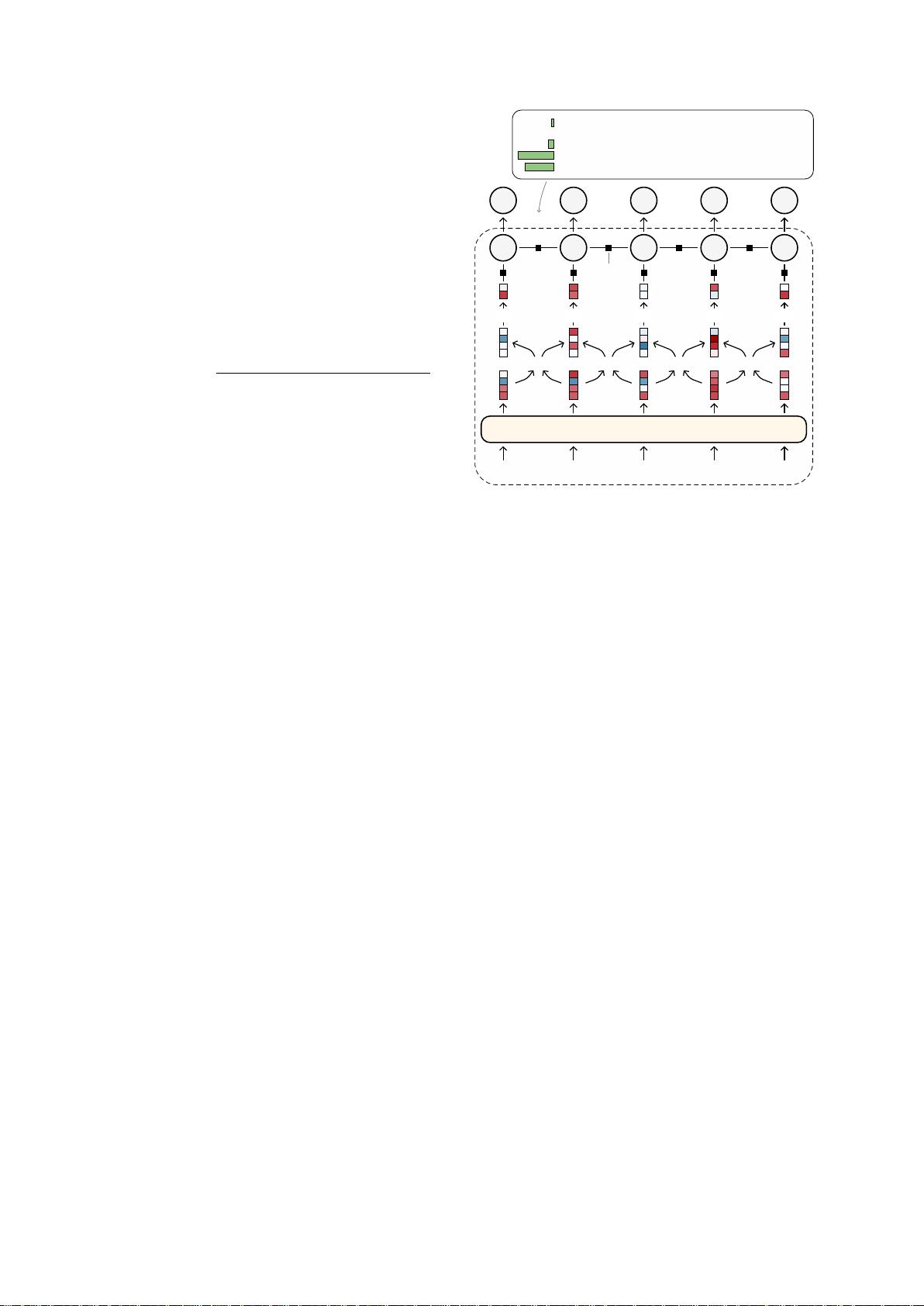

2VanillaCRF-AE

0

在这项工作中,我们采用CRF-AE方法作为我们无

监督POS标注的基本模型。非神经CRF-AE模型最

早由Ammar等人(2014年)提出,用于无监督序

列标注任务,受到神经网络自编码器的启发。Cai

等人(2017年)也将这个想法扩展到非神经无监

督依存句法分析。基本思想是首先使用一个判别式

CRF在观察到的句子上生成潜在结构,即POS标签

序列,然后在给定每个潜在结构的情况下重构原始

句子。这两个步骤分别对应编码器和解码器。训练

损失。我们将一个句子表示为x=

x1,x2,...,xi,...,xn,将一个POS标签序列表示为y=

y1,y2,...,yi,...,yn。给定一个不包含任何POS标签序

列的无标签数据集D,训练损失为:

0

L(D;φ,θ)=-∑x∈DlogE[yp(y∣x;φ)]p(x∣y;θ)

0

+λ(∥φ∥22+∥θ∥22),(1)

0

其中p(y∣x;φ)是CRF编码器;p(x∣y;θ)

是解码器;φ和θ是模型参数。这个训练损失鼓励

模型符合这样的直觉:高概率的POS序列也应该具

有高概率的句子重构能力。

0

Ammar等人(2014年)采用期望最大化(EM)算

法进行训练。在这项工作中,我们直接通过前向算

法计算训练损失。然后,我们利用深度学习的强大

AutoGrad函数计算每个参数的梯度。我们在HMM

和特征丰富的HMM上进行的初步实验表明,这种

基于梯度的方法在效率和性能上始终优于EM。

0

+v:mala2277获取更多论文