双AI:深度学习群体活动中的演员交互分析

18 浏览量

更新于2025-01-16

收藏 42.45MB PDF 举报

"双AI:群体活动识别中的双路径演员交互学习"

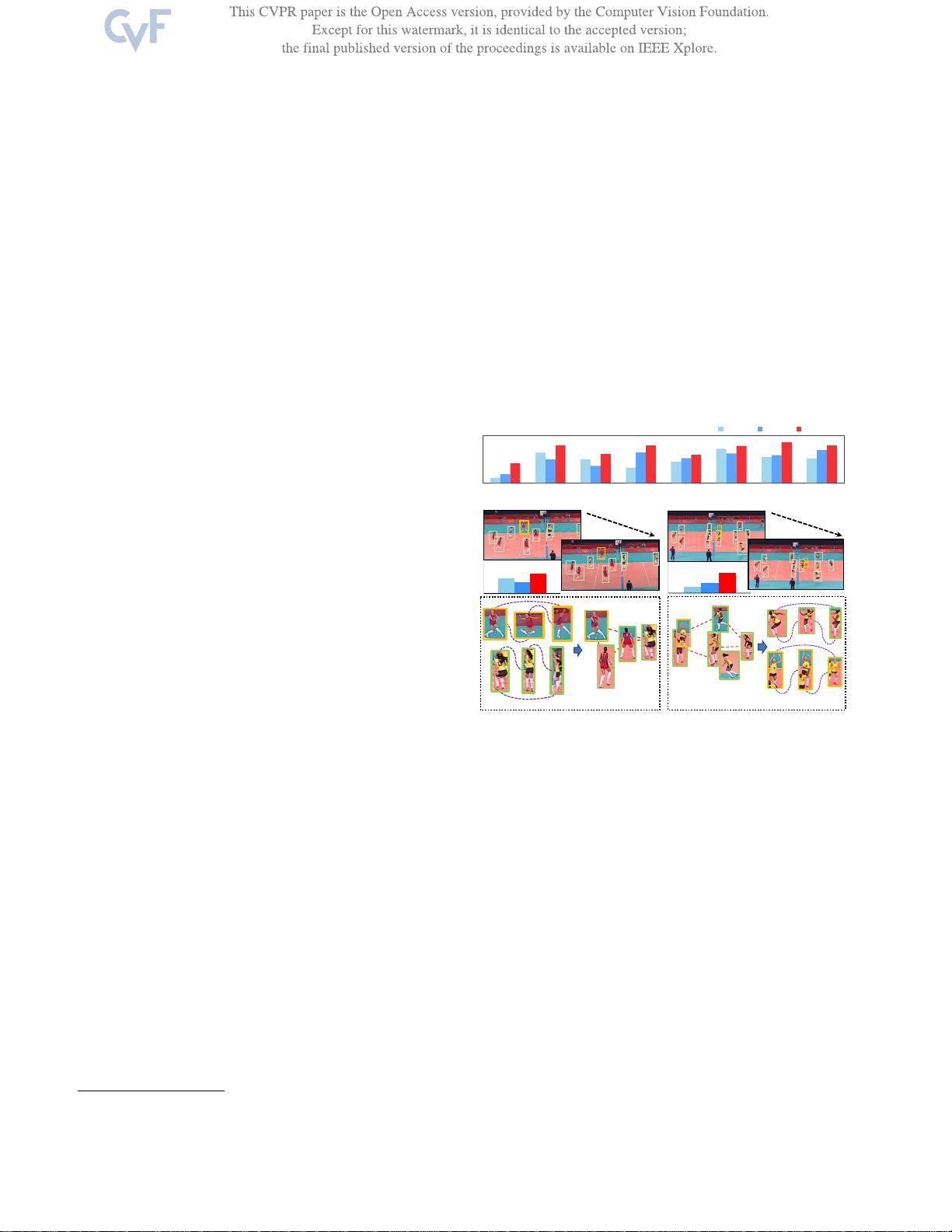

在群体活动识别(Group Activity Recognition,GAR)领域,理解多个参与者之间的交互行为是至关重要的。传统的单一空间或时间顺序的注意力模型往往不足以描述复杂群体活动中多样化的时空交互。双AI是一种新的方法,它通过双路径演员交互学习来提升GAR的准确性与泛化能力。

双路径演员交互学习的核心在于同时考虑空间(Spatial)和时间(Temporal)两个维度的关系。首先,"TSPath"(Temporal-Spatial Path)关注时间序列中的演员动态,它能够捕捉到事件发生的连续性和顺序性,这对于识别时间相关的动作至关重要。例如,"Temporal relation"类别可能表示事件发展的不同阶段或参与者之间的互动顺序。

另一方面,"STPath"(Space-Time Path)侧重于空间上的演员位置变化,它可以揭示演员之间的相对位置关系及其随时间的演变。例如,"r-set"和"l-spike"可能代表不同的空间配置或模式,这些模式对于识别集体活动的特征非常重要。"STPath"有助于理解不同演员如何在空间上相互作用,形成特定的群体行为。

然而,仅依赖单一路径可能会导致信息的丢失,因为复杂的群体活动往往涉及到多样的时空交互。因此,"DualPaths"结合了TSPath和STPath的强项,通过联合优化空间和时间信息,提供更全面的演员交互描述。这种双路径方法可以更准确地捕捉到复杂群体活动中的动态变化和结构。

"尺度演员对比损失"(Scale Actor Contrastive Loss)是另一种增强模型学习的方法,它鼓励模型在不同尺度上区分不同的演员和他们的交互,从而提高识别的鲁棒性和泛化性能。这一损失函数有助于在大规模数据集中学习到更具区分性的特征,使模型能更好地处理不同规模的群体活动。

双AI模型通过双路径演员交互学习和尺度演员对比损失,为群体活动识别带来了显著的进步,提升了对复杂群体行为的理解和识别能力。这种创新方法不仅能够识别个体演员的行为,还能深入理解多个参与者共同构成的集体活动,具有广泛的应用前景,如视频监控、体育赛事分析和社交场合理解等。

548 浏览量

点击了解资源详情

2022-05-20 上传

点击了解资源详情

点击了解资源详情

186 浏览量

133 浏览量

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- 掌握PerfView:高效配置.NET程序性能数据

- SQL2000与Delphi结合的超市管理系统设计

- 冲压模具设计的高效拉伸计算器软件介绍

- jQuery文字图片滚动插件:单行多行及按钮控制

- 最新C++参考手册:包含C++11标准新增内容

- 实现Android嵌套倒计时及活动启动教程

- TMS320F2837xD DSP技术手册详解

- 嵌入式系统实验入门:掌握VxWorks及通信程序设计

- Magento支付宝接口使用教程

- GOIT MARKUP HW-06 项目文件综述

- 全面掌握JBossESB组件与配置教程

- 古风水墨风艾灸养生响应式网站模板

- 讯飞SDK中的音频增益调整方法与实践

- 银联加密解密工具集 - Des算法与Bitmap查看器

- 全面解读OA系统源码中的权限管理与人员管理技术

- PHP HTTP扩展1.7.0版本发布,支持PHP5.3环境