检测到的显著区域中的实例。在本文中,我们提出了

一个显着的实例分割方法,产生一个显着性掩模与不

同的对象实例标签的输入图像。我们的方法包括三个

步骤,估计显著图,检测显著对象轮廓和识别显著对

象实例。对于前两步,我们提出了一个多尺度显着性

细化网络,它生成高质量的显着区域掩模和显着对象

轮廓。一旦与多尺度组合分组和基于

MAP

的子集优化

框架相结合,我们的方法可以产生非常有前途的显著

对象实例分割结果。为了促进显著实例分割的进一步

研究和评价,我们还构建了一个新的数据库,包含

1000

幅图像及其逐像素显著实例标注。实验结果表

明,我们提出的方法是能够

achieev- ing

国家的最先进

的性能在所有公共基准的显著区域检测,以及我们的

新数据集的显著实例分割。

1.

介绍

显著对象检测试图定位图像中最显著和吸引眼球的

对象区域。它是计算机视觉中的一个基本问题,并作

为预处理步骤,以促进广泛的视觉应用,包括内容感

知图像编辑[4],对象检测[38]和视频摘要[36]。

最近,由于深度卷积神经网络的部署,显著对象检

测的 准确 性得 到了快 速提 高[29, 30, 33 ,45]。然

而,大多数先前的方法仅被设计为检测属于任何显著

对象的像素,即,一个密集的显着性图,但不知道显

着对象的个体实例。我们将这些方法执行的任务称为

通讯作者(电子邮件:yizhouy@acm.org)。

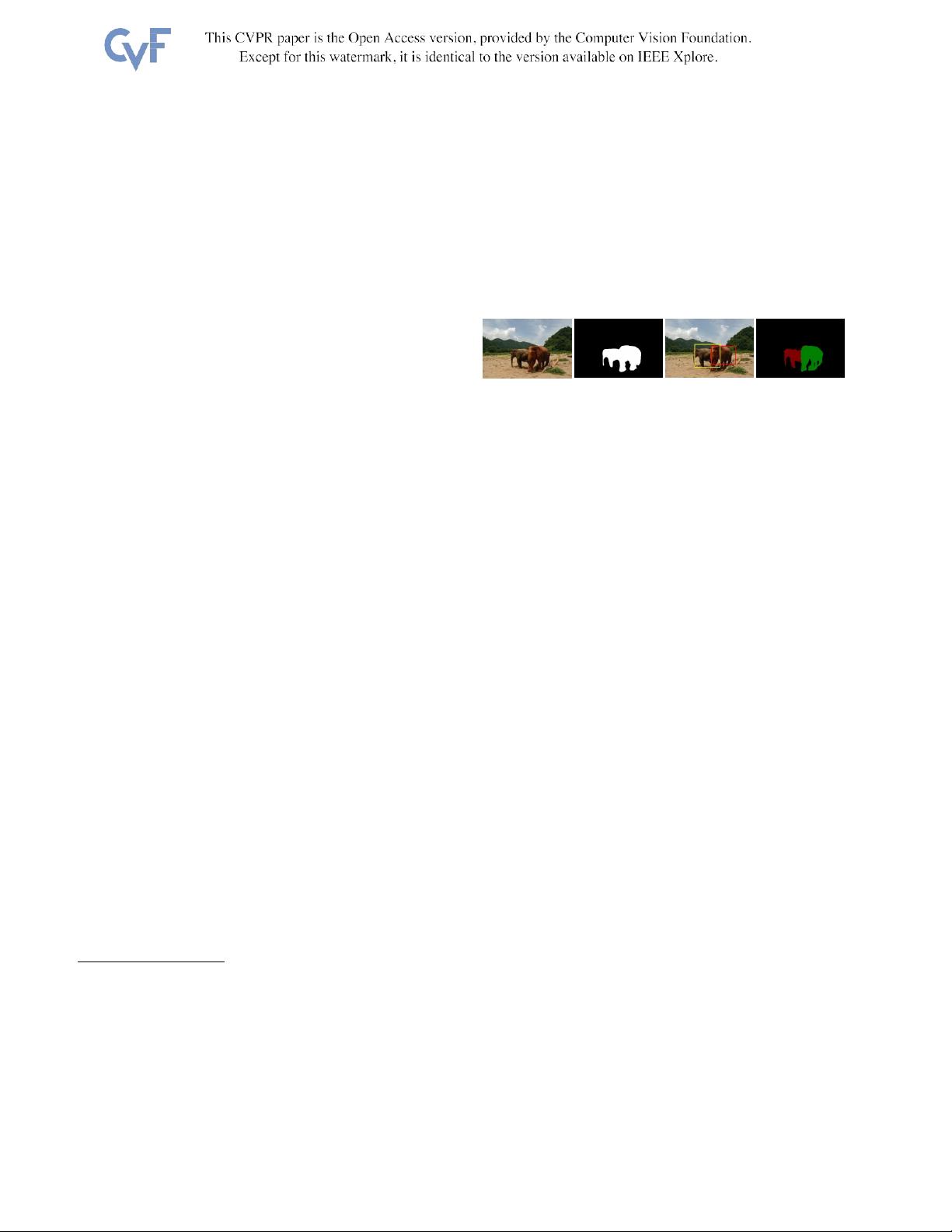

图1.实例级显著对象分段的示例

第左:输入图像。左中:检测到的显著区域。中间右侧:过

滤突出对象建议。右:显著实例分割的结果。不同的颜色指

示检测到的显著区域中的不同对象实例。

区域检测在本文中,我们解决了一个更具挑战性的任

务 , 即 实 例 级 显 著 对 象 分 割 (或 简 称

显 著 实 例 分

割

),其目的是在检测到的显著区域中识别单个对象

实例(图1)。①的人。下一代显著对象检测方法需要

在检测到的显著区域内执行更详细的解析以实现这一

目 标 , 这 对 于 实 际 应 用 至 关 重要 , 包 括 图 像 字 幕

[25],多标签图像识别[46]以及各种弱监督或无监督学

习场景[28,9]。

我们建议将突出实例分割任务分解1)估计二进制显

着图。在该子任务中,预测像素级显著性掩模,指示

输入图像中的显著区域2)检测显著对象轮廓。在这个

子任务中,我们对单个显著对象实例执行轮廓检测。

这样的轮廓检测预期抑制虚假的边界以外的对象轮

廓,并指导显着的对象的建议的生成。3)识别显著对

象实例。在该子任务中,生成显著对象提议,并且选

择显著对象提议的小子集以最好地覆盖显著区域。最

后,基于CRF的细化方法被应用于改善显著对象实例

的空间一致性。

最近的一些论文已经探索了使用全卷积神经网络来

生成显着性掩模[30,33,45]。虽然这些方法是有效

的,并能产生良好的效果,但它们都有自己的局限

性。这些方法中的大多数通过从单个VGG网络的内部

多层结构中学习对比来推断显着性[45,33]。由于它

们的输出是从具有统一大小的接收字段中导出的,因

此它们的性能可能不佳