区别间隔选择:一种主动域自适应方法

114 浏览量

更新于2025-01-16

收藏 1018KB PDF 举报

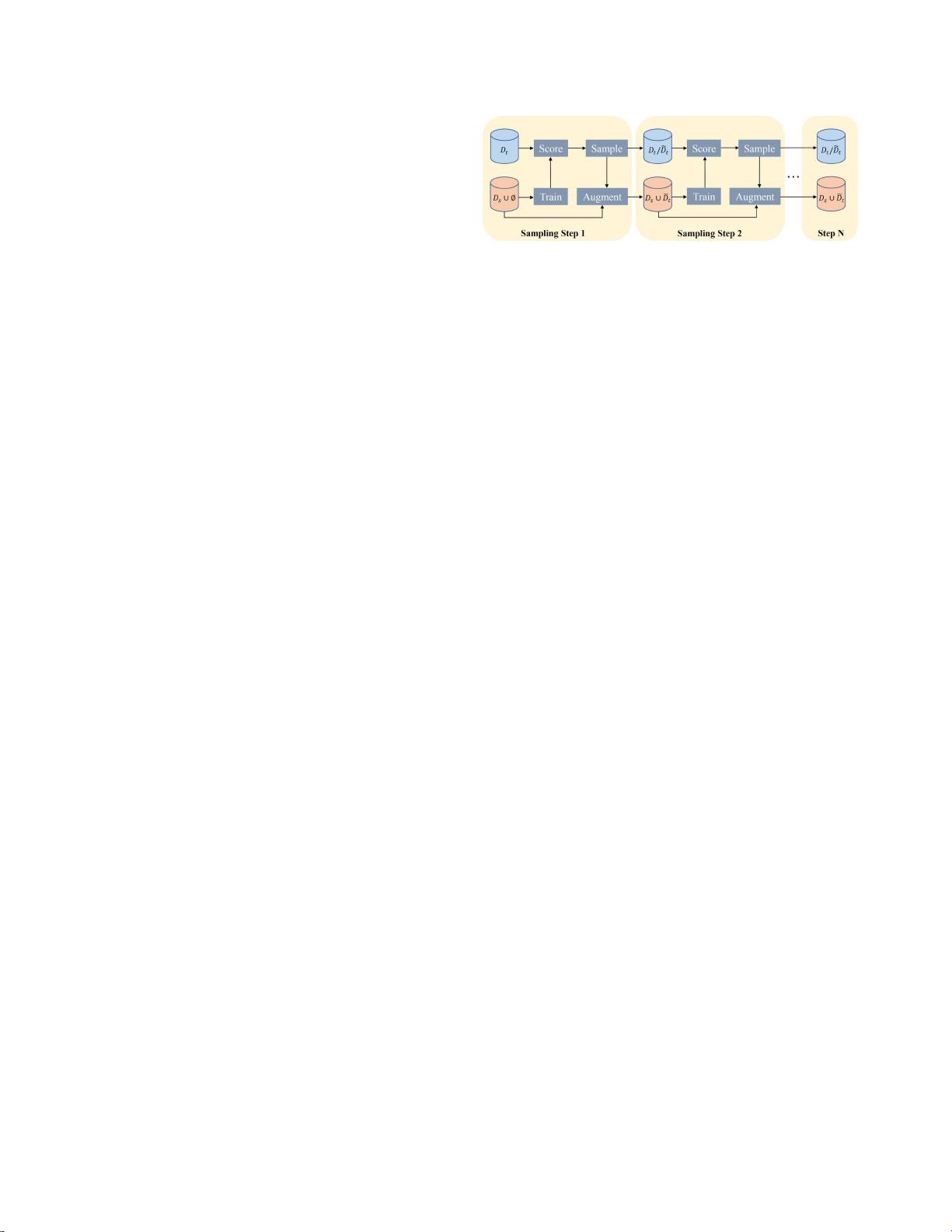

"主动域自适应的区别性裕度学习是一种机器学习方法,旨在解决在源域和目标域之间数据分布存在差距的问题。该方法由复旦大学和腾讯优图实验室的研究人员提出,采用了一种名为按区别间隔选择(SDM)的策略,以有效地处理域间隙并提高模型在有限目标域注释资源条件下的性能。SDM结合了最大间隔损失和间隔采样算法,其理论分析显示该方法类似支持向量机,侧重于存储决策边界附近的困难样本以增强训练。此外,通过边缘损失自适应调整梯度和考虑梯度方向优化边缘采样,SDM进一步提升了选择性。实验证明,SDM在标准主动学习设置下表现出良好的数据可扩展性和竞争力的结果。算法代码可以在指定的GitHub链接获取。"

文章介绍了领域自适应问题在迁移学习中的重要性,特别是在源域和目标域数据分布不一致的情况下,如何有效地将模型从源域迁移到目标域。传统的无监督或少镜头半监督自适应方法可能无法很好地应对这种问题,因此主动域自适应(ADA)成为了一个新的研究焦点。然而,现有的ADA方法常常面临查询函数复杂导致的过拟合风险。

SDM方法则提供了一种简洁且有效的解决方案。首先,它利用最大间隔损失来训练模型,确保模型能够在数据分布差异大的情况下仍能保持良好的泛化能力。其次,间隔采样策略选择那些距离不同分类中心相似距离的未标记数据,这些数据被认为包含丰富的信息并且易于在源域和目标域之间转移。这样的设计有助于模型更好地捕获域间差异,并减少过拟合的风险。

为了进一步提升SDM的性能,研究者提出了两个改进策略。一是基于边缘损失动态调整梯度,这有助于优化模型的训练过程,使得模型能够更准确地捕捉到数据的边界。二是考虑梯度方向,提高了在边缘采样时的选择性,确保选择的样本能最大化模型的学习效果。

实验结果证实,SDM在标准主动学习场景下,即使面对有限的目标域标注数据,也能取得令人满意的效果。其数据可扩展性和竞争力表明SDM是一种有潜力的方法,尤其适用于现实世界中注释资源有限的情况。研究代码的公开,使得其他研究者可以进一步探索和应用这一方法,推动领域自适应技术的发展。

Python环境下基于TensorFlow和Keras的简单域自适应迁移学习轴承故障诊断方法研究与实践,Python环境下基于TensorFlow和Keras的简单域自适应迁移学习轴承故障诊断方法研究

2025-03-05 上传

353 浏览量

4831 浏览量

333 浏览量

177 浏览量

187 浏览量

159 浏览量

259 浏览量

118 浏览量

cpongm

- 粉丝: 6

最新资源

- 网页自动刷新工具 v1.1 - 自定义时间间隔与关机

- pt-1.4协程源码深度解析

- EP4CE6E22C8芯片三相正弦波发生器设计与实现

- 高效处理超大XML文件的查看工具介绍

- 64K极限挑战:国际程序设计大赛优秀3D作品展

- ENVI软件全面应用教程指南

- 学生档案管理系统设计与开发

- 网络伪书:社区驱动的在线音乐制图平台

- Lettuce 5.0.3中文API文档完整包下载指南

- 雅虎通Yahoo! Messenger v0.8.115即时聊天功能详解

- 将Android手机转变为IP监控摄像机

- PLSQL入门教程:变量声明与程序交互

- 掌握.NET三层架构:实例学习与源码解析

- WPF中Devexpress GridControl分组功能实例分析

- H3Viewer: VS2010专用高效帮助文档查看工具

- STM32CubeMX LED与按键初始化及外部中断处理教程