TripleNet:联合检测与分割框架在多任务学习中的优秀表现

PDF格式 | 959KB |

更新于2025-01-16

| 58 浏览量 | 举报

"本文介绍了TripleNet框架在多任务学习中的应用,特别是在联合目标检测和语义分割任务上取得了优异的性能。该框架通过深度连接检测和分割任务,以及引入内部连接模块和注意力跳层融合,实现了两任务之间的相互促进和特征细化。在VOC2007/2012和COCO数据集上的实验结果显示,TripleNet在检测和分割任务上的表现均优于其他一阶段方法。"

在计算机视觉领域,目标检测和语义分割是两个关键任务,它们分别关注识别和定位图像中的物体以及理解物体的类别和边界。尽管已有许多单独处理这些任务的先进算法,但联合检测和分割的需求在自动驾驶、无人机等场景中日益增长,因为这可以提高效率和实时性。传统的做法是分别使用两个独立的网络来执行这两个任务,但这可能导致计算资源的浪费和时间消耗。

针对这一问题,TripleNet提出了一种创新的解决方案。它摒弃了简单的多任务共享网络架构,而是利用检测和分割之间的互补性。通过在解码器的每一层施加面向检测的监督和类感知/类不可知分割监督,TripleNet能够捕捉到不同尺度的信息,这对于检测和分割都至关重要。同时,内部连接模块和注意力跳层融合模块的引入,使得不同尺度的特征能够更好地交叉和细化,从而提升两个任务的性能。

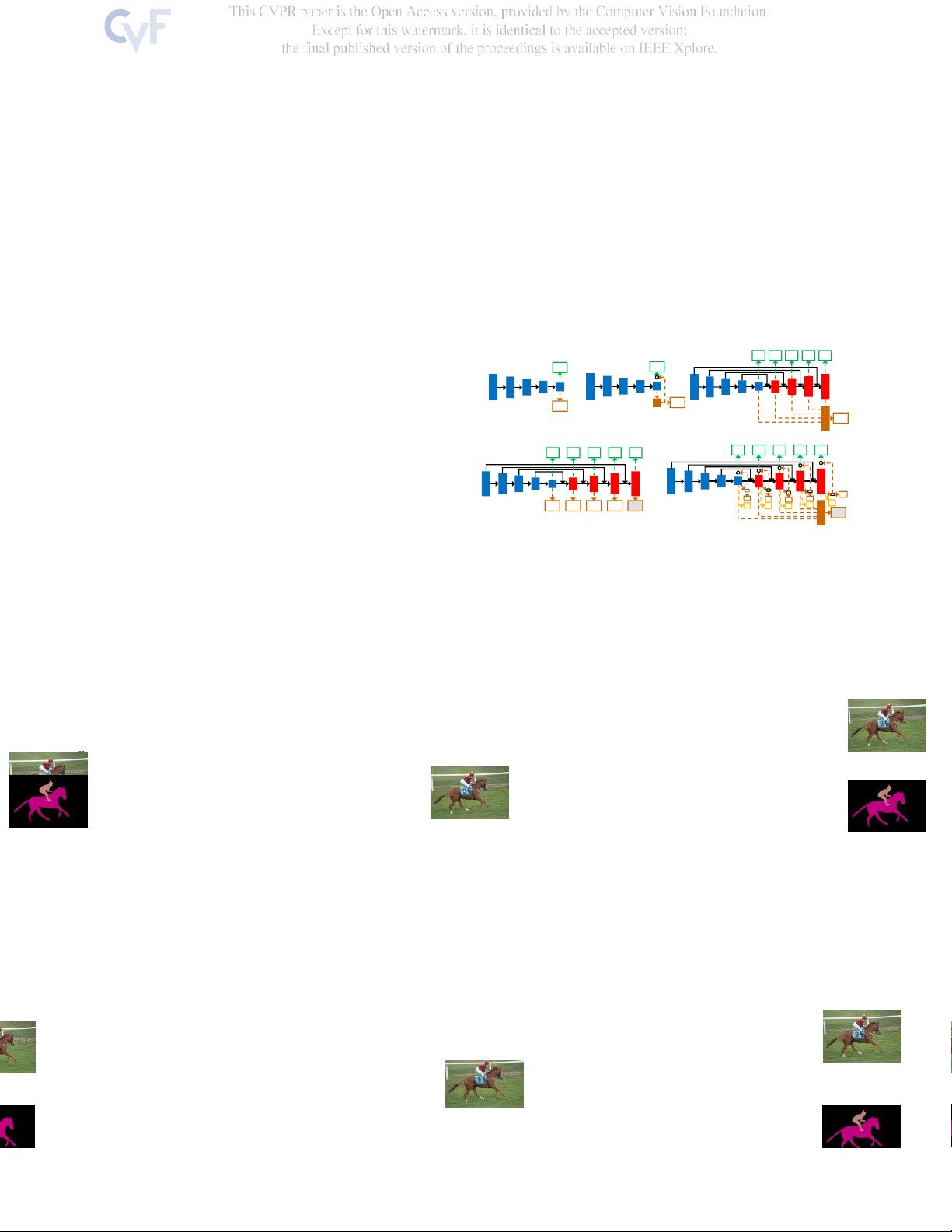

TripleNet的结构设计独特,其解码器的每一层都同时服务于检测和分割,不同于以往仅在最后层添加分支的方案(如图1所示)。这样的设计使得网络能够更有效地利用信息,避免了额外的计算负担。在实际测试中,TripleNet在VOC2012数据集上达到了81.9%mAP的检测精度和83.3%mIoU的分割精度,在COCO数据集上则分别达到了37.1%mAP和59.6%mIoU,这些结果证明了其在联合检测和分割任务上的优越性。

TripleNet是一个强大的联合检测和分割框架,通过多任务学习和任务间的深度交互,实现了性能的显著提升。这种框架不仅在技术上具有创新性,而且对于需要实时处理复杂视觉信息的应用场景,如自动驾驶,具有极大的实用价值。未来的研究可能会进一步优化这种架构,以适应更多任务和更复杂的环境。

相关推荐

8 浏览量

7 浏览量

4 浏览量

cpongm

- 粉丝: 6

最新资源

- A7Demo.appstudio:探索JavaScript应用开发

- 百度地图范围内的标注点技术实现

- Foobar2000绿色汉化版:全面提升音频播放体验

- Rhythm Core .NET库:字符串与集合扩展方法详解

- 深入了解Tomcat源码及其依赖包结构

- 物流节约里程法的文档整理与实践分享

- NUnit3.vsix:快速安装NUnit三件套到VS2017及以上版本

- JQuery核心函数使用速查手册详解

- 多种风格的Select下拉框美化插件及其js代码下载

- Mac用户必备:SmartSVN版本控制工具介绍

- ELTE IK Web编程与Web开发课程内容详解

- QuartusII环境下的Verilog锁相环实现

- 横版过关游戏完整VC源码及资源包

- MVC后台管理框架2021版:源码与代码生成器详解

- 宗成庆主讲的自然语言理解课程PPT解析

- Memcached与Tomcat会话共享与Kryo序列化配置指南