GLTR: 视频人物重识别的全局-局部时间表示与性能分析

PDF格式 | 1.51MB |

更新于2025-01-16

| 91 浏览量 | 举报

本文主要探讨了视频人物重识别领域的创新方法——全局-局部时间表示(GLTR),由李佳宁、王敬东、田琦、高文和张世良这几位来自北京大学和华为诺亚方舟实验室的研究者提出。GLTR旨在通过综合处理视频序列中的多尺度时间线索,提升视频人物识别的性能,尤其是在解决遮挡和噪声问题上。

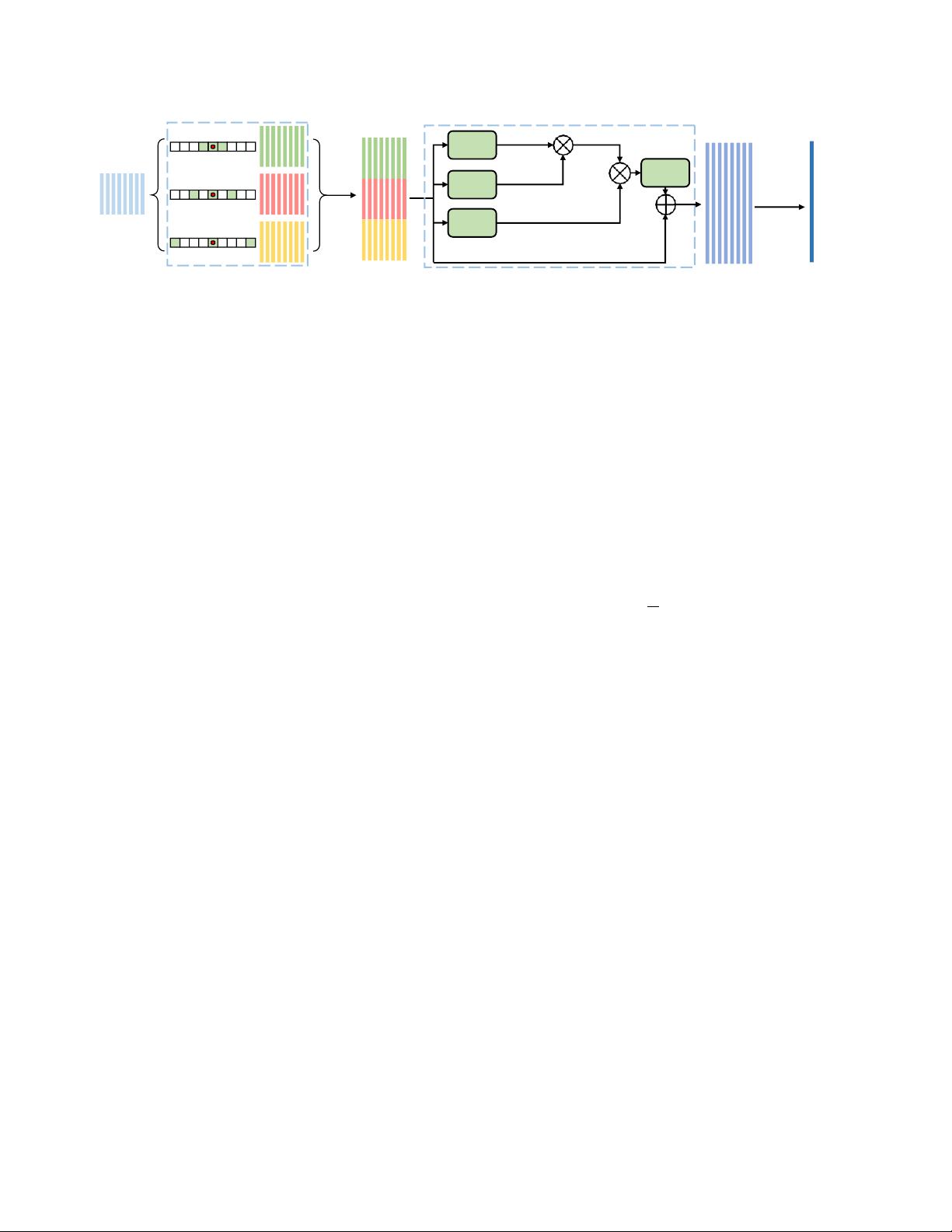

GLTR方法的核心思想是首先聚焦于短时间尺度上的局部时间线索,即利用parallel-dilated卷积网络对相邻帧之间的运动模式和速度变化进行建模,捕捉行人个体的动态特征。这种技术有助于区分那些穿着相似衣物但动作各异的个体,如图1所示的两个在MARS数据集中外观相似但行为不同的行人。

其次,GLTR引入了时间自注意力模型,这一模型能够处理视频序列中的长期关系,即使在存在遮挡和噪声的情况下也能保持稳定的表现。它通过对不连续帧间的联系进行建模,增强了模型对复杂时空场景的理解和适应能力。

值得注意的是,GLTR并没有依赖额外的CNN输入,如光流,而是通过单一的卷积神经网络(CNN)将短期和长期时间线索整合在一起,形成最终的表示。这种设计简化了模型架构,提高了效率。实验结果显示,GLTR在MARS数据集上实现了87.02%的Rank-1准确度,显示出其在性能上的显著优势,超越了当时的最新技术。

GLTR方法代表了视频人物重识别领域的一个重要突破,它强调了时间线索的有效利用和复杂时空关系的捕捉,对于提高视频监控和刑事侦查等实际应用中的人员再识别能力具有重要意义。未来的研究可能进一步探索如何结合更多元的时间特征和空间信息,以实现更高的识别精度。

相关推荐

8 浏览量

7 浏览量

4 浏览量

cpongm

- 粉丝: 6

最新资源

- VB通过Modbus协议控制三菱PLC通讯实操指南

- simfinapi:R语言中简化SimFin数据获取与分析的包

- LabVIEW温度控制上位机程序开发指南

- 西门子工业网络通信实例解析与CP243-1应用

- 清华紫光全能王V9.1软件深度体验与功能解析

- VB实现Access数据库数据同步操作指南

- VB实现MSChart绘制实时监控曲线

- VC6.0通过实例深入访问Excel文件技巧

- 自动机可视化工具:编程语言与正则表达式的图形化解释

- 赛义德·莫比尼:揭秘其开创性技术成果

- 微信小程序开发教程:如何实现模仿ofo共享单车应用

- TrueTable在Windows10 64位及CAD2007中的完美适配

- 图解Win7搭建IIS7+PHP+MySQL+phpMyAdmin教程

- C#与LabVIEW联合采集NI设备的电压电流信号并创建Excel文件

- LP1800-3最小系统官方资料压缩包

- Linksys WUSB54GG无线网卡驱动程序下载指南