VSGN:跨尺度视频自拼接解决时间动作定位难题

PDF格式 | 1.02MB |

更新于2025-01-16

| 198 浏览量 | 举报

视频自拼接图网络(Video Stitching Graph Network,VSGN)是一种创新的方法,旨在解决视频时间动作定位(Temporal Action Localization,TAL)这一具有挑战性的任务。TAL在当前互联网视频内容爆炸的时代中变得越来越重要,因为它不仅有助于在体育赛事中捕捉精彩瞬间,还为视频检索、字幕生成等高级任务提供了基础。

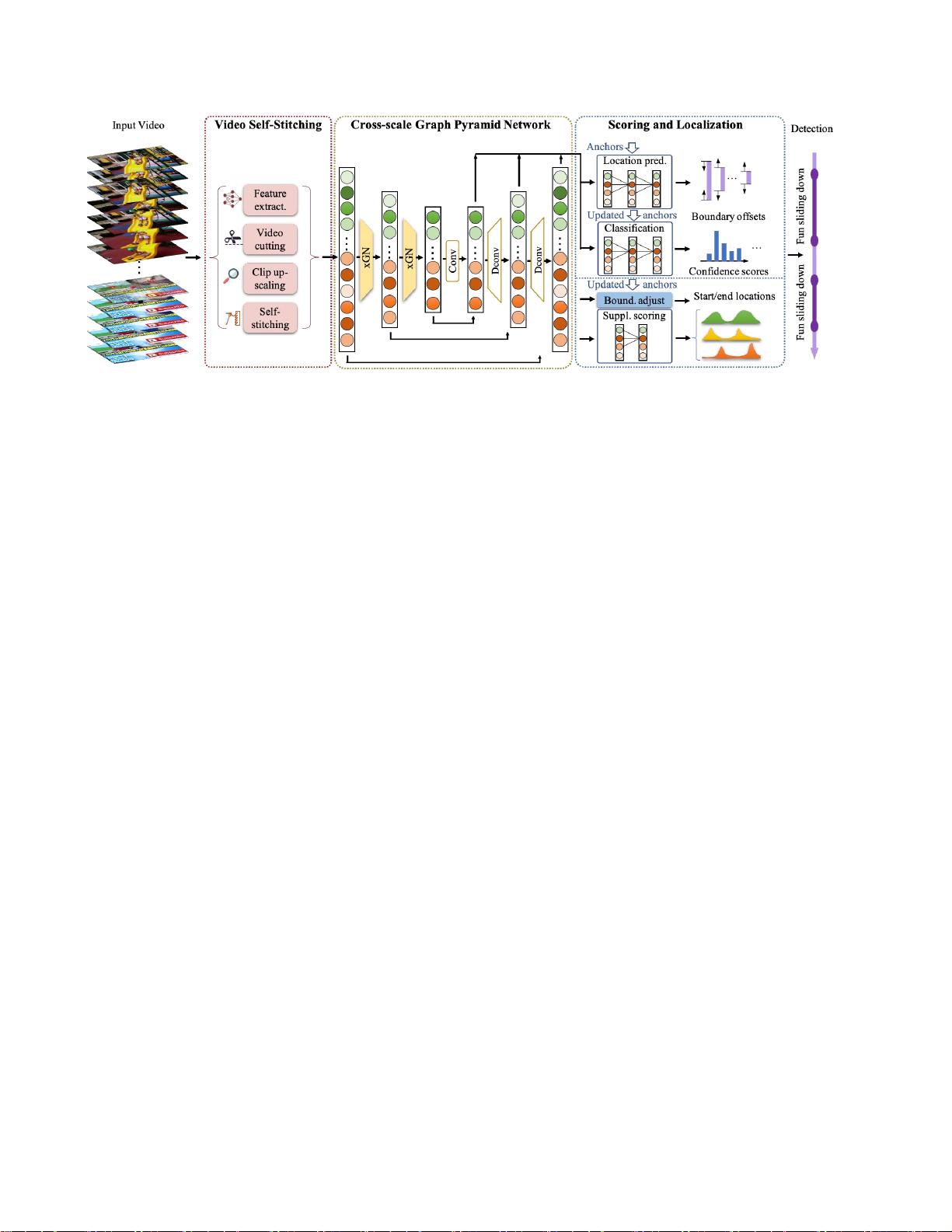

VSGN的设计重点在于应对视频动作时间尺度的广泛变化,尤其是针对短动作的处理。传统的TAL数据集中,短动作数量众多,但往往伴随着较低的定位精度。为了克服这个难题,VSGN采用了多层次的跨尺度策略,包括视频自缝合(Video Self-Stitching,VSS)和跨尺度图金字塔网络(Cross-Scale Graph Pyramid Network,xGPN)两个关键组件。

在VSS模块中,研究人员通过对视频进行局部放大和时间维度上的拼接,使得模型能够利用不同尺度间的互补特性,捕捉到动作的不同阶段。这种处理方式有效地增强了特征表示,特别对于那些难以被传统方法有效处理的短动作。

xGPN则进一步通过构建跨尺度图金字塔结构,利用多尺度的上下文信息来增强特征融合。它包含混合模块,可以同时聚合来自不同尺度的特征以及同一尺度内的信息,这有助于提高对动作位置和类别的准确判断。

VSGN的贡献在于它显著提升了TAL的性能,特别是在THUMOS-14和ActivityNet-v1.3等基准测试上,实现了与现有最先进的方法相当甚至超越的定位精度。特别值得注意的是,VSGN对于短动作的处理效果显著优于传统方法,证明了其在实际应用中的优势。

VSGN的出现标志着在视频理解领域,特别是在处理时间动作定位问题上,跨尺度和自适应策略的重要性得到了深入研究和应用。它代表了一种新的解决方案,对于推动该领域的技术发展和实际应用具有重要意义。VSGN的源代码可以在[https://github.com/coolbay/VSGN](https://github.com/coolbay/VSGN)获取,可供其他研究者参考和进一步优化。

相关推荐

131 浏览量

cpongm

- 粉丝: 6

最新资源

- Web远程教学系统需求分析指南

- 禅道6.2版本发布,优化测试流程,提高安全性

- Netty传输层API中文文档及资源包免费下载

- 超凡搜索:引领搜索领域的创新神器

- JavaWeb租房系统实现与代码参考指南

- 老冀文章编辑工具v1.8:文章编辑的自动化解决方案

- MovieLens 1m数据集深度解析:数据库设计与电影属性

- TypeScript实现tca-flip-coins模拟硬币翻转算法

- Directshow实现多路视频采集与传输技术

- 百度editor实现无限制附件上传功能

- C语言二级上机模拟题与VC6.0完整版

- A*算法解决八数码问题:AI领域的经典案例

- Android版SeetaFace JNI程序实现人脸检测与对齐

- 热交换器效率提升技术手册

- WinCE平台CPU占用率精确测试工具介绍

- JavaScript实现的压缩包子算法解读