编码器,因此可以非常有效地利用大的负样

本大小进行训练。例如,

RotatE

1

的默认配置

在Wikidata5M数据集上训练了1000个epoch,

负样本大小为

64

而基于文本的方法

KEPLER

(Wang et al. ,2021 c)由于RoBERTa引起的

高计算成本,只能训练负样本大小为

1

的

30

个

历元

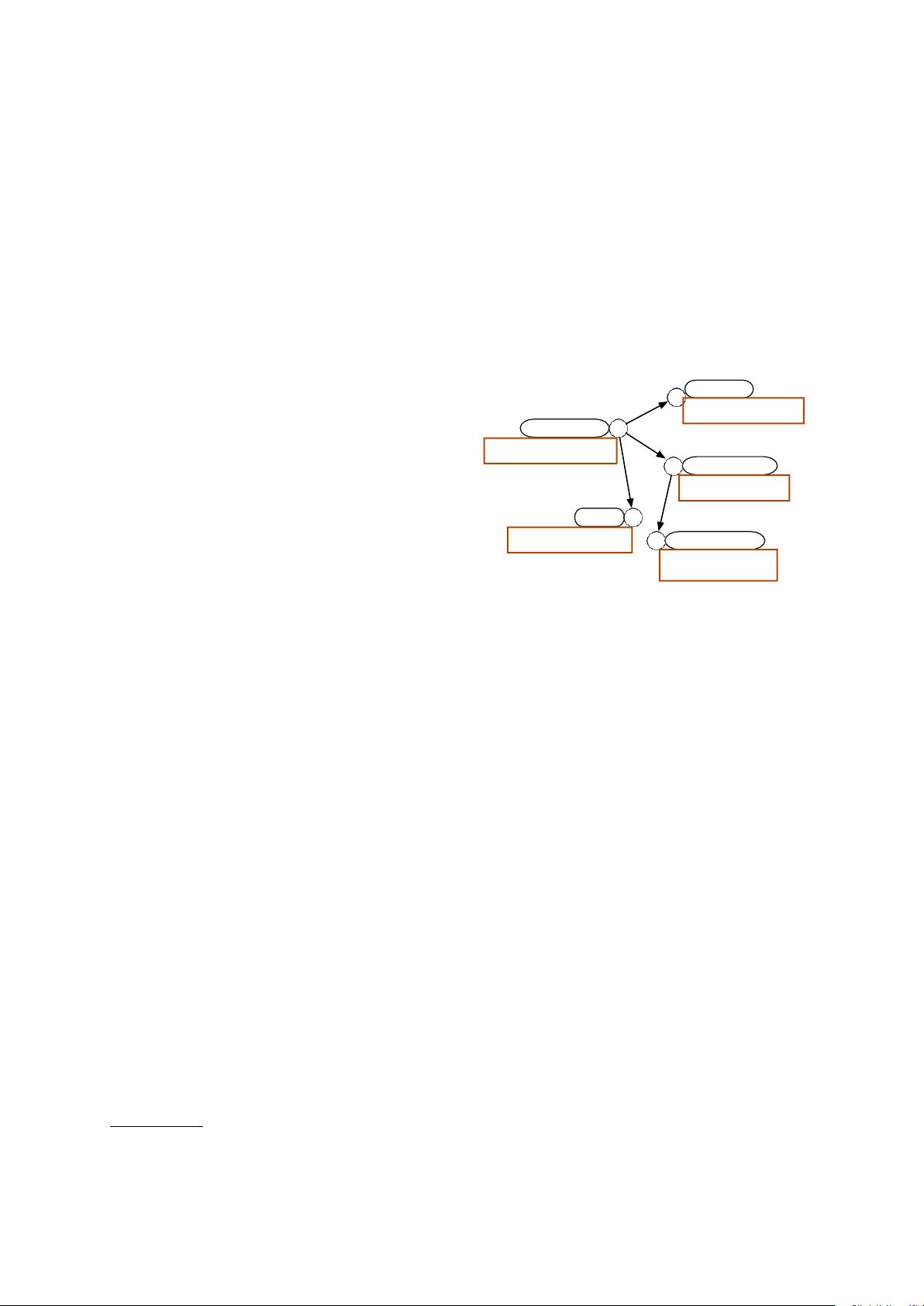

在本文中,受对比学习的最新进展的启发,

我们引入了三种类型的否定来改进基于文本的

KGC

方 法 : 批 内 否定,批前否定和自我否

定。 通过采 用双向编码器代替 交叉编码器

(

Yao et al.

,

2019

)架构,可以通过使用更

大的批量大小来增加批内底片的数量。 来自

先 前 批 次 的载体被 缓 存 并 用 作 预 批 次 阴 性

(Karpukhinet al. ,2020)。此外,挖掘硬否

定可以有益于改善对比学习。我们发现,头部

实体本身可以作为硬否定,我们称之为因此,

负样本量可以增加到数千人的规模我们还建议

将 损 失 函 数 从 基 于 边 缘 的 排 名 损 失 改 为

InfoNCE,这可以使模型专注于硬否定。

基于文本的方法的一个优点是,它们使归纳

实体表示学习成为可能。在训练过程中看不到

的实体仍然可以被适当地建模,而基于嵌入的

方法,如

transE

,只能在转换设置下推理。归

纳知识图的完成在现实世界中很重要,因为每

天都有新的实体出现。此外,基于文本的方法

可以利用最先进的预训练语言模型来学习更好

的表示。 最近 的一 系列工作(

Shin et al.

,

2020; Petroni et al.

,

2019

)试图从

BERT

中提

取隐含存储的知识

KGC

的任务也可以被视为

检索这些知识的一种方式。

如果两个实体通过图中的短路径连接,则它

们更可能相关经验上,我们发现基于文本的模

型严重依赖于语义匹配,并在一定程度上忽略

了这种拓扑偏见。我们提出了一个简单的重新

排名策略,通过提高头实体的k跳邻居的分数

我们评估我们提出的模型

SimKGC

,

1

https://github.com/DeepGraphLearning/

石墨矿

2

测试集中的所有实体也会出现在训练集中。

在 三 个流 行 的 基 准 点 上 进 行 实 验 :WN 18

RR

,

FB 15 k-237

和

Wikidata 5 M

(包括传导和

感应 设 置 )。 根 据 自动 评 估 指标 ( MRR,

Hits@{1

,

3

,

10}

),

SimKGC

在

WN 18 RR

(MRR 47)上的表现远 远优 于最先进的方

法

。

六 百 六 十 六

。

6

) ,

Wikidata5M

transductive set- ting(MRR 29. 035 8)和感应

设置(

MRR 49. 371. 4

)。 在

FB 15 k-237

数据

集上,我们的结果也具有竞争力。为了帮助更

好地理解我们提出的方法,我们进行了一系列

的分析和报告人类的评估结果。希望SimKGC

能够促进未来更好的

KGC

系统的开发。

2

相关工作

知识图完成涉及建模多关系数据,以帮助大规

模KG的自动构建。在基于翻译的方法中,例

如 TransE ( Bordes et al. , 2013 ) 和 TransH

(Wang et al. ,2014),三元组(h,r,t)

是从头实体

h

到尾实体

t

的

特定于关系的转换。

Trouillon等人引入了复数嵌入。(2016年),

以增加模型的表现力。RotatE(Sun et al. ,

2019年b)模型三元组作为复杂空间中的关系

旋转。

Nickel

等人(

2011

)

;Balazevic

等人

(

2019

)将

KGC

视为

3-D

二元张量因子分解问

题,并研究了几种因子分解技术的有效性有些

方法试图合并实体描述。DKRL(Xie et al. ,

2016 ) 使 用 CNN 对 文 本 进 行 编 码 , 而 KG-

BERT(Yaoet al. ,2019),StAR( Wang et

al.

,

2021a

)和

BLP

(

Daza et al.

,

2021

)都采

用预先训练的语言模型来计算实体嵌入。圣杯

(Teru et al. ,2020)和BERTRL (查 等

人,2021)利用子图或路径信息进行归纳关系

预测。 在基准性能方面(Wang et al. ,2021

c

), 基 于 文 本的 方 法 仍然 不 如

RotatE

等方

法。

预 训 练 的 语 言 模 型, 包括 BERT( Devlin et

al. ,2019)、GPT(Radford et al. ,2018)和

T5

(

Raffel et al.

,

2019

)导致了

NLP

的学习范

式转变模型首先在具有语言建模目标的大量未

标记文本语料库上进行预训练,然后在下游任

务上进行微调。考虑到他们在少镜头甚至零镜

头