堆叠混合注意力与组协作学习提升无偏场景图生成性能

PDF格式 | 13.03MB |

更新于2025-01-16

| 139 浏览量 | 举报

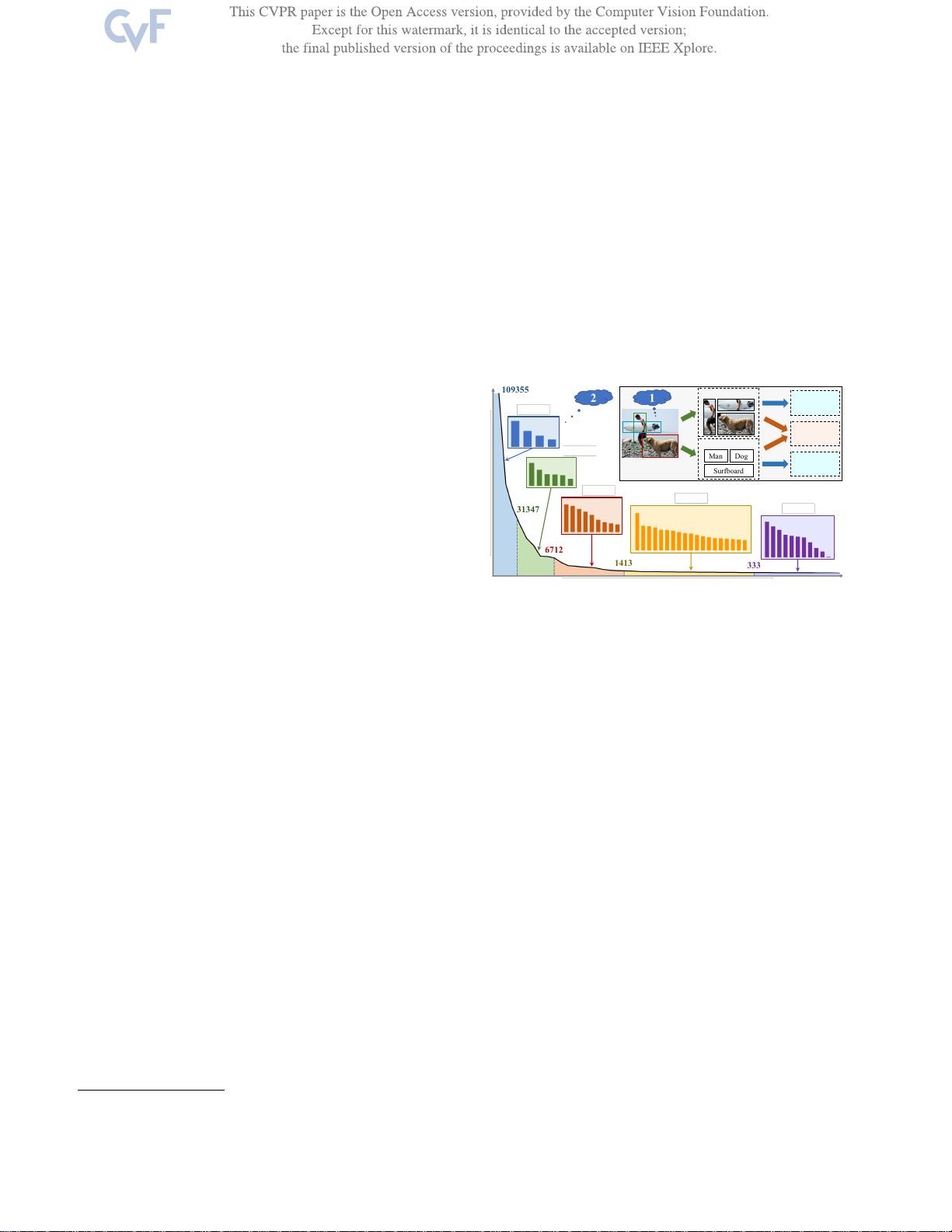

堆叠混合注意力和组协作学习用于无偏场景图生成是一篇关注于改进场景图生成(Scene Graph Generation,SGG)性能的研究论文。SGG作为一项关键的视觉理解任务,旨在从给定的图像中识别对象并建立它们之间的关系,以形成一个简洁的图结构,这对于许多跨模态任务如检索、图像字幕生成和视觉问答至关重要。然而,当前的方法存在两大挑战:一是模态融合不足,即视觉和语言信息未能有效结合;二是关系预测存在偏差,导致生成的图缺乏全面性。

该研究首先提出了一种创新的堆叠混合注意力网络(Stacked Mixed Attention Network),它通过多层次的设计,增强了模态内部的细节捕捉和模态间的交互。这个网络在编码阶段起到了重要作用,通过同时处理视觉和语言特征,促进了信息的深度融合,从而提高生成场景图的质量。

针对关系预测的偏见问题,研究者们设计了一种组协作学习策略。他们注意到,现有模型在处理不平衡数据集时,尤其是关系类别分布不均时,性能受限。因此,他们采用了分组策略,训练一组专门处理不同类别关系的分类器,这些分类器能够更有效地识别各类关系。然后,通过合作优化,这些分类器在保持各自优势的同时,共同提高整体的无偏关系预测能力。

在实验部分,论文在Visual Genome和GQA数据集上进行了验证,结果显示,新提出的堆叠混合注意力和组协作学习方法显著提升了无偏场景图生成的性能,不仅在无偏度量上达到新的领先水平,而且与现有基准相比,性能提升接近翻倍。这表明了该方法的有效性和实用价值。研究人员还提供了代码仓库供其他研究者参考和进一步发展,地址为<https://github.com/dongxingning/SHA-GCL-for-SGG>。

这篇论文为解决场景图生成中的模态融合和关系预测偏见问题提供了一种创新方法,展示了堆叠混合注意力网络和组协作学习在提升任务性能方面的潜力,对于推动场景图生成技术向更真实、更全面的应用场景迈进具有重要意义。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 计算机组成原理期末试题及答案(2011参考)

- 均值漂移算法深入解析及实践应用

- 掌握npm与yarn在React和pg库中的使用

- C++开发学生信息管理系统实现多功能查询

- 深入解析SIMATIC NET OPC服务器与PLC的S7连接技术

- 离心式水泵原理与Matlab仿真教程

- 实现JS星级评论打分与滑动提示效果

- VB.NET图书馆管理系统源码及程序发布

- C#实现程序A监控与自动启动机制

- 构建简易Android拨号功能的应用开发教程

- HTML技术在在线杂志中的应用

- 网页开发中的实用树形菜单插件应用

- 高压水清洗技术在储罐维修中的关键应用

- 流量计校正方法及操作指南

- WinCE系统下SD卡磁盘性能测试工具及代码解析

- ASP.NET学生管理系统的源码与数据库教程