自动增强器AIM:图像与网格的智能变形提升深度学习性能

PDF格式 | 16.71MB |

更新于2025-01-16

| 191 浏览量 | 举报

本文主要探讨的是一个名为"AIM: 适用于图像和网格的自动增强器"的新颖技术,该技术旨在提高深度神经网络在计算机视觉任务中的鲁棒性和性能。传统的数据增强方法,如仿射变换、随机翻转和裁剪,通常是非学习性的,与特定任务无关,且不易于在不同数据维度间通用。然而,AIM的创新之处在于它将增强过程与网络学习过程相结合,通过与神经网络共同优化,实现对输入数据的约束非刚性变形。

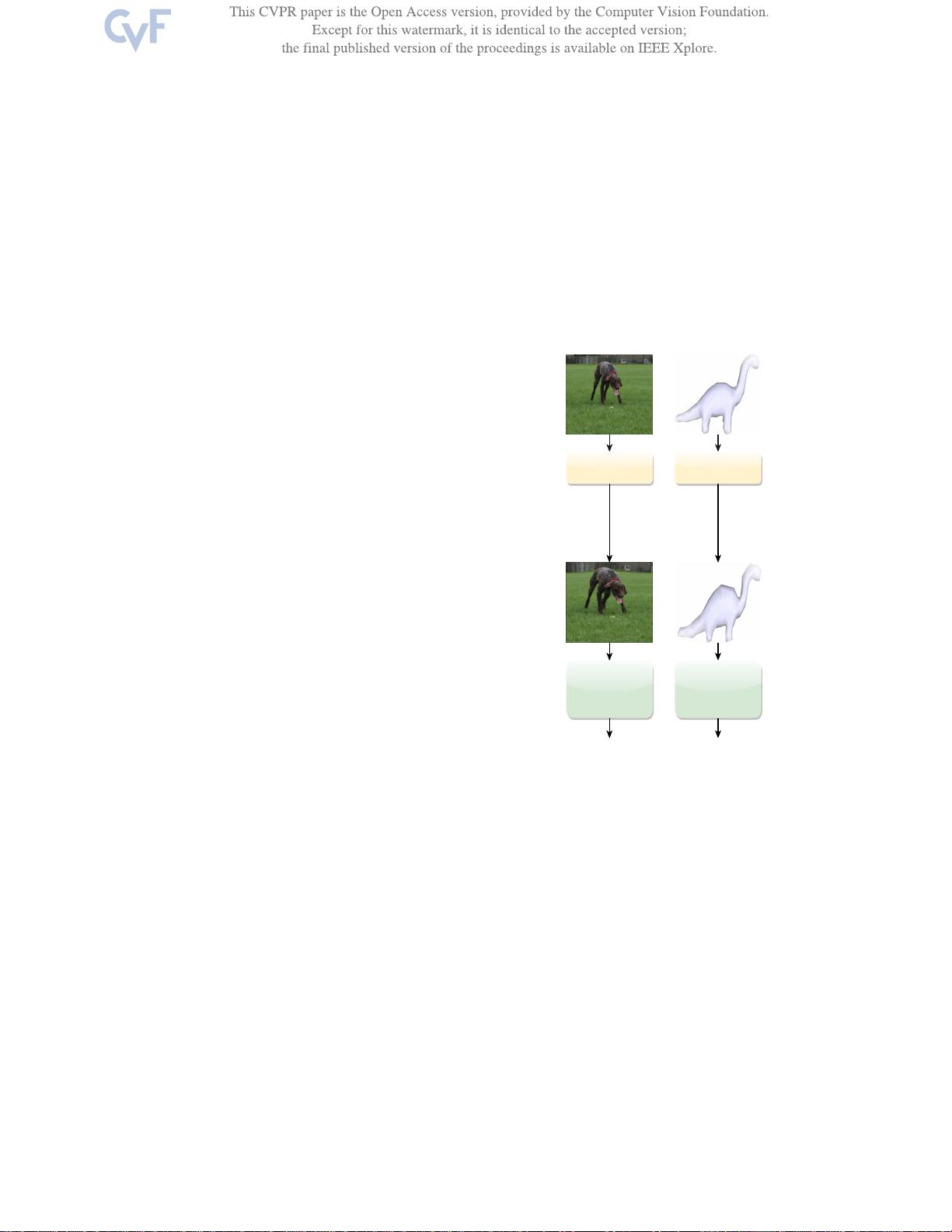

在介绍部分,文章指出深度学习虽然在计算机视觉领域表现出色,但其鲁棒性仍有待提升,因为深度网络需要理解对象的视觉特征和其在空间中的位置。为了提高这种理解,传统的增强方法往往是预先设定好的,缺乏针对任务的定制性。AIM的出现正是为了解决这个问题,它可以根据特定任务预测出最适合的数据增强,比如在图像中增加狗的可见区域或在3D网格中扩大恐龙头部、背部和尾部的覆盖范围。

AIM的工作原理是,在训练和推理阶段,对输入数据进行动态的、任务感知的非刚性变形,以增强网络对变化的适应性。这种方法不仅增强了数据的多样性,还能够帮助网络学习到更丰富的特征表示。图1展示了AIM在图像和网格上的应用实例,它能够有效扩展到不同类型的视觉数据,并证明了其在多种网络架构中的有效性。

与传统的增强方法不同,AIM不是简单的预处理步骤,而是作为一个可学习组件嵌入到网络中,能够随着网络的训练而不断优化。这使得增强过程更具针对性,提高了任务的有效性。AIM的提出标志着数据增强方法的一个重要进步,它有望在未来的研究中推动深度学习在计算机视觉领域的进一步发展。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 自动生成CAD模型文件的测试流程

- 掌握JavaScript中的while循环语句

- 宜科高分辨率编码器产品手册解析

- 探索3CDaemon:FTP与TFTP的高效传输解决方案

- 高效文件对比系统:快速定位文件差异

- JavaScript密码生成器的设计与实现

- 比特彗星1.45稳定版发布:低资源占用的BT下载工具

- OpenGL光源与材质实现教程

- Tablesorter 2.0:增强表格用户体验的分页与内容筛选插件

- 设计开发者的色值图谱指南

- UYA-Grupo_8研讨会:在DCU上的培训

- 新唐NUC100芯片下载程序源代码发布

- 厂家惠新版QQ空间访客提取器v1.5发布:轻松获取访客数据

- 《Windows核心编程(第五版)》配套源码解析

- RAIDReconstructor:阵列重组与数据恢复专家

- Amargos项目网站构建与开发指南